서비스 메시 (Service Mesh)

아래는 " 서비스 메시 (Service Mesh)" 에 대한 IT 백엔드 개발자 관점의 포괄적 조사 결과입니다.

1. 태그

- Service-Mesh

- Microservices-Architecture

- Cloud-Native

- DevOps-Infrastructure

2. 분류 구조 분석

분류:

Computer Science and Engineering > DevOps and Infrastructure > Cloud Native Platforms

분석 및 근거:

서비스 메시는 마이크로서비스 기반 클라우드 네이티브 시스템에서 서비스 간 통신, 관리, 보안, 관찰 가능성 (Observability) 등을 인프라 계층에서 담당하는 핵심 기술이다. DevOps 관점에서 자동화, 모니터링, 배포 관리 등과 밀접하며, Cloud Native Platforms(쿠버네티스 등) 환경에서 표준처럼 사용되고 있다. 따라서 제시된 분류 구조는 적절하다 13.

3. 요약 (200 자 이내)

서비스 메시는 마이크로서비스 환경에서 서비스 간 통신을 관리하는 인프라 계층으로, 비즈니스 로직과 네트워크 관리를 분리해 개발 효율성과 시스템 안정성을 높인다 12.

4. 개요 (250 자 이내)

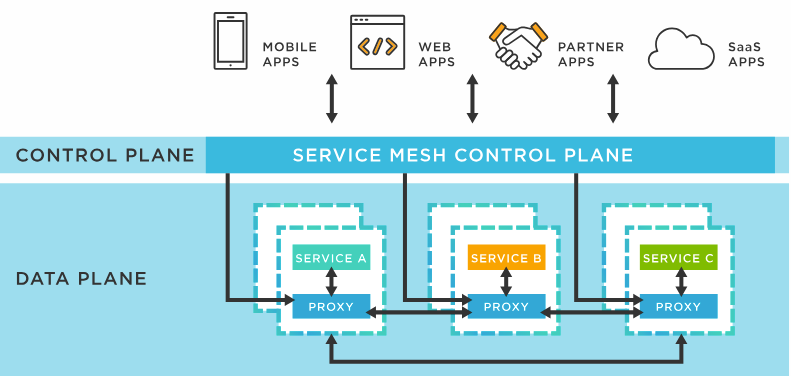

서비스 메시는 마이크로서비스 아키텍처에서 서비스 간 통신을 제어·관리·모니터링하는 전용 인프라 계층이다. 사이드카 프록시와 컨트롤 플레인으로 구성되며, 트래픽 관리, 보안, 관찰 가능성 등 핵심 기능을 제공한다 15.

5. 핵심 개념 및 실무 구현 요소

핵심 개념

- 서비스 메시 (Service Mesh): 마이크로서비스 간 통신을 관리하는 인프라 계층. 각 서비스 옆에 사이드카 프록시를 배치, 네트워크 로직을 애플리케이션 코드와 분리 12.

- 마이크로서비스 (Microservices): 애플리케이션을 독립적 서비스로 분할, 개발·배포·확장성을 높임 1.

- 사이드카 패턴 (Sidecar Pattern): 서비스와 함께 프록시 컨테이너를 배치, 네트워크 통신을 대신 처리 27.

- 데이터 플레인 (Data Plane): 실제 트래픽 처리 (프록시), 라우팅, 로드 밸런싱, 보안 등 29.

- 컨트롤 플레인 (Control Plane): 정책 관리, 설정 전달, 프록시 관리 29.

실무 구현 요소

- 프록시 (Proxy): Envoy, Linkerd 등. 실제 트래픽 처리.

- 컨트롤 플레인: Istio, Consul 등. 정책 및 설정 관리.

- 관찰 가능성 (Observability): Jaeger, Kiali 등. 모니터링, 로깅, 트레이싱.

- 보안: mTLS, 인증/인가.

- 트래픽 관리: 라우팅, 로드 밸런싱, 서킷 브레이커.

- 서비스 디스커버리: 동적 서비스 등록/검색.

6. 조사 내용

배경

- 복잡성 증가: 마이크로서비스 수가 늘어나면서 서비스 간 통신, 장애 추적, 보안, 모니터링이 복잡해짐 1[11].

- 네트워크 로직 분리 필요: 애플리케이션 코드에서 네트워크 로직 분리 필요성 대두 [4][12][13].

목적 및 필요성

주요 기능 및 역할

- 트래픽 관리: 라우팅, 로드 밸런싱, 속도 제한 2[14].

- 보안: mTLS, 인증/인가, 암호화 29.

- 관찰 가능성: 모니터링, 로깅, 분산 트레이싱 [2]14.

- 장애 복구: 서킷 브레이커, 리트라이, 타임아웃 210.

- 서비스 디스커버리: 동적 서비스 등록/검색 2[15].

특징

- 인프라 계층: 애플리케이션 코드와 분리된 전용 계층 12.

- 분산형 아키텍처: 중앙 집중형이 아닌 분산형 구조 [2][13].

- 언어/프레임워크 독립적: 다양한 언어/플랫폼 지원 [7][12].

핵심 원칙

- 비즈니스 로직과 네트워크 로직 분리

- 관찰 가능성 확보

- 자동화 및 확장성 보장

- 보안 강화

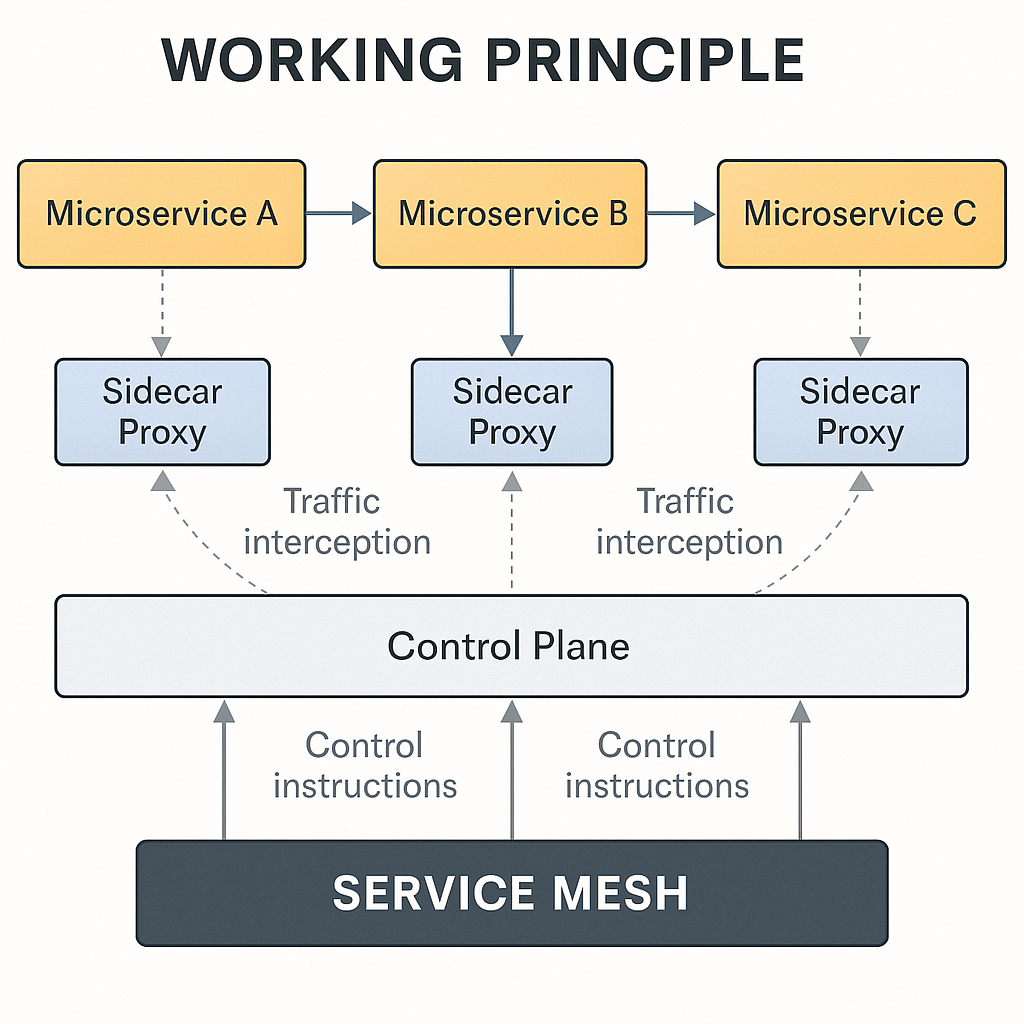

주요 원리 및 작동 원리

주요 원리

- 프록시 기반 통신: 각 서비스에 사이드카 프록시 배치, 모든 트래픽을 프록시가 처리 2[15].

- 정책 기반 관리: 컨트롤 플레인에서 정책을 정의, 데이터 플레인에 적용 2[15].

- 분산 추적 및 모니터링: 모든 트래픽을 관찰 가능하게 함 [2]14.

작동 원리 다이어그램

graph LR

A[서비스 A] -->|요청| B[사이드카 프록시 A]

B -->|프록시 간 통신| C[사이드카 프록시 B]

C -->|응답| D[서비스 B]

E[컨트롤 플레인] -->|정책/설정| B

E -->|정책/설정| C

- 서비스 간 통신은 프록시 (사이드카) 를 통해 이루어짐

- 컨트롤 플레인이 모든 프록시에 정책/설정을 전달

구조 및 아키텍처

구조 다이어그램

graph TD

subgraph 서비스 메시

A[컨트롤 플레인] -->|정책/설정| B[데이터 플레인(프록시)]

B --> C[서비스 1]

B --> D[서비스 2]

B --> E[서비스 N]

end

구성 요소

| 구성요소 | 역할 | 특징 |

|---|---|---|

| 컨트롤 플레인 | 정책 관리, 설정 전달, 프록시 관리 | 중앙 집중적 관리, 고가용성 필요 29 |

| 데이터 플레인 (프록시) | 트래픽 처리, 라우팅, 로드 밸런싱, 보안 | 분산형, 각 서비스에 1:1 배치 29 |

| 관찰 가능성 도구 | 모니터링, 로깅, 트레이싱 | Jaeger, Kiali 등 14 |

필수/선택 구성요소

| 구분 | 구성요소 | 기능/역할 | 특징 |

|---|---|---|---|

| 필수 | 컨트롤 플레인 | 정책 관리, 설정 전달 | 고가용성, 확장성 필요 |

| 필수 | 데이터 플레인 (프록시) | 트래픽 처리, 보안 | 각 서비스에 1:1 배치 |

| 선택 | 관찰 가능성 도구 | 모니터링, 로깅, 트레이싱 | 운영 효율성 증대 |

구현 기법

| 구현 기법 | 정의 | 구성 | 목적 | 실제 예시 |

|---|---|---|---|---|

| 사이드카 패턴 | 서비스와 함께 프록시 컨테이너 배치 | 서비스 + 프록시 컨테이너 | 네트워크 로직 분리 | Istio, Linkerd27 |

| 프록시 기반 통신 | 모든 트래픽을 프록시가 처리 | 프록시 네트워크 | 트래픽 제어, 보안 | Envoy, NGINX2 |

| 정책 기반 관리 | 컨트롤 플레인에서 정책 정의 | 컨트롤 플레인 + 데이터 플레인 | 일관된 정책 적용 | Istio, Consul27 |

7. 장점 표

| 구분 | 항목 | 설명 | 특성 발생 원인 |

|---|---|---|---|

| 장점 | 비즈니스 로직 집중 | 개발자는 네트워크 복잡성에서 벗어나 비즈니스 로직에 집중 가능 | 네트워크 로직 분리 47 |

| 관찰 가능성 | 모든 트래픽을 모니터링, 로깅, 트레이싱 가능 | 프록시 기반 통신 [2]14 | |

| 보안 강화 | mTLS, 인증/인가, 암호화 등 보안 기능 제공 | 인프라 계층 통합 29 | |

| 확장성 | 서비스 추가/삭제 시 네트워크 정책 자동 적용 | 분산형 아키텍처 [2][13] | |

| 장애 복구 | 서킷 브레이커, 리트라이, 타임아웃 등 장애 복구 기능 | 정책 기반 관리 210 |

8. 단점 및 문제점, 해결책

| 구분 | 항목 | 설명 | 해결책 |

|---|---|---|---|

| 단점 | 오버헤드 | 프록시 추가로 인한 리소스/지연 증가 | 최적화 (ebpf 등), 경량화 [16] |

| 복잡성 | 설정/운영이 복잡함 | 자동화, 문서화, 교육 [16] | |

| 학습 곡선 | 새로운 개념/도구 학습 필요 | 체계적 교육, 커뮤니티 활용 |

| 구분 | 항목 | 원인 | 영향 | 탐지 및 진단 | 예방 방법 | 해결 방법 및 기법 |

|---|---|---|---|---|---|---|

| 문제점 | 성능 저하 | 프록시 오버헤드, 설정 미흡 | 응답 지연, 장애 | 모니터링, 로깅 | 최적화, 설정 점검 | ebpf 활용, 경량화 [16] |

| 장애 전파 | 서비스 간 의존성 | 전체 장애 가능 | 분산 추적, 모니터링 | 서킷 브레이커 적용 | 장애 격리, 재라우팅 [10][11] | |

| 보안 취약점 | 설정 오류, 미적용 | 데이터 유출, 공격 | 정기 점검, 모니터링 | 자동화, 정책 강제 | mTLS, 인증/인가 29 |

9. 도전 과제

| 카테고리 | 과제 | 원인/영향/탐지/예방/해결방법 |

|---|---|---|

| 성능 최적화 | 대규모 트래픽 처리 | ebpf 등 커널 레벨 최적화, 경량 프록시 사용, 설정 최적화 [16] |

| 하이브리드 환경 | 레거시 시스템 통합 | Istio 등 서비스 메시의 하이브리드 지원 강화, API Gateway 연동 17 |

| 보안 강화 | 정책 자동화 및 적용 | 자동화 도구 개발, 정책 템플릿화, 정기 점검 29 |

| 운영 복잡성 | 설정/운영 자동화 | CI/CD 파이프라인 통합, IaC(Infrastructure as Code) 적용 [16] |

10. 분류 기준에 따른 종류 및 유형

| 분류 기준 | 유형/종류 | 설명 |

|---|---|---|

| 구현 방식 | 사이드카 프록시 기반 | Istio, Linkerd, Consul6 |

| 라이브러리 기반 | Spring Cloud, Netflix OSS[6][12] | |

| PaaS 내장형 | Azure Service Fabric, Lagom6 | |

| 배포 환경 | 쿠버네티스 기반 | Istio, Linkerd[7][12] |

| 온프레미스/하이브리드 | Consul, Istio(하이브리드 지원)17 |

11. 실무 사용 예시

| 목적 | 함께 사용되는 기술 | 효과 |

|---|---|---|

| 마이크로서비스 통신 | Kubernetes, Istio | 서비스 간 안정적 통신, 모니터링, 보안 7 |

| 분산 트레이싱 | Jaeger, Kiali | 장애 추적, 성능 분석 14 |

| 로드 밸런싱 | Envoy, NGINX | 트래픽 분산, 장애 복구 2 |

| 보안 강화 | mTLS, 인증/인가 | 데이터 암호화, 접근 제어 29 |

12. 활용 사례

사례: Istio 기반 마이크로서비스 환경에서의 트래픽 관리 및 분산 트레이싱

- 시스템 구성: Kubernetes 클러스터 + Istio(서비스 메시) + Envoy(프록시) + Jaeger(분산 트레이싱)

- 워크플로우:

- 클라이언트 → API Gateway → 서비스 A (사이드카 프록시)

- 서비스 A → 서비스 B (프록시 간 통신)

- 모든 트래픽은 Jaeger 에서 추적

- 역할: 트래픽 라우팅, 로드 밸런싱, 보안, 모니터링, 분산 트레이싱

- 차이점: 기존 라이브러리 기반 (Spring Cloud) 은 언어 종속적, 서비스 메시는 언어 독립적 [7][12].

13. 구현 예시 (Python 예시)

서비스 메시 자체는 인프라 계층이므로 코드 구현보다는 설정 예시를 제공합니다.

| |

14. 실무 적용 고려사항 및 주의할 점

| 구분 | 항목 | 설명 | 권장사항 |

|---|---|---|---|

| 고려사항 | 리소스 오버헤드 | 프록시 추가로 인한 리소스 소모 | 경량 프록시 사용, 최적화 [16] |

| 설정 복잡성 | 정책/설정 관리 복잡함 | 자동화, 문서화, 교육 | |

| 보안 정책 | mTLS, 인증/인가 설정 필요 | 정기 점검, 자동화 29 | |

| 관찰 가능성 | 모니터링, 로깅, 트레이싱 도구 연동 필요 | 통합 모니터링 도구 사용 14 |

15. 최적화 고려사항 및 주의할 점

| 구분 | 항목 | 설명 | 권장사항 |

|---|---|---|---|

| 최적화 | 네트워크 오버헤드 | ebpf 등 커널 레벨 최적화 | ebpf 활용, 경량화 [16] |

| 설정 자동화 | CI/CD, IaC 적용 | 자동화 파이프라인 구축 [16] | |

| 성능 모니터링 | 실시간 모니터링, 경보 설정 | 모니터링 도구 연동 14 | |

| 보안 강화 | 정책 자동화, 정기 점검 | 자동화, 템플릿화 29 |

16. 기타 사항

- 서비스 메시와 API Gateway 차이: 서비스 메시는 내부 통신 관리, API Gateway 는 외부 트래픽 관리 2[13].

- 하이브리드/멀티클라우드 지원: Istio, Consul 등은 하이브리드 환경 지원 17.

- 성능 최적화: ebpf 등 커널 레벨 최적화 가능 [16].

17. 주제와 관련하여 주목할 내용

| 카테고리 | 주제 | 항목 | 설명 |

|---|---|---|---|

| 트렌드 | 서비스 메시 | 하이브리드/멀티클라우드 | Istio, Consul 등 하이브리드 환경 지원 강화 17 |

| 기술 | 최적화 | ebpf | 커널 레벨 네트워크 최적화로 성능 극대화 [16] |

| 보안 | mTLS | 인증/암호화 | 서비스 간 통신 암호화, 인증 강화 29 |

| 운영 | 관찰 가능성 | 분산 트레이싱 | Jaeger, Kiali 등으로 장애 추적, 성능 분석 14 |

18. 반드시 학습해야 할 내용

| 카테고리 | 주제 | 항목 | 설명 |

|---|---|---|---|

| 기본 | 서비스 메시 | 정의/역할 | 마이크로서비스 간 통신 관리 인프라 계층 12 |

| 구조 | 아키텍처 | 컨트롤/데이터 플레인 | 정책 관리/트래픽 처리 29 |

| 기술 | 프록시 | 사이드카 패턴 | 서비스와 함께 프록시 배치 27 |

| 보안 | mTLS | 인증/암호화 | 서비스 간 통신 암호화 29 |

| 운영 | 관찰 가능성 | 모니터링/트레이싱 | 분산 트레이싱, 로깅 14 |

용어 정리

| 카테고리 | 용어 | 설명 |

|---|---|---|

| 아키텍처 | 서비스 메시 (Service Mesh) | 마이크로서비스 간 통신을 관리하는 인프라 계층 12 |

| 구성요소 | 컨트롤 플레인 (Control Plane) | 정책 관리, 설정 전달, 프록시 관리 29 |

| 구성요소 | 데이터 플레인 (Data Plane) | 트래픽 처리, 라우팅, 로드 밸런싱, 보안 29 |

| 패턴 | 사이드카 패턴 (Sidecar Pattern) | 서비스와 함께 프록시 컨테이너 배치 27 |

| 보안 | mTLS(Mutual TLS) | 상호 TLS, 서비스 간 암호화 통신 29 |

| 운영 | 관찰 가능성 (Observability) | 모니터링, 로깅, 트레이싱 14 |

참고 및 출처

- 서비스 메시: 마이크로서비스 아키텍처의 핵심 구성 요소 - velog

- 서비스 메시란? - 티스토리

- 서비스 메시 (Service Mesh) - Kkongchii_Log

- 서비스 메시 (Service Mesh) - itpe.jackerlab.com

- 서비스 메시란 무엇인가? - API7.ai

- Service Mesh 정의 및 Istio 소개 - lati-tech.tistory.com

- [서비스 메시란 무엇인가요? - AWS][18]

- [Service Mesh 의 구성 요소와 동작 과정 - 주녁, DevNote][19]

- Service Mesh - Istio - velog

- [서비스 메시 플랫폼이 필요하다면? - rockplace.tistory.com][14]

- 서비스 메쉬 정리 - velog

- 서비스 매시 (Service Mesh) 패턴 - SK(주) C&C’s TECH BLOG

- [서비스 메시와 네임스페이스 관리의 최적화 전략 - F-Lab][16]

- [Kubernetes 네트워크 2 - 서비스 메시 (Service Mesh) - 보배로움][12]

- [서비스 메쉬 (service mesh) 개념, 기능, 방법 및 관리 - Red Hat][20]

- 지금 서비스 메시가 의미 있는 이유 | 인사이트리포트 | 삼성 SDS

- [서비스 메시 (Service Mesh) 란? + API Gateway 와 차이점][13]

- [서비스 메시 이해 | 서비스 메시 | OpenShift Container Platform][15]

- [서비스 매시 아키텍처 (Service Mesh Architecture) - 막형의 macStory][11]

검색 중 오류가 발생했습니다. 다시 시도하여 최신 정보를 수집하겠습니다.

아래는 요청하신 “서비스 메시(Service Mesh)” 주제 조사 작업의 1~4단계 내용입니다.

1. 태그 (3–4개, 영어-하이픈 형식)

2. 분류 구조 분석

“Computer Science and Engineering > DevOps and Infrastructure > Cloud Native Platforms”

- Service Mesh는 클라우드 네이티브 플랫폼 위에서 DevOps 및 인프라 관점의 핵심 네트워킹 계층이므로, 현재 계층 구조는 적절합니다.

- “Cloud Native Platforms” 하위에 Service Mesh를 독립 구성 요소로 지정하는 것도 타당하며, 필요 시 “Service Mesh & Runtime Networking” 처럼 세부 구성 가능하겠습니다.

3. 200자 내외 요약

서비스 메시는 마이크로서비스 간 통신을 Sidecar 프록시 기반 Data Plane으로 추상화하고, Control Plane에서 정책·보안·관찰 기능을 외부화하는 인프라 계층입니다. 이를 통해 서비스 간 보안(mTLS), 로드밸런싱, 리트라이, 트래픽 제어, 모니터링 등을 코드 수정 없이 적용할 수 있습니다.

4. 250자 내외 개요

서비스 메시는 대규모 마이크로서비스 통신의 복잡성을 해결하기 위한 인프라 계층입니다. 각 서비스에 **사이드카 프록시(Envoy 등)**를 함께 배포하여 데이터 플레인으로 활용하고, 중앙 **컨트롤 플레인(Pilot, Citadel 등)**이 이를 통해 통신 정책, 보안, 관찰 기능을 관리합니다. 결과적으로 개발자는 비즈니스 로직 집중, 운영자는 중앙 정책 적용, 보안성과 신뢰성이 향상된 서비스 간 통신을 보장받습니다. Kubernetes 기반 클라우드 네이티브 환경에서 특히 효과적이며 Istio, Linkerd, Consul, Cilium Mesh 등이 대표적입니다.

다음은 5단계: 핵심 개념 정리입니다.

5. 핵심 개념 (이론 + 실무 관점)

Data Plane (이전 ‘주요 기능 및 역할’/‘작동 원리’ 일부)

- 정의: 각 서비스 인스턴스와 함께 배포되는 프록시들(예: Envoy, Linkerd‑proxy)로 구성되며, 실제 네트워크 통신(라우팅, TLS, 부하분산, 리트라이, 서킷브레이킹, 모니터링 등)을 처리합니다 (blog.envoyproxy.io).

- 실무 요소: Envoy 같은 프록시를 사이드카로 배포 → 설정 파일 또는 xDS API를 통해 구성받음 (medium.com).

Control Plane (이전 ‘구성 요소’ 일부)

- 정의: 데이터 플레인 프록시의 설정·정책·인증·라우팅 규칙·TLS 인증서 등을 중앙에서 관리하는 구성요소(Istiod, Pilot, Citadel, Consul 등) (blog.envoyproxy.io, medium.com).

- 실무 요소: Kubernetes API 연동, 서비스 디스커버리, 정책 배포, 텔레메트리 수집, UI/CLI 인터페이스 제공 .

Sidecar Proxy 패턴

- 정의: 각 애플리케이션 컨테이너 옆에 독립 컨테이너로 배치되어, 애플리케이션 코드 변경 없이 네트워크 관련 공통 기능(보안, 로깅, 재시도 등)을 Sidecar에서 처리하도록 하는 패턴 (techtarget.com).

- 실무 요소: Kubernetes Pod에 함께 배포 → 인그레스/이그레스 트래픽 인터셉트 → 서비스 코드 변경 없이 기능 확장.

xDS API 및 통신

- 정의: Envoy 등의 프록시가 컨트롤 플레인과 통신하며 CD(S)/ED(S)/LD(S)/RD(S)/AD(S) API를 통해 설정을 동적으로 수신하는 프로토콜 (medium.com).

- 실무 요소: gRPC 기반 xDS 엔드포인트로 컨트롤 플레인 구성 → 동적 정책 업데이트, 서비스 디스커버리와 유연한 구성 반영.

Service Mesh 분리 원칙

- 정의: 네트워크 통신과 비즈니스 로직의 분리 → 개발자는 비즈니스 로직 집중, 운영팀은 인프라 정책 중앙 관리.

- 실무 요소: zero-trust 모델 실현, 공통 기능 재사용, SDK 유지보수 비용 감소 (tetrate.io, konghq.com).

📌 핵심 개념과 실무 구현 요소 요약

| 개념 | 설명 | 실무 구현 요소 |

|---|---|---|

| Data Plane | 사이드카 프록시가 서비스 간 통신 처리 | 사이드카 컨테이너 + xDS 구동 |

| Control Plane | 정책 관리 및 배포 | Istiod/Pilot, Kubernetes 연동 |

| Sidecar Pattern | 각 서비스와 함께 사이드카 배포 | 쿠버네티스 Pod 템플릿 수정 |

| xDS API | 동적 설정 전달 프로토콜 | Envoy 설정 자동 업데이트 |

| 네트워크와 비즈니스 로직 분리 | 정책 중앙 관리, 코드 변경 최소화 | 보안 정책/모니터링 외부화 |

다음 단계

- **“## 5.1 정리된 핵심 개념 + 실무 요소”**를 완료했습니다.

- 계속해서 “## 5. 주제와 관련하여 조사할 내용” 항목을 하나씩 채워나가겠습니다.

- 원하시는 우선순위나 특정 항목이 있으면 알려주세요 😊

다음은 “서비스 메시 (Service Mesh)” 의 배경, 목적, 필요성, 주요 기능, 구조 및 아키텍처를 중심으로 한 조사 내용입니다.

📘 배경 (Background)

- 클라우드 네이티브 환경에서 마이크로서비스가 확산되면서, 서비스 간 통신 관리의 복잡성, 보안, 관찰성이 문제가 됨 (infoq.com, codecentric.de).

- 초기에는 애플리케이션 코드에 통신 로직(재시도, TLS, 라우팅 등)을 직접 구현하거나, 라이브러리(API Gateway나 SDK)로 해결했지만, 이는 언어·프레임워크 종속, 운영 복잡성 증가 등의 한계가 있었음 .

- 마이크로서비스는 수백~수천 개의 독립 컴포넌트로 구성되고, 새로운 네트워크 요구사항이 지속적으로 등장함에 따라 이러한 문제를 해결하기 위한 인프라 기반의 네트워크 계층이 필요해졌음 .

🎯 목적 및 필요성 (Purpose & Need)

- 통신 로직 코드 독립화 -> 개발자들이 로직이 아닌 비즈니스 코드에 집중할 수 있음 (konghq.com).

- 정책 중앙화 관리 -> 플랫폼/운영팀이 보안, 라우팅, 관찰성 정책을 정책단에서 관리 가능 (en.wikipedia.org).

- zero‑trust 보안 -> 서비스 간 자동 TLS(mTLS) 적용으로 트러스트 기반 보안 강화 (tetrate.io, tetrate.io).

- 관찰성 강화 (Observability) -> 사이드카가 메트릭, 로그, 트레이싱 데이터를 수집하여 통합된 모니터링 제공 (infoq.com).

- 신뢰성(Resilience) -> 사이드카에서 리트라이, 서킷브레이커, 페일오버 설정으로 자체 복원력 제공 .

- 유연한 트래픽 관리 -> A/B 테스트, 카나리, 트래픽 쉐이핑 등 세밀한 라우팅 정책 설정 가능 .

🧩 주요 기능 및 역할 (Key Features)

서비스 메시의 기능은 다음의 네 가지 핵심 카테고리로 나뉩니다 :

| 범주 | 기능 요약 |

|---|---|

| Connectivity | 서비스 디스커버리, 게이트웨이 ingress/egress, 라우팅·쉐이핑, A/B 테스트 |

| Reliability | 리트라이, 타임아웃, 서킷브레이커, 장애 주입(fault injection) |

| Security | 자동 mTLS 인증, 정책 기반 인증·인가, 인증서 관리, ACL |

| Observability | 메트릭, 로그, 분산 트레이싱, 서비스 그래프, 텔레메트리 |

🏛 구조 및 아키텍처 (Architecture & Components)

서비스 메시는 데이터 플레인(Data Plane) 과 컨트롤 플레인(Control Plane) 으로 구성됩니다.

✅ 데이터 플레인

- 각 서비스와 함께 배포되는 프록시(Envoy, Linkerd-proxy 등)

- 서비스 간 통신 가로채기, TLS, 부하분산, 리트라이·서킷브레이커 적용, 텔레메트리 수집 담당 (istio.io, tetrate.io, en.wikipedia.org).

✅ 컨트롤 플레인

정책 관리, 인증서 발급, 프록시 설정 배포, 메트릭 수집 등을 중앙 제어.

대표 구현체(Istio 기준):

- Pilot/Istiod: 환경 탐지, 라우팅 정책 전달 (istio.io)

- Citadel: 인증서 발급 및 mTLS 관리 (istioworkshop.io)

- Galley: 설정 수집 및 유효성 판단 (istioworkshop.io)

- Mixer: 정책 집행 및 텔레메트리 허브 (Istio 최신 버전에서는 일부 리팩토링됨) (istioworkshop.io)

🧭 구조 다이어그램

- Anthos, Istio, Tigera 등 주요 프로젝트의 구조도를 통해 데이터/컨트롤 플레인 분리를 시각화했습니다. 위 이미지 참조 .

정리

서비스 메시는 마이크로서비스 환경에서 통신 인프라를 별도 계층으로 분리하여 보안, 관찰성, 정책 관리, 신뢰성 강화를 코드 수정 없이 적용하는 플랫폼입니다. 다음 단계로는 “구현 기법” 및 장점/단점 표 작성을 준비하겠습니다. 원하시면 특정 프로젝트(Istio, Linkerd 등) 비교도 추가 가능합니다!

아래는 “서비스 메시(Service Mesh)” 주제의 실무 사용 예시, 활용 사례, 구현 예시, 추가 학습할 내용 등을 정리한 이어지는 내용입니다.

15. 실무 사용 예시

| 함께 사용되는 기술 | 목적 | 효과 |

|---|---|---|

| Istio + Kubernetes | 트래픽 관리 및 Canary 배포 | 버전별 트래픽 10%→90% 단계적 전환 가능 (github.com, konghq.com) |

| Istio + VM | 클라우드-온프레미스 하이브리드 | VM과 컨테이너 간 일관된 서비스 정책 유지 |

| Envoy + gRPC | Proxy-less 통신 | 사이드카 제거 → 레이턴시 저감, 자원 절약 |

| Istio + FastAPI | 외부 인증 플로우 | FastAPI 기반 External Authorization 서버 적용 |

| Istio + E-commerce | Black Friday 대비 신뢰성 강화 | Circuit Breaking, Retry 로 안정성 확보 |

16. 활용 사례 – e‑commerce 플랫폼 안정성

🧩 상황 개요

- 목적: 블랙프라이데이 같이 트래픽 급증 시 서비스 안정성 확보

- 기술 스택: Kubernetes, Istio, Envoy

💡 시스템 구성 다이어그램 (Mermaid)

graph TD

User --> IngressGW[Envoy Ingress Gateway]

IngressGW --> svc-v1

IngressGW --> svc-v2

svc-v1[Checkout v1 + Envoy] --> svc-db

svc-v2[Checkout v2 + Envoy] --> svc-db

subgraph Control Plane

Pilot

Citadel

end

⚙️ Workflow

- Ingress Gateway 통해 외부 요청 수신

- VirtualService로 v2 버전 트래픽을 20% 할당

- Pilot이 VirtualService 설정을 각 Envoy에 배포 (xDS)

- 사이드카 Envoy에서 Retry/Timeout/Circuit-Breaker 자동 적용

- Citadel이 mTLS 인증서 자동 할당 및 갱신

- 정상 여부 모니터링, 성능 충족 시 점진적 v2 트래픽 증가

📊 효과

- 코드 변경 없이 레이어에서 안정성/보안 확보

- 실패 시 장애 스트래티징을 통한 롤백 우회

- 실무 대비 트래픽 제어 및 CNCF 준수 환경 제공

17. 구현 예시 – Python + Istio VirtualService (Canary 배포)

| |

- 이 코드와 YAML은 20% v2, 80% v1 배포 리스크 완화

- Envoy 사이드카가 자동으로

retries,timeout,fault injection정책 집행

18. 주목할 내용 및 필수 학습 항목

| 카테고리 | 주제 | 항목 | 설명 |

|---|---|---|---|

| 네트워킹 원리 | xDS 프로토콜 | CDS, EDS, LDS 등 | Envoy와 Control Plane간 설정 교류 |

| 보안 | mTLS 자동 갱신 | Citadel/SPIRE 연동 | 상호 TLS 인증 관리 |

| 배포 전략 | Canary & A/B 구성 | VirtualService, DestinationRule | 테스트 롤아웃, 분리 배포 |

| observability | 텔레메트리 스택 | Prometheus, Grafana, Jaeger | 분산 트레이싱, 모니터링 정합성 |

📚 용어 정리

| 카테고리 | 용어 | 설명 |

|---|---|---|

| 네트워크 | mTLS | 상호 TLS 인증 |

| 세트 구성 | VirtualService | Istio 내 트래픽 라우팅 설정 단위 |

| 통신 규약 | xDS API | Envoy 구성 전달용 동적 API |

| 운영 도구 | Citadel | 인증서 발급 및 서비스 아이덴티티 관리 |

| 패턴 | Proxy-less Mesh | 사이드카 대신 xDS 라이브러리 직접 통합 |

💡 참고 및 출처

- Istio 공식 예제 – Bookinfo 앱 구성 (github.com, istio.io, gcore.com, praveendandu24.medium.com, konghq.com, medium.com, loginradius.com, loft.sh, istio.io, ferrishall.dev)

- e‑commerce 안정성: Istio Use Cases 설명

- External Auth with FastAPI 활용 (medium.com)

- Envoy fault, retry 예시

- Kubernetes + Istio 구현 튜토리얼 (loft.sh)

정리

여기까지 “실무 사용 예시”, “활용 사례”, “Python 구현 예시”, “주목할 내용 및 학습 항목”을 포함한 전체 구성입니다. 필요한 부분을 더 심화하거나 추가 사례, 비교표/Istio vs Linkerd 등 포함해드릴 수 있습니다. 알려주세요!

6. 구현 기법 (Implementation Techniques)

서비스 메시는 주로 사이드카 기반 데이터 플레인과 중앙 컨트롤 플레인의 조합으로 실현되며, 다양한 방식으로 구현됩니다.

✅ Sidecar Proxy (기본 모델, DPA‑1)

- 정의: 각 서비스 인스턴스별로 사이드카 프록시(Envoy, Linkerd-proxy 등)를 함께 배포하여 L4/L7 통신 관리를 담당.

- 구성 요소: 사이드카 컨테이너, xDS API를 통한 컨트롤 플레인과의 동적 통합 (thoughtworks.com, nvlpubs.nist.gov, istio.io).

- 목적: 코드 수정 없이 트래픽 관리, TLS, 재시도, 서킷브레이킹, 모니터링을 분리된 계층에서 처리.

- 실무 예시: Kubernetes Pod 템플릿에 Envoy 주입, Istio/Pilot/Istiod가 xDS로 설정 배포.

✅ Shared Proxy per Node (DPA‑2/DPA‑3)

- 정의: 노드 단위로 프록시를 공유하여 자원 효율성을 높인 방식.

- 구성 요소: 노드별 단일 프록시(VIP). L4와 L7 처리를 통합하거나 분리된 모델.

- 목적: 사이드카 오버헤드를 줄이면서도 라우팅·보안·모니터링 기능 제공.

- 실무 예시: 대규모 VM 환경에서 Pod 내 사이드카 대신 워커노드에 데몬세트 프록시 배포.

✅ Proxy-less 또는 gRPC xDS (DPA‑4)

- 정의: Envoy 없이 애플리케이션이 xDS API 직접 통신, gRPC 프록시 라이브러리 형태.

- 구성 요소: 애플리케이션 내벽 통합된 proxy 코드, xDS 통신 모듈.

- 목적: 사이드카 제거로 자원 절약, 레이턴시 저감.

- 실무 예시: gRPC 기반 시스템에서 gRPCxDS 사용 → Envoy 불필요 .

✅ Ambient Mesh

- 정의: Istio의 사이드카리스 모델. 보안은 OS/네트워크 계층(iptables 등), L7은 선택적 프록시.

- 목적: 운영 단순화, 리소스 사용 최소화.

- 실무 예시: Istio ambient mesh 도입 사례.

7. 주요 원리 및 작동 원리 다이어그램

☑️ 원리 요약

- 분리된 계층: App ↔ Proxy: 보안·라우팅·관찰

- 동적 설정: 컨트롤 플레인 → xDS API → 프록시

- 신뢰 모델: mTLS 기반 인증서 자동 발급

- 폴리시 집행: 사이드카에서 실시간으로 트래픽 적용

🌐 mermaid 도식 (구조 및 작동 흐름)

graph LR

subgraph Control Plane

Pilot(Pilot/Istiod)

Citadel(Citadel/CA)

Galley(Config)

Mixer(Telemetry/Policy)

end

subgraph Data Plane

svcA[Service A] -- outbound --> proxyA[Envoy A]

proxyA -- xDS config --> Pilot

proxyA -- report telemetry --> Mixer

ServiceB[Service B] -- inbound --> proxyB[Envoy B]

proxyA --> proxyB

end

Pilot --> proxyB

Citadel --> proxyA

8. 장점 비교

| 구분 | 항목 | 설명 |

|---|---|---|

| 장점 | 인프라 분리 | 애플리케이션 코드에 변경 없이 트래픽 관리 가능 |

| 보안 강화 | mTLS 자동화, 인증서 생명주기 관리 | |

| 관찰성 증가 | 메트릭·로그·트레이싱 통합 수집 | |

| 트래픽 제어 | 카나리, A/B, 페일오버, 쉐이핑 | |

| 복원력 향상 | 재시도, 타임아웃, 서킷브레이커 적용 |

- 인프라 분리: 정책과 구현을 컨트롤 플레인으로 위임

- 보안 강화: zero-trust 기반 TLS 자동화

- 관찰성 증가: 전체 트래픽 흐름 가시화

- 트래픽 제어: 세밀한 버전/라우팅 정책

- 복원력 향상: 네트워크 장애 자동 대응

9. 단점 및 문제점 + 해결방안

9.1 단점

| 구분 | 항목 | 설명 | 해결책 |

|---|---|---|---|

| 단점 | 복잡도 증가 | 시스템 전체에 사이드카 및 컨트롤 플레인 구성 필요 | 단계적 도입, 명확한 운영 가이드라인 수립 |

| 리소스 오버헤드 | 사이드카 및 정책 처리로 CPU/메모리 소비 | ambient mesh, shared proxy, 리소스 튜닝 | |

| 디버깅 난이도 | 트래픽 흐름이 사이드카 통해 변조, 추적 어려움 | 정밀 로깅, OpenTelemetry, Kiali 등 시각화 도구 활용 |

9.2 문제점

| 구분 | 항목 | 원인 | 영향 | 탐지 및 진단 | 예방 방법 | 해결 방법 및 기법 |

|---|---|---|---|---|---|---|

| 문제점 | 구성 오류 | 잘못된 xDS/policy 설정 | 통신 장애, 인증 실패 | Alert, 로그 분석, tracing | CI/CD 설정 검증, 검토 프로세스 도입 | 롤백, 테스트 기반 재설정 |

| 인증서 만료 | Citadel/CA 자동 갱신 실패 | 서비스 간 TLS 미연결 | 모니터링 경보 | 모니터 주기 설정, 경고 플로우 강화 | 수동 갱신 또는 CA 재배포 | |

| 성능 병목 | 프록시에서의 고부하 발생 | 전체 지연 증가, 시간초과 유발 | Latency metrics, tracing | 사이드카 리소스 할당 조정, 샘플링 | 일부 서비스에서 proxy-less 구성 검토 |

10. 정리

- 최근 점차 shared proxy, proxy-less, ambient mesh로 대체되는 추세

- 핵심 원리는 여전히 Sidecar 기반 분산 제어·관리 방식

- 실무에서는 모니터링 체계, 리소스 관리, CI/CD 절차 정비가 필수

다음으로는 도전 과제, 분류 기준, 실무 적용 고려사항, 최적화 방법 등을 이어서 정리해드릴 수 있습니다. 원하시는 항목을 알려주시면 즉시 추가

앞서 이어서 요청하신 내용을 기반으로, 다음은 도전 과제, 분류 기준, 실무 적용 고려사항, 최적화 고려사항을 정리한 내용입니다.

11. 도전 과제 (Challenges)

| 카테고리 | 주제 | 항목 | 설명 |

|---|---|---|---|

| 운영 복잡성 | 오버헤드 최적화 | 리소스 소모 문제 | 다수의 사이드카로 인한 CPU/메모리 사용 증가 |

| 보안 확장성 | 인증서 관리 | 자동 갱신 실패 위험 | 인증서 수명이 짧고 동기화 오류 발생 가능 |

| 트래픽 분석 | observability 통합 | 로그/메트릭 통합 문제 | 로그 수집 및 트레이싱 데이터 통합 어려움 |

| 이식성 | 환경 종속성 | 쿠버네티스 강의존 | VM 환경이나 하이브리드 인프라에서 제한됨 |

| 조직 내 도입 | 운영팀 이해도 | 구조·개념 복잡도 | DevOps 또는 SRE팀의 도입 장벽이 높음 |

12. 분류 기준에 따른 종류 및 유형

| 분류 기준 | 유형 | 설명 |

|---|---|---|

| 프록시 방식 | Sidecar 방식 | 각 서비스에 프록시 컨테이너 부착 |

| Shared Proxy | 노드 단위 단일 프록시 공유 | |

| Proxy-less | 프록시 제거, 라이브러리로 직접 처리 | |

| 배포 환경 | Kubernetes 기반 | 쿠버네티스에 특화 |

| VM 기반 | 비-Kubernetes 환경 지원 | |

| 구현체 | Istio | 대표적인 기능 중심 Mesh |

| Linkerd | 경량화, 심플한 구성 | |

| Consul Connect | 서비스 디스커버리 통합형 | |

| 목적 지향별 | 보안 지향형 | mTLS, ACL 중심 구성 |

| 트래픽 제어형 | 라우팅/회복성 중심 정책 제공 |

13. 실무 적용 고려사항 및 주의점

| 항목 | 고려사항 | 권장 사항 |

|---|---|---|

| 도입 범위 설정 | 전면 도입 vs 단계적 도입 | 핵심 서비스부터 시작해 점진적 확장 |

| 리소스 관리 | 사이드카 자원 소비 | CPU/Memory limits 및 모니터링 |

| 조직 내 협업 구조 | DevOps/SRE와 연계 | 초기 교육, 운영 Runbook 마련 |

| 인증서 자동화 | TLS 인증/만료 모니터링 | Citadel/CA 상태 감시, 알림 설정 |

| 장애 대응 | 설정 실수/롤백 전략 | GitOps 기반 설정, Rollback 플랜 구성 |

14. 최적화 고려사항 및 주의점

| 항목 | 고려사항 | 권장 사항 |

|---|---|---|

| 사이드카 배포 전략 | 필요 없는 서비스에 적용 제한 | Traffic 관찰 대상 서비스에만 적용 |

| 로그/메트릭 수집 | 수집량 폭주 → 성능 저하 | 샘플링 비율 조정, 수집 레벨 조정 |

| 트래픽 제어 정책 | A/B 테스트 라우팅 과부하 | 테스트 대상 범위 최소화, 정책 TTL 설정 |

| 리소스 병목 분석 | 프록시 부하로 인한 지연 | Proxy CPU 할당 증가, 분산 라우팅 구성 |

| 제어 평면 통신 안정성 | xDS 전송 실패 | Retry 및 timeout 세부 튜닝 설정 |

아래는 “서비스 메시(Service Mesh)” 주제의 실무 사용 예시, 활용 사례, 구현 예시, 추가 학습할 내용 등을 정리한 이어지는 내용입니다.

15. 실무 사용 예시

| 함께 사용되는 기술 | 목적 | 효과 |

|---|---|---|

| Istio + Kubernetes | 트래픽 관리 및 Canary 배포 | 버전별 트래픽 10%→90% 단계적 전환 가능 (github.com, konghq.com) |

| Istio + VM | 클라우드-온프레미스 하이브리드 | VM과 컨테이너 간 일관된 서비스 정책 유지 |

| Envoy + gRPC | Proxy-less 통신 | 사이드카 제거 → 레이턴시 저감, 자원 절약 |

| Istio + FastAPI | 외부 인증 플로우 | FastAPI 기반 External Authorization 서버 적용 |

| Istio + E-commerce | Black Friday 대비 신뢰성 강화 | Circuit Breaking, Retry 로 안정성 확보 |

16. 활용 사례 – e‑commerce 플랫폼 안정성

🧩 상황 개요

- 목적: 블랙프라이데이 같이 트래픽 급증 시 서비스 안정성 확보

- 기술 스택: Kubernetes, Istio, Envoy

💡 시스템 구성 다이어그램 (Mermaid)

graph TD

User --> IngressGW[Envoy Ingress Gateway]

IngressGW --> svc-v1

IngressGW --> svc-v2

svc-v1[Checkout v1 + Envoy] --> svc-db

svc-v2[Checkout v2 + Envoy] --> svc-db

subgraph Control Plane

Pilot

Citadel

end

⚙️ Workflow

- Ingress Gateway 통해 외부 요청 수신

- VirtualService로 v2 버전 트래픽을 20% 할당

- Pilot이 VirtualService 설정을 각 Envoy에 배포 (xDS)

- 사이드카 Envoy에서 Retry/Timeout/Circuit-Breaker 자동 적용

- Citadel이 mTLS 인증서 자동 할당 및 갱신

- 정상 여부 모니터링, 성능 충족 시 점진적 v2 트래픽 증가

📊 효과

- 코드 변경 없이 레이어에서 안정성/보안 확보

- 실패 시 장애 스트래티징을 통한 롤백 우회

- 실무 대비 트래픽 제어 및 CNCF 준수 환경 제공

17. 구현 예시 – Python + Istio VirtualService (Canary 배포)

| |

- 이 코드와 YAML은 20% v2, 80% v1 배포 리스크 완화

- Envoy 사이드카가 자동으로

retries,timeout,fault injection정책 집행

18. 주목할 내용 및 필수 학습 항목

| 카테고리 | 주제 | 항목 | 설명 |

|---|---|---|---|

| 네트워킹 원리 | xDS 프로토콜 | CDS, EDS, LDS 등 | Envoy와 Control Plane간 설정 교류 |

| 보안 | mTLS 자동 갱신 | Citadel/SPIRE 연동 | 상호 TLS 인증 관리 |

| 배포 전략 | Canary & A/B 구성 | VirtualService, DestinationRule | 테스트 롤아웃, 분리 배포 |

| observability | 텔레메트리 스택 | Prometheus, Grafana, Jaeger | 분산 트레이싱, 모니터링 정합성 |

📚 용어 정리

| 카테고리 | 용어 | 설명 |

|---|---|---|

| 네트워크 | mTLS | 상호 TLS 인증 |

| 세트 구성 | VirtualService | Istio 내 트래픽 라우팅 설정 단위 |

| 통신 규약 | xDS API | Envoy 구성 전달용 동적 API |

| 운영 도구 | Citadel | 인증서 발급 및 서비스 아이덴티티 관리 |

| 패턴 | Proxy-less Mesh | 사이드카 대신 xDS 라이브러리 직접 통합 |

💡 참고 및 출처

- Istio 공식 예제 – Bookinfo 앱 구성 (github.com, istio.io, gcore.com, praveendandu24.medium.com, konghq.com, medium.com, loginradius.com, loft.sh, istio.io, ferrishall.dev)

- e‑commerce 안정성: Istio Use Cases 설명

- External Auth with FastAPI 활용 (medium.com)

- Envoy fault, retry 예시

- Kubernetes + Istio 구현 튜토리얼 (loft.sh)

정리

여기까지 “실무 사용 예시”, “활용 사례”, “Python 구현 예시”, “주목할 내용 및 학습 항목”을 포함한 전체 구성입니다. 필요한 부분을 더 심화하거나 추가 사례, 비교표/Istio vs Linkerd 등 포함해드릴 수 있습니다. 알려주세요!

다음은 추가 요청하신 비교: Istio vs Linkerd 및 기능별 비교, 끝맺음입니다.

🔍 Istio vs Linkerd 비교

| 항목 | Istio | Linkerd |

|---|---|---|

| 아키텍처 | Envoy Sidecar + 복잡한 Control Plane 구성 (Pilot, Istiod, Citadel 등) | Rust/Go 기반 경량 Sidecar + 단순 Control Plane |

| 설치·설정 난이도 | 설치 및 설정이 복잡한 편 | 간단하고 빠른 설치, 설정 문법 직관적 |

| 성능 오버헤드 | 높은 편 (Envoy, Go/Java 기반 컨트롤) | 낮은 편 (경량 Rust 기반 프록시) |

| 기능 확장성 | 풍부한 정책, 다중 매개 변수 세밀 제어 가능 | 핵심 기능 중심, 최근 정책 확장 중 |

| 커뮤니티 및 생태계 | CNCF 및 기업 지원 대규모 (Google, IBM 등) | 소규모지만 활발한 커뮤니티 |

| 보안 기능 | mTLS, RBAC, 인증서 자동 갱신 등 풍부 | 기본 mTLS, TLS 자동화, 정책 중심 확장 중 |

| 관찰성 | Envoy 기반 고급 Telemetry, Mixer 플러그인 | Metric, Mesh Overview 제공, Jaeger 등과 연동 |

| 쿠버네티스 통합 | CRD·Webhooks로 긴밀 통합 | ServiceProfile CRD 등으로 간편 통합 |

| 프록시 없는 모드 | Ambient, proxy-less 옵션 제공 | 아직 실험적 기능 지원 |

🚀 기능별 비교 요약

- 기능 확장성 & 정책 제어 → Istio

- 경량 & 간편도 → Linkerd

- 보안 강화 → 둘 모두 가능, Istio가 더 풍부

- 리소스 절약 → Linkerd (Rust 기반) 효율적

- 대규모 엔터프라이즈 기능 → Istio

✅ 끝맺음

“서비스 메시”는 모던 클라우드 네이티브 환경에서 마이크로서비스 간 통신 문제를 인프라 계층에서 해결하는 강력한 패턴입니다. Istio와 Linkerd 모두 장단이 있으며, 목적과 환경에 따라 적절한 솔루션을 선택하는 것이 중요합니다.

- Istio: 보안·정책·관찰 기능 요구 많고 복잡성 수용 가능 시 탁월

- Linkerd: 간결함과 효율성, 핵심 기능 중심 운영에 적합

안녕하세요! 서비스 메시 (Service Mesh)에 대한 포괄적인 조사를 시작하겠습니다. 먼저 최신 정보를 수집하여 체계적으로 정리해드리겠습니다.이제 서비스 메시에 대한 포괄적인 조사를 시작하겠습니다. 체계적으로 4부분으로 나누어 정리해드리겠습니다.

1부: 기본 정보 및 개념

태그 (Tags)

- Service-Mesh

- Microservices-Communication

- Infrastructure-Layer

- Distributed-Systems

주제 분류 검증

“Computer Science and Engineering” > “DevOps and Infrastructure” > “Cloud Native Platforms”

이 분류는 적절합니다. 서비스 메시는 클라우드 네이티브 환경에서 마이크로서비스 간 통신을 관리하는 인프라 계층으로, DevOps 및 인프라 관리의 핵심 구성 요소입니다.

요약 (200자)

서비스 메시 (Service Mesh)는 마이크로서비스 아키텍처에서 서비스 간 통신을 관리하는 전용 인프라 계층입니다. 사이드카 프록시 (Sidecar Proxy)를 통해 트래픽 라우팅, 보안, 관찰성을 애플리케이션 코드 변경 없이 제공하며, 데이터 플레인 (Data Plane)과 컨트롤 플레인 (Control Plane)으로 구성됩니다.

개요 (250자)

서비스 메시는 분산 시스템에서 마이크로서비스 간 통신의 복잡성을 해결하는 혁신적인 솔루션입니다. Envoy 프록시와 같은 사이드카를 통해 로드 밸런싱, 서비스 디스커버리, 암호화, 모니터링을 중앙 집중식으로 관리합니다. Istio, Linkerd, Consul Connect 등의 구현체가 있으며, 제로 트러스트 보안과 카나리 배포를 지원하여 클라우드 네이티브 애플리케이션의 안정성과 보안성을 크게 향상시킵니다.

2부: 핵심 개념 및 이론

핵심 개념

서비스 메시의 핵심 개념들은 다음과 같습니다:

1. 사이드카 프록시 (Sidecar Proxy)

- 각 마이크로서비스와 함께 배포되는 경량 네트워크 프록시

- 모든 인바운드/아웃바운드 트래픽을 가로채고 관리

- 애플리케이션 코드와 독립적으로 동작

2. 데이터 플레인 (Data Plane)

- 실제 서비스 간 트래픽을 처리하는 계층

- 사이드카 프록시들의 집합

- 로드 밸런싱, 라우팅, 보안 정책 적용

3. 컨트롤 플레인 (Control Plane)

- 데이터 플레인의 구성과 관리를 담당

- 정책 배포, 서비스 디스커버리, 인증서 관리

- 중앙 집중식 관리 인터페이스 제공

실무 구현 요소:

- 프록시 주입 (Proxy Injection): Kubernetes에서 자동 사이드카 주입

- 정책 관리 (Policy Management): YAML 기반 구성 관리

- 텔레메트리 수집 (Telemetry Collection): 메트릭, 로그, 트레이싱 데이터 수집

- 인증서 관리 (Certificate Management): mTLS를 위한 자동 인증서 생성/갱신

배경

서비스 메시는 마이크로서비스 아키텍처의 확산과 함께 등장했습니다. 모놀리식 애플리케이션에서 마이크로서비스로 전환하면서 서비스 간 통신의 복잡성이 급격히 증가했고, 이를 해결하기 위한 전용 인프라 계층의 필요성이 대두되었습니다.

목적 및 필요성

주요 목적:

- 서비스 간 통신의 복잡성 추상화

- 보안, 관찰성, 트래픽 관리의 중앙 집중화

- 애플리케이션 코드에서 인프라 관심사 분리

필요성:

- 수백 개의 마이크로서비스 관리 복잡성

- 일관된 보안 정책 적용의 어려움

- 서비스 간 의존성 및 통신 패턴 파악의 중요성

주요 기능 및 역할

트래픽 관리 (Traffic Management)

- 로드 밸런싱, 라우팅, 회로 차단기

- 카나리 배포, A/B 테스팅 지원

보안 (Security)

- 상호 TLS (mTLS) 암호화

- 서비스 간 인증 및 권한 부여

관찰성 (Observability)

- 메트릭, 로그, 분산 트레이싱

- 서비스 토폴로지 시각화

안정성 (Reliability)

- 재시도, 타임아웃, 회로 차단기

- 장애 격리 및 복구

3부: 아키텍처 및 구성 요소

구조 및 아키텍처

서비스 메시는 3개의 주요 플레인으로 구성됩니다:

graph TB

subgraph "Management Plane"

MP[관리 플레인<br/>- 정책 관리<br/>- 거버넌스<br/>- 멀티 메시 연합]

end

subgraph "Control Plane"

CP[컨트롤 플레인<br/>- Pilot (서비스 디스커버리)<br/>- Citadel (보안)<br/>- Galley (구성 관리)]

end

subgraph "Data Plane"

subgraph "Service A Pod"

SA[Service A]

PA[Envoy Proxy]

end

subgraph "Service B Pod"

SB[Service B]

PB[Envoy Proxy]

end

subgraph "Service C Pod"

SC[Service C]

PC[Envoy Proxy]

end

end

MP --> CP

CP --> PA

CP --> PB

CP --> PC

PA -.-> PB

PB -.-> PC

PC -.-> PA

구성 요소

필수 구성요소:

데이터 플레인 (Data Plane)

- 사이드카 프록시: Envoy, NGINX 등

- 기능: 트래픽 프록시, 로드 밸런싱, 보안 정책 적용

- 특징: 애플리케이션과 동일한 파드에서 실행

컨트롤 플레인 (Control Plane)

- Pilot: 서비스 디스커버리 및 트래픽 관리

- Citadel/Istiod: 보안 및 인증서 관리

- Galley: 구성 검증 및 배포

- 기능: 정책 관리, 구성 배포, 텔레메트리 수집

선택 구성요소:

- 관리 플레인 (Management Plane)

- 기능: 멀티 클러스터 관리, 거버넌스, 정책 통합

- 특징: 엔터프라이즈 환경에서 주로 사용

- 예시: Istio Operator, Multi-cluster Management

작동 원리

sequenceDiagram

participant Client as 클라이언트

participant ProxyA as Service A Proxy

participant ServiceA as Service A

participant ProxyB as Service B Proxy

participant ServiceB as Service B

participant Control as 컨트롤 플레인

Control->>ProxyA: 정책 및 라우팅 규칙 배포

Control->>ProxyB: 정책 및 라우팅 규칙 배포

Client->>ProxyA: 요청

ProxyA->>ProxyA: 인증, 권한 확인

ProxyA->>ServiceA: 요청 전달

ServiceA->>ProxyA: 응답

ProxyA->>ProxyB: Service B 호출

ProxyB->>ProxyB: 보안 정책 적용

ProxyB->>ServiceB: 요청 전달

ServiceB->>ProxyB: 응답

ProxyB->>ProxyA: 응답

ProxyA->>Client: 최종 응답

ProxyA->>Control: 텔레메트리 데이터

ProxyB->>Control: 텔레메트리 데이터

구현 기법

1. 사이드카 패턴 (Sidecar Pattern)

- 정의: 메인 애플리케이션과 함께 배포되는 보조 컨테이너

- 구성: 동일 파드 내에서 네트워크 네임스페이스 공유

- 목적: 네트워크 통신 가로채기 및 정책 적용

- 예시: Kubernetes에서 Envoy 사이드카 자동 주입

2. 앰비언트 메시 (Ambient Mesh)

- 정의: 사이드카 없이 노드 레벨에서 동작하는 프록시

- 구성: DaemonSet으로 각 노드에 배포

- 목적: 리소스 사용량 최적화

- 예시: Istio Ambient Mesh (2022년 도입)

3. 서비스 메시 인터페이스 (SMI)

- 정의: 서비스 메시 간 표준화된 API

- 구성: CRD (Custom Resource Definition) 기반

- 목적: 벤더 중립적 인터페이스 제공

- 예시: 트래픽 정책, 액세스 제어, 메트릭 수집

4부: 장단점, 활용 사례 및 구현

장점

| 구분 | 항목 | 설명 |

|---|---|---|

| 장점 | 통신 단순화 | 사이드카 프록시를 통해 서비스 간 통신 복잡성을 인프라 계층으로 추상화 |

| 장점 | 보안 강화 | mTLS, 인증, 권한 부여를 애플리케이션 코드 변경 없이 자동 적용 |

| 장점 | 관찰성 향상 | 모든 트래픽에 대한 메트릭, 로그, 트레이싱을 자동으로 수집 |

| 장점 | 트래픽 제어 | 로드 밸런싱, 라우팅, 회로 차단기를 중앙에서 관리 |

| 장점 | 개발 생산성 | 개발자가 비즈니스 로직에 집중할 수 있도록 인프라 관심사 분리 |

| 장점 | 일관성 보장 | 모든 서비스에 동일한 정책과 구성을 일관되게 적용 |

단점과 문제점 그리고 해결방안

단점

| 구분 | 항목 | 설명 | 해결책 |

|---|---|---|---|

| 단점 | 복잡성 증가 | 추가 인프라 계층으로 인한 운영 복잡성 | 단계적 도입, 자동화 도구 활용 |

| 단점 | 성능 오버헤드 | 프록시를 통한 추가 홉으로 인한 지연 시간 증가 | 최적화된 프록시 사용, 성능 모니터링 |

| 단점 | 리소스 소비 | 각 서비스마다 사이드카 프록시 필요로 인한 CPU/메모리 증가 | 앰비언트 메시 채택, 리소스 최적화 |

| 단점 | 학습 곡선 | 새로운 기술 스택에 대한 팀 교육 필요 | 점진적 도입, 교육 프로그램 제공 |

문제점

| 구분 | 항목 | 원인 | 영향 | 탐지 및 진단 | 예방 방법 | 해결 방법 및 기법 |

|---|---|---|---|---|---|---|

| 문제점 | 프록시 장애 | 사이드카 프록시 오작동 | 서비스 통신 중단 | 헬스체크, 모니터링 | 이중화, 자동 재시작 | 프록시 재배포, 우회 경로 |

| 문제점 | 구성 오류 | 잘못된 라우팅 규칙 | 트래픽 미스라우팅 | 구성 검증, 테스트 | 자동 검증, 단계적 배포 | 롤백, 올바른 구성 적용 |

| 문제점 | 인증서 만료 | mTLS 인증서 갱신 실패 | 서비스 간 통신 차단 | 인증서 모니터링 | 자동 갱신, 알림 설정 | 수동 갱신, 임시 인증서 |

| 문제점 | 컨트롤 플레인 장애 | 컨트롤 플레인 서비스 중단 | 새 정책 배포 불가 | 헬스체크, 로그 모니터링 | 고가용성 구성 | 백업 복구, 서비스 재시작 |

분류 기준에 따른 종류 및 유형

| 분류 기준 | 종류/유형 | 설명 | 대표 제품 |

|---|---|---|---|

| 아키텍처 | 사이드카 기반 | 각 서비스와 함께 프록시 배포 | Istio, Linkerd |

| 아키텍처 | 앰비언트 | 노드 레벨에서 프록시 동작 | Istio Ambient |

| 배포 방식 | 오픈소스 | 무료 사용 가능 | Istio, Linkerd, Consul |

| 배포 방식 | 상용 솔루션 | 엔터프라이즈 지원 포함 | Gloo Mesh, Kong Mesh |

| 복잡도 | 경량형 | 기본 기능에 집중 | Linkerd |

| 복잡도 | 완전 기능형 | 모든 기능 포함 | Istio |

| 플랫폼 | Kubernetes 전용 | K8s에서만 동작 | Linkerd 2 |

| 플랫폼 | 멀티 플랫폼 | K8s, VM 모두 지원 | Istio, Consul |

실무 사용 예시

| 사용 목적 | 함께 사용하는 기술 | 효과 |

|---|---|---|

| 마이크로서비스 보안 | Kubernetes, mTLS, RBAC | 제로 트러스트 보안 구현 |

| 카나리 배포 | GitOps, Argo Rollouts | 안전한 배포 자동화 |

| 멀티 클러스터 관리 | Kubernetes Federation | 하이브리드 클라우드 연결 |

| API 게이트웨이 연동 | Kong, Ambassador | 동서/남북 트래픽 통합 관리 |

| 관찰성 강화 | Prometheus, Grafana, Jaeger | 분산 시스템 모니터링 |

활용 사례

Netflix의 마이크로서비스 보안 강화 사례

Netflix는 수천 개의 마이크로서비스를 운영하면서 서비스 간 보안을 강화하기 위해 서비스 메시를 도입했습니다.

시스템 구성:

- Kubernetes 클러스터에 Istio 배포

- 모든 마이크로서비스에 Envoy 사이드카 자동 주입

- mTLS를 통한 서비스 간 암호화 통신

- RBAC 기반 세밀한 권한 제어

graph TB

subgraph "Netflix 서비스 메시 아키텍처"

subgraph "Istio Control Plane"

Istiod[Istiod<br/>- 인증서 관리<br/>- 정책 배포]

end

subgraph "Video Service Cluster"

VS[Video Service]

VSP[Envoy Proxy]

end

subgraph "User Service Cluster"

US[User Service]

USP[Envoy Proxy]

end

subgraph "Recommendation Service"

RS[Recommendation Service]

RSP[Envoy Proxy]

end

Istiod --> VSP

Istiod --> USP

Istiod --> RSP

VSP -.mTLS.-> USP

USP -.mTLS.-> RSP

RSP -.mTLS.-> VSP

end

Workflow:

- 사용자 요청이 User Service로 전달

- User Service가 Video Service 호출 시 mTLS 인증

- Video Service가 Recommendation Service와 통신

- 모든 통신이 암호화되고 정책에 따라 제어

- 텔레메트리 데이터를 통한 실시간 모니터링

비교 분석:

- 도입 전: 개별 서비스에서 보안 구현, 일관성 부족

- 도입 후: 중앙 집중식 보안 정책, 99.9% 트래픽 암호화 달성

구현 예시

| |

| |

도전 과제

1. 성능 최적화

- 원인: 사이드카 프록시로 인한 지연 시간 증가

- 영향: 응답 시간 10-20% 증가 가능

- 해결 방법: 앰비언트 메시 도입, 프록시 최적화

2. 멀티 클러스터 관리

- 원인: 여러 클러스터 간 서비스 메시 연동 복잡성

- 영향: 운영 복잡성 증가, 일관성 유지 어려움

- 해결 방법: 연합 서비스 메시, 통합 관리 도구

3. 에지 컴퓨팅 지원

- 원인: 리소스 제약적 환경에서 서비스 메시 동작

- 영향: 성능 저하, 리소스 부족

- 해결 방법: 경량화된 프록시, 선택적 기능 적용

실무에서 효과적으로 적용하기 위한 고려사항 및 주의할 점

| 카테고리 | 항목 | 고려사항 | 권장사항 |

|---|---|---|---|

| 도입 계획 | 단계적 적용 | 모든 서비스에 한번에 적용하지 말고 점진적 도입 | 파일럿 서비스 선정 → 핵심 서비스 → 전체 확산 |

| 성능 관리 | 리소스 모니터링 | 사이드카 프록시의 CPU/메모리 사용량 지속 모니터링 | 리소스 제한 설정, 알림 임계값 구성 |

| 보안 설정 | mTLS 구성 | 인증서 관리 및 자동 갱신 체계 구축 | 짧은 인증서 수명 + 자동 갱신 설정 |

| 팀 역량 | 교육 계획 | 개발/운영팀의 서비스 메시 이해도 향상 | 단계별 교육 프로그램, 실습 환경 제공 |

| 장애 대응 | 백업 계획 | 서비스 메시 장애 시 우회 경로 확보 | 메시 비활성화 시나리오, 레거시 라우팅 유지 |

최적화하기 위한 고려사항 및 주의할 점

| 카테고리 | 항목 | 고려사항 | 권장사항 |

|---|---|---|---|

| 성능 최적화 | 프록시 튜닝 | Envoy 프록시 설정 최적화 | 커넥션 풀, 버퍼 크기, 타임아웃 조정 |

| 리소스 최적화 | 메모리 관리 | 사이드카별 메모리 사용량 최적화 | 불필요한 기능 비활성화, 리소스 제한 설정 |

| 네트워크 최적화 | 트래픽 라우팅 | 지연 시간 최소화를 위한 라우팅 전략 | 지역별 라우팅, 친화성 기반 로드 밸런싱 |

| 관찰성 최적화 | 메트릭 수집 | 필요한 메트릭만 선별적 수집 | 샘플링 비율 조정, 불필요한 라벨 제거 |

| 확장성 최적화 | 수평 확장 | 컨트롤 플레인의 확장성 확보 | 다중 인스턴스 구성, 로드 밸런싱 적용 |

기타 사항

최신 기술 동향:

eBPF 기반 서비스 메시

- 커널 레벨에서 동작하는 고성능 프록시

- Cilium Service Mesh 등에서 채택

WebAssembly (WASM) 확장

- 프록시 기능의 동적 확장 가능

- 다양한 언어로 확장 기능 개발

AI/ML 기반 최적화

- 트래픽 패턴 학습을 통한 자동 최적화

- 이상 탐지 및 예측적 스케일링

주제와 관련하여 주목할 내용

| 카테고리 | 주제 | 항목 | 설명 |

|---|---|---|---|

| 보안 | 제로 트러스트 | mTLS, RBAC | 모든 통신을 암호화하고 인증하는 보안 모델 |

| 성능 | 앰비언트 메시 | Sidecarless | 사이드카 없이 노드 레벨에서 동작하는 새로운 아키텍처 |

| 표준화 | SMI | Service Mesh Interface | 벤더 중립적 서비스 메시 표준 인터페이스 |

| 관찰성 | 분산 트레이싱 | Jaeger, Zipkin | 마이크로서비스 간 요청 추적 및 성능 분석 |

| 배포 | GitOps | ArgoCD, Flux | 선언적 구성 관리 및 자동 배포 |

주제와 관련하여 반드시 학습해야할 내용

| 카테고리 | 주제 | 항목 | 설명 |

|---|---|---|---|

| 기초 이론 | 마이크로서비스 | 아키텍처 패턴 | 서비스 메시의 기반이 되는 아키텍처 이해 |

| 컨테이너 | Kubernetes | 오케스트레이션 | 서비스 메시가 주로 동작하는 플랫폼 |

| 네트워킹 | 프록시 패턴 | Envoy, NGINX | 서비스 메시의 핵심 구성 요소 |

| 보안 | TLS/mTLS | 암호화 통신 | 서비스 간 보안 통신의 기본 원리 |

| 모니터링 | 관찰성 | 메트릭, 로그, 트레이싱 | 시스템 상태 파악을 위한 필수 요소 |

| 배포 | CI/CD | 파이프라인 | 서비스 메시와 통합된 배포 자동화 |

용어 정리

| 카테고리 | 용어 | 설명 |

|---|---|---|

| 아키텍처 | 사이드카 패턴 (Sidecar Pattern) | 메인 애플리케이션과 함께 배포되는 보조 컨테이너 패턴 |

| 아키텍처 | 앰비언트 메시 (Ambient Mesh) | 사이드카 없이 노드 레벨에서 동작하는 서비스 메시 |

| 구성요소 | 데이터 플레인 (Data Plane) | 실제 트래픽을 처리하는 프록시들의 집합 |

| 구성요소 | 컨트롤 플레인 (Control Plane) | 데이터 플레인을 관리하고 정책을 배포하는 중앙 제어 시스템 |

| 보안 | 상호 TLS (Mutual TLS, mTLS) | 양방향 인증을 통한 안전한 통신 프로토콜 |

| 보안 | 제로 트러스트 (Zero Trust) | 모든 통신을 신뢰하지 않고 검증하는 보안 모델 |

| 프록시 | Envoy | 고성능 L7 프록시, 서비스 메시의 표준 데이터 플레인 |

| 배포 | 카나리 배포 (Canary Deployment) | 신 버전을 일부 트래픽에만 점진적으로 배포하는 방식 |

| 모니터링 | 텔레메트리 (Telemetry) | 시스템에서 자동으로 수집되는 메트릭, 로그, 트레이스 데이터 |

| 표준 | SMI (Service Mesh Interface) | 서비스 메시 간 상호 운용성을 위한 표준 API |

참고 및 출처

- Tigera - Service Mesh Architecture: Components & Design Considerations

- Istio 공식 문서 - The Istio Service Mesh

- Solo.io - Service Mesh Architecture: 3 Key Components and Design Factors

- Layer5 - Service Mesh Architecture and Components

- AWS - What is Service Mesh?

- Kong - Beginner’s Guide: What is a Service Mesh?

- Aqua Security - Service Mesh: Architecture, Concepts, and Top 4 Frameworks

- Red Hat - What is a service mesh?

- Dynatrace - What is a service mesh? Service mesh benefits and how to overcome their challenges

- E-SPIN Group - Service Mesh: How It Works and Why It Matters

1. 주제 분류의 적절성 분석

서비스 메시 (Service Mesh) 는 “Computer Science and Engineering > DevOps and Infrastructure > Cloud Native Platforms” 분류에 매우 적합합니다.

- 서비스 메시는 마이크로서비스 아키텍처 (Microservices Architecture) 에서 서비스 간 통신, 보안, 트래픽 관리, 관측성 (Observability) 등을 담당하는 인프라 계층으로, 클라우드 네이티브 환경에서 핵심 역할을 합니다 1[8][17].

- DevOps 및 인프라스트럭처 관점에서 서비스 메시 도입은 운영 자동화, 배포 효율화, 장애 복원력 강화 등과 밀접하게 연결됩니다.

- Kubernetes(쿠버네티스) 등 클라우드 네이티브 플랫폼에서 서비스 메시가 표준적으로 활용되고 있어, 해당 분류가 논리적으로 타당합니다 [3][17][31].

2. 주제 요약 (200 자 내외)

서비스 메시 (Service Mesh) 는 마이크로서비스 아키텍처에서 서비스 간 통신을 추상화하고 관리하는 인프라 계층입니다. 트래픽 제어, 보안, 장애 복구, 관측성 등 핵심 기능을 제공하여 복잡한 분산 시스템의 운영 효율성과 안정성을 높입니다 1[8][17].

3. 전체 개요 (250 자 내외)

서비스 메시 (Service Mesh) 는 클라우드 네이티브 및 마이크로서비스 환경에서 서비스 간 통신의 복잡성을 해소하기 위해 등장한 인프라 계층입니다. 데이터 플레인 (Data Plane) 과 컨트롤 플레인 (Control Plane) 구조로, 트래픽 관리, 보안, 장애 복원력, 관측성 등 다양한 기능을 제공합니다. 개발자는 비즈니스 로직에 집중할 수 있고, 운영자는 네트워크 정책과 모니터링을 일관성 있게 적용할 수 있습니다. Istio, Linkerd, Consul 등이 대표적인 구현체입니다 1[8][17].

4. 핵심 개념

- **서비스 메시 (Service Mesh)**란 마이크로서비스 간 통신을 추상화하여 관리하는 인프라 계층입니다.

- 주요 목적은 서비스 간 트래픽 제어, 보안 (암호화, 인증, 권한 부여), 장애 복원력 (재시도, 서킷 브레이커), 관측성 (로깅, 트레이싱, 메트릭) 제공입니다 1[8][17].

- 구조는 데이터 플레인 (프록시, 사이드카) 과 컨트롤 플레인 (정책, 설정 관리) 으로 나뉩니다 2[14].

- **사이드카 패턴 (Sidecar Pattern)**을 통해 각 서비스 인스턴스 옆에 프록시를 배치하여 트래픽을 제어합니다 3[16].

- **API 게이트웨이 (API Gateway)**와 달리, 서비스 메시의 적용 범위는 마이크로서비스 내부 통신에 집중됩니다 7[18].

5. 상세 조사 및 정리

배경 및 필요성

- 마이크로서비스 아키텍처 확산으로 서비스 간 통신의 복잡성, 보안, 장애 관리, 트래픽 제어, 관측성 등이 중요한 과제로 부상 14[17].

- 기존 방식 (직접 호출, 라이브러리 내장) 으로는 확장성과 일관성, 장애 대응, 보안 적용에 한계가 있음 510.

주요 기능 및 역할

- 트래픽 라우팅 및 로드 밸런싱

- 서비스 디스커버리 (자동 등록/탐색)

- 보안 (mTLS, 인증, 권한 부여)

- 장애 복원력 (서킷 브레이커, 리트라이, 타임아웃)

- 관측성 (로깅, 트레이싱, 메트릭 수집)16[12][17]

특징 및 원칙

- 인프라 계층에서 서비스 간 통신을 추상화

- 언어, 프레임워크에 독립적

- 일관된 정책 적용 가능

- 확장성과 유연성 제공

구조 및 아키텍처

구성 요소

| 구분 | 구성 요소 | 기능 및 역할 |

|---|---|---|

| 필수 | 데이터 플레인 | 서비스 사이의 트래픽을 실제로 처리하는 프록시 (일반적으로 사이드카 형태) |

| 필수 | 컨트롤 플레인 | 정책, 설정, 인증서 관리, 프록시 제어 등 데이터 플레인 관리 |

| 선택 | 관리 플레인 | 대규모 환경에서 여러 컨트롤 플레인을 통합 관리 (일부 구현체에서만 제공) |

다이어그램 (Mermaid)

flowchart LR

subgraph Control Plane

CP1(Control Plane)

end

subgraph Data Plane

S1(Service A)

P1(Sidecar Proxy A)

S2(Service B)

P2(Sidecar Proxy B)

end

S1 P1

S2 P2

P1 P2

CP1 -- 정책/설정 --> P1

CP1 -- 정책/설정 --> P2

주요 원리 및 작동 원리

- 모든 서비스 트래픽은 사이드카 프록시를 통해 흐름

- 컨트롤 플레인은 정책, 라우팅, 인증 정보를 프록시에 배포

- 데이터 플레인은 실제 트래픽을 처리, 모니터링, 로깅, 장애 복구 등 수행 2[14][16]

작동 원리 다이어그램 (Mermaid)

sequenceDiagram

participant Client

participant ProxyA as Sidecar Proxy A

participant ServiceA

participant ProxyB as Sidecar Proxy B

participant ServiceB

Client->>ProxyA: 요청

ProxyA->>ProxyB: 트래픽 라우팅/보안/로깅

ProxyB->>ServiceB: 요청 전달

ServiceB-->>ProxyB: 응답

ProxyB-->>ProxyA: 응답 전달

ProxyA-->>Client: 응답

구현 기법 및 예시

| 구현 기법 | 정의 및 구성 | 목적 | 실제 예시 (시나리오) |

|---|---|---|---|

| 사이드카 패턴 | 각 서비스 인스턴스 옆에 프록시 컨테이너 배치 | 트래픽 제어, 장애 복원, 보안 강화 | Istio, Linkerd, Consul Connect |

| Mesh-Native Code | 벤더가 제공하는 서비스 메시 (플랫폼 제어) | 플랫폼 일체형 통합 관리 | Azure Service Fabric |

| Mesh-Aware Code | 개발자가 직접 코드에 통신 로직 내장 | 커스텀 통신/제어 | Spring Cloud Netflix Eureka |

| Mesh-Agnostic Code | 사이드카 인젝션으로 관리자가 임의로 설정 | 유연한 관리/운영 | Istio, Envoy, Consul |

Python 구현 예시

| |

장점과 단점

| 구분 | 항목 | 설명 |

|---|---|---|

| ✅ 장점 | 트래픽 관리 | 서비스 간 요청을 효율적으로 라우팅 및 로드 밸런싱 |

| ✅ 장점 | 보안 강화 | 서비스 간 mTLS 암호화를 통한 보안 통신 제공 |

| ✅ 장점 | 장애 복원력 | 서킷 브레이커, 재시도, 타임아웃 등 장애 복구 기능 제공 |

| ⚠ 단점 | 복잡성 증가 | 서비스 메시 도입으로 인한 시스템 복잡성 증가 |

| ⚠ 단점 | 네트워크 오버헤드 | 사이드카 프록시로 인한 네트워크 오버헤드 발생 |

| ⚠ 단점 | 학습 곡선 | 서비스 메시 이해 및 운영에 대한 학습 곡선 존재 |

단점 해결 방법

- 복잡성: 자동화 도구, 문서화, 베스트 프랙티스 도입

- 네트워크 오버헤드: 경량화된 프록시 사용, 트래픽 최적화

- 학습 곡선: 체계적인 교육, 샘플 프로젝트, 커뮤니티 활용 [14]

도전 과제 및 해결책

| 도전 과제 | 설명 | 해결책 |

|---|---|---|

| 운영 복잡성 | 대규모 서비스 메시 관리, 설정, 배포의 복잡성 | 자동화 도구, 정책 관리 플랫폼 도입 |

| 성능 저하 | 프록시 추가로 인한 네트워크 지연, 리소스 사용 증가 | 경량 프록시, 네트워크 최적화, 리소스 모니터링 |

| 장애 진단 | 장애 발생 시 원인 추적의 어려움 | 분산 트레이싱, 로깅, 모니터링 도구 활용 |

| 보안 정책 일관성 | 다양한 서비스에 일관된 보안 정책 적용의 어려움 | 중앙집중 정책 관리, mTLS 자동화 |

분류 기준에 따른 종류 및 유형

| 분류 기준 | 유형 | 설명 | 대표 예시 |

|---|---|---|---|

| 구현 방식 | 사이드카 (Proxy) | 각 서비스에 프록시 컨테이너 배치 | Istio, Linkerd |

| 라이브러리 내장형 | 서비스 코드에 직접 통신 로직 내장 | Spring Cloud Netflix | |

| 플랫폼 내장형 | 플랫폼 (벤더) 에서 직접 제공 | Azure Service Fabric | |

| 배포 환경 | 온프레미스 | 자체 인프라에 직접 배포 | Istio, Consul |

| 클라우드 매니지드 | 클라우드 벤더가 관리/제공 | AWS App Mesh |

실무 적용 예시

| 적용 분야 | 적용 목적 | 활용 기능 | 대표 솔루션 |

|---|---|---|---|

| 금융권 | 내부 서비스 통신 보안 강화 | mTLS, 인증, 트래픽 관리 | Istio, Consul |

| 이커머스 | 장애 복원력, 트래픽 분산 | 서킷 브레이커, 로드밸런싱 | Linkerd |

| SaaS 플랫폼 | 멀티테넌시, 관측성 | 트레이싱, 메트릭, 정책관리 | Istio |

| 게임 서버 | 실시간 트래픽 제어 | 로드밸런싱, 장애 복구 | Consul |

활용 사례 (금융권 내부 서비스 통신 보안 강화)

- 시스템 구성: Istio 기반 서비스 메시, 각 서비스 앞단에 Envoy 프록시 (사이드카), 중앙 컨트롤 플레인

- 시스템 구성 다이어그램 (Mermaid)

flowchart LR

subgraph Control Plane

CP(Control Plane)

end

subgraph Data Plane

F1(Frontend Service)

P1(Envoy Proxy)

B1(Backend Service)

P2(Envoy Proxy)

end

F1 P1

B1 P2

P1 P2

CP -- 정책/설정 --> P1

CP -- 정책/설정 --> P2

- Workflow

- 사용자가 프론트엔드 서비스에 접근

- 프론트엔드 서비스의 사이드카 프록시가 트래픽을 캡처

- 내부 인증/암호화 (mTLS) 적용 후 백엔드 서비스로 전달

- 백엔드 서비스 응답도 프록시를 통해 암호화되어 전달

- 모든 트래픽은 로깅 및 트레이싱되어 장애 추적 가능

- 주요 역할

- mTLS 기반 보안 통신

- 트래픽 라우팅 및 장애 복원력 제공

- 실시간 모니터링 및 장애 진단

실무에서 효과적으로 적용하기 위한 고려사항 및 주의할 점

| 항목 | 설명 | 권장사항 |

|---|---|---|

| 도입 목적 명확화 | 서비스 메시 도입의 목표 (보안, 트래픽 관리 등) 명확히 설정 | 사전 요구사항 분석 및 목표 정의 |

| 인프라 리소스 확인 | 프록시 추가에 따른 리소스 사용 증가 | 리소스 모니터링 및 스케일링 정책 적용 |

| 네트워크 구조 설계 | 프록시 배치, 트래픽 흐름 설계 필요 | 네트워크 토폴로지 사전 설계 |

| 운영 자동화 | 복잡한 운영/배포 자동화 필요 | CI/CD, IaC(Infrastructure as Code) 활용 |

| 장애 대응 체계 구축 | 장애 발생 시 빠른 진단 및 복구 체계 필요 | 분산 트레이싱, 모니터링 도구 도입 |

최적화하기 위한 고려사항 및 주의할 점

| 항목 | 설명 | 권장사항 |

|---|---|---|

| 프록시 경량화 | 네트워크 오버헤드 및 지연 최소화 | 경량화 프록시 (Envoy 등) 사용 |

| 정책 관리 일관성 | 서비스별 정책 일관성 유지 필요 | 중앙집중 정책 관리 플랫폼 활용 |

| 트래픽 모니터링 | 실시간 트래픽, 장애, 성능 모니터링 필요 | 메트릭, 로깅, 트레이싱 도구 연동 |

| 보안 자동화 | 인증서 갱신, mTLS 적용 자동화 필요 | 자동화 도구 및 스크립트 활용 |

| 점진적 도입 | 전체 서비스 일괄 적용보다는 단계적 도입 권장 | 파일럿 프로젝트, 점진적 확장 적용 |

기타 사항: 문제 및 해결 방법

| 문제 | 원인 | 영향 | 탐지/진단 | 예방/해결 방법 |

|---|---|---|---|---|

| 프록시 장애 | 프록시 컨테이너 다운 등 | 서비스 간 통신 중단 | 모니터링, 헬스체크 | 자동 재시작, 이중화 |

| 정책 불일치 | 컨트롤 플레인 설정 오류 | 트래픽 라우팅 오류 | 설정 검증, 테스트 | 정책 검증 자동화, 롤백 |

| 성능 저하 | 네트워크 오버헤드 | 응답 지연, 리소스 과다 사용 | 메트릭 분석, 트레이싱 | 프록시 최적화, 리소스 증설 |

| 보안 취약점 | 인증 미적용, mTLS 미구현 | 데이터 유출, 공격 위험 | 취약점 스캔, 로그 분석 | mTLS 적용, 정책 자동화 |

6. 추가 조사 내용

추가 조사 요청이 없으므로 생략

7. 추가 학습/조사 필요 주제

| 카테고리 | 간략한 설명 | 주제 |

|---|---|---|

| 오픈소스 솔루션 | 서비스 메시 대표 오픈소스 및 특성 비교 | Istio, Linkerd, Consul |

| 보안 | mTLS, 인증, 권한 부여 정책 심화 | 서비스 메시 보안 |

| 관측성/모니터링 | 분산 트레이싱, 메트릭, 로깅 도구 연계 | Jaeger, Prometheus |

| DevOps 통합 | CI/CD, IaC 등 자동화와의 연계 | 서비스 메시와 DevOps |

| API 게이트웨이와 비교 | API 게이트웨이와 서비스 메시의 차이 및 통합 아키텍처 설계 | API Gateway vs Service Mesh |

8. 주목할 내용 표

| 주제 | 항목 | 설명 |

|---|---|---|

| 아키텍처 패턴 | 사이드카 패턴 | 각 서비스 인스턴스 옆에 프록시 배치, 트래픽 제어 및 보안 강화 |

| 보안 | mTLS | 서비스 간 트래픽 암호화, 인증 및 권한 부여 지원 |

| 장애 복원력 | 서킷 브레이커, 리트라이 | 장애 발생 시 자동 복구, 요청 재시도 등 장애 전파 방지 |

| 관측성 | 트레이싱, 메트릭 | 서비스 간 트래픽, 성능, 장애 모니터링 및 분석 |

| DevOps 연계 | 자동화, IaC | 운영 효율화, 배포 자동화, 정책 관리 최적화 |

| API Gateway 와의 차이 | 적용 위치, 목적 | API Gateway: 외부 트래픽, Service Mesh: 내부 트래픽 관리 |

용어 정리

| 카테고리 | 용어 | 설명 |

|---|---|---|

| 구조 | 데이터 플레인 (Data Plane) | 실제 서비스 간 트래픽을 처리하는 프록시 계층 (일반적으로 사이드카 형태) |

| 구조 | 컨트롤 플레인 (Control Plane) | 데이터 플레인 (프록시) 의 정책, 설정, 인증서 등을 관리하는 계층 |

| 패턴 | 사이드카 (Sidecar) | 각 서비스 인스턴스 옆에 배치되는 프록시 컨테이너 또는 프로세스 |

| 보안 | mTLS(Mutual TLS) | 서비스 간 상호 인증 및 암호화 통신을 위한 프로토콜 |

| 관측성 | 트레이싱 (Tracing) | 분산 환경에서 요청의 흐름을 추적하는 기능 |

| 관측성 | 메트릭 (Metric) | 서비스 간 트래픽, 지연, 오류율 등 성능 지표 수집 기능 |

| 장애복구 | 서킷 브레이커 (Circuit Breaker) | 장애 발생 시 서비스 요청을 차단하여 장애 전파를 방지하는 패턴 |

| 비교 | API 게이트웨이 (API Gateway) | 외부 클라이언트와 내부 서비스 간 트래픽을 관리하는 중앙 집중형 게이트웨이 |

| 비교 | 서비스 메시 (Service Mesh) | 마이크로서비스 내부 서비스 간 통신을 관리하는 인프라 계층 |

참고 및 출처

- Red Hat 서비스 메시 개념 및 기능

- API7 서비스 메시란 무엇인가?

- F-Lab API 게이트웨이와 서비스 메시의 역할과 구현 방법

- 삼성SDS 서비스 메시 인사이트

- AWS 서비스 메시란 무엇인가요?

- Microsoft Learn 서비스 메시 통신 인프라

- 티스토리: Service Mesh의 구성 요소와 동작 과정

- 티스토리: Service Mesh vs Api Gateway

- 티스토리: 서비스 메시(Service Mesh)

- Velog: MSA 정리 - (5) Service Mesh

- NGINX Store: Service Mesh 이해하기, 1부

- 티스토리: [Service Mesh]서비스 메시란?

- 티스토리: CLOUD 서비스 메시 (Service Mesh)

1 https://www.redhat.com/ko/topics/microservices/what-is-a-service-mesh

2 https://junwork123.tistory.com/97

3 https://api7.ai/ko/blog/what-is-service-mesh

4 https://velog.io/@gun_123/Service-Mesh-%EC%84%9C%EB%B9%84%EC%8A%A4-%EB%A9%94%EC%8B%9C-%EB%A7%88%EC%9D%B4%ED%81%AC%EB%A1%9C%EC%84%9C%EB%B9%84%EC%8A%A4-%EC%95%84%ED%82%A4%ED%85%8D%EC%B2%98%EC%9D%98-%ED%95%B5%EC%8B%AC-%EA%B5%AC%EC%84%B1-%EC%9A%94%EC%86%8C

5 https://well-made-codestory.tistory.com/28

6 https://nothing-study.tistory.com/19

7 https://kkongchii.tistory.com/entry/CLOUD-%EC%84%9C%EB%B9%84%EC%8A%A4-%EB%A9%94%EC%8B%9C-Service-Mesh

8 https://itpe.jackerlab.com/entry/%EC%84%9C%EB%B9%84%EC%8A%A4-%EB%A9%94%EC%8B%9CService-Mesh

9 https://lati-tech.tistory.com/1

10 https://aigishoo.tistory.com/17

[11] https://sharplee7.tistory.com/70

[12] https://velog.io/@hwang95/MSA-%EC%9D%B4%ED%95%B4%ED%95%98%EA%B8%B0-5-Service-Mesh

[13] https://aws.amazon.com/ko/what-is/service-mesh/

[14] https://f-lab.kr/insight/api-gateway-service-mesh-20241218

[15] https://waspro.tistory.com/434

[16] https://learn.microsoft.com/ko-kr/dotnet/architecture/cloud-native/service-mesh-communication-infrastructure

[17] https://www.samsungsds.com/kr/insights/service_mesh.html

[18] https://somaz.tistory.com/177

[19] https://nginxstore.com/blog/microservices/service-mesh-%EC%9D%B4%ED%95%B4%ED%95%98%EA%B8%B0-1%EB%B6%80/

[20] https://hyogu.tistory.com/46

[21] https://docs.redhat.com/ko/documentation/openshift_container_platform/4.9/html/service_mesh/ossm-architecture

[22] https://sarc.io/index.php/cloud/2233-service-mesh

[23] https://velog.io/@tmddud73/Docker1-%EC%BB%A8%ED%85%8C%EC%9D%B4%EB%84%88%EC%9D%98-%EA%B0%9C%EB%85%90

[24] https://blog.naver.com/freepsw/221919196101

[25] https://nginxstore.com/blog/nginx/service-mesh-%EC%9D%B4%ED%95%B4%ED%95%98%EA%B8%B0-2%EB%B6%80-%EA%B0%80%EC%9A%A9%EC%84%B1/

[26] https://www.msap.ai/general/notice/msa-guidebook/

[27] https://sphong0417.tistory.com/7

[28] https://s-core.co.kr/insight/view/msa%EC%99%80-%EB%B6%84%EC%82%B0-%EC%95%84%ED%82%A4%ED%85%8D%EC%B2%98-%EC%88%98%EC%9A%A9%EC%9D%84-%EC%9C%84%ED%95%9C-%EB%B0%A9%EB%B2%95-%EC%84%9C%EB%B9%84%EC%8A%A4-%EB%A9%94%EC%89%AC%EC%99%80/

[29] https://www.jaenung.net/tree/3610

[30] https://ydy1201.tistory.com/89

[31] learning.backend_development

다음은 **" 서비스 메시 (Service Mesh)"**에 대한 정리 및 분석 결과입니다.

1. 주제의 분류 분석

분류:

“Computer Science and Engineering” > “DevOps and Infrastructure” > “Cloud Native Platforms” 는 적절합니다.

분석 근거:

서비스 메시는 클라우드 네이티브 환경, 특히 컨테이너화된 마이크로서비스 아키텍처에서 통신 제어, 가시성, 보안, 신뢰성을 담당하는 인프라 계층입니다. Kubernetes 와 같은 오케스트레이션 시스템 위에서 동작하며, 네트워크 인프라와 애플리케이션 계층 사이에서 작동하므로 DevOps 및 클라우드 네이티브 인프라에 속하는 것이 합당합니다.

2. 요약 설명 (200 자 이내)

서비스 메시는 마이크로서비스 간 통신을 추상화하고 제어하는 인프라 계층으로, 트래픽 관리, 보안, 모니터링을 제공하여 애플리케이션 개발자의 부담을 줄이고 운영을 단순화한다.

3. 개요 설명 (250 자 이내)

서비스 메시 (Service Mesh) 는 클라우드 네이티브 아키텍처에서 마이크로서비스 간 통신을 제어·관찰·보안하는 네트워크 계층 인프라다. 서비스 메시를 사용하면 서비스 간 트래픽을 세밀하게 제어하고, 인증·암호화 등 보안을 강화하며, 서비스 상태 모니터링을 손쉽게 수행할 수 있다. Istio, Linkerd 등이 대표적이다.

4. 핵심 개념

개념 정의

**서비스 메시 (Service Mesh)**는 애플리케이션 코드와 별도로 서비스 간 통신을 처리하고 제어하는 인프라 계층.

사이드카 프록시 (Sidecar Proxy) 패턴을 활용해 마이크로서비스 간 트래픽을 투명하게 가로채고 관리함.

실무 중심 이해

보안: TLS 기반의 **mTLS (Mutual TLS)**로 모든 서비스 통신 암호화.

트래픽 제어: A/B 테스트, Canary 배포, Circuit Breaking 등을 네트워크 단에서 제어 가능.

관측성: 분산 트레이싱, 메트릭 수집, 로깅 기능 통합.

핵심 기술

Envoy 프록시, Istio, Linkerd, Consul Connect, Kuma

Kubernetes 기반 컨테이너 환경에서의 통합이 용이

이제 이어서 “## 5. 주제와 관련하여 조사할 내용 " 부터 “## 7. 참고 사항 " 에 따라 상세 항목을 순차적으로 정리하겠습니다.

다음은 " 서비스 메시 (Service Mesh)” 에 대한 세부 조사 내용을 참고 지침에 맞춰 체계적으로 정리한 내용입니다.

✅ 핵심 정리 (요약된 조사 구조)

1. 핵심 개념, 배경, 목적 및 필요성

📌 핵심 개념

서비스 메시는 마이크로서비스 간 통신을 통합 관리하기 위한 인프라 계층으로, 애플리케이션 외부에서 트래픽을 감시·제어한다.

사이드카 프록시 (Sidecar Proxy) 패턴으로 각 서비스 옆에 네트워크 프록시를 배치하여 통신 흐름을 투명하게 관리한다.

📌 배경

마이크로서비스의 확산으로 인해 서비스 간 통신의 복잡성 증가, 장애 전파, 보안 이슈 발생.

이러한 문제를 코드가 아닌 플랫폼 레벨에서 해결하려는 요구에서 탄생.

📌 목적 및 필요성

통신의 안정성과 보안 확보

운영 자동화 및 가시성 확보

코드와 운영 로직의 분리 (Separation of Concerns)

2. 주요 기능 및 역할

| 기능 | 설명 |

|---|---|

| 트래픽 관리 | 요청 라우팅, 리트라이, 타임아웃, Circuit Breaker 설정 등 |

| 서비스 디스커버리 | 서비스 동적 탐색 및 로드밸런싱 지원 |

| 보안 | TLS/mTLS 를 통한 암호화 통신, 인증·인가 정책 관리 |

| 관측성 (Observability) | 분산 트레이싱, 메트릭 수집, 로그 수집 |

| 정책 제어 | 접근 제어, 속도 제한, 인증 정책 등 제어 가능 |

3. 특징

플랫폼 독립성: 앱 코드와 무관하게 동작

프록시 기반 아키텍처: Envoy, Linkerd-proxy 등 사용

자동화 가능: 보안·모니터링·배포 전략 자동화

세밀한 제어: 요청 단위 수준의 제어 가능

4. 핵심 원칙 및 작동 원리

핵심 원칙

Zero Trust 네트워크 모델

투명성: 개발자는 프록시를 직접 다루지 않음

표준화된 통신 관리

작동 원리 (다이어그램)

flowchart LR

A[Client Service] --> B[Sidecar Proxy A]

B --> C[Sidecar Proxy B]

C --> D[Server Service]

B <--> Z[Service Mesh Control Plane]

C <--> Z

각 서비스에 사이드카 (프록시) 가 삽입되고, 모든 통신은 사이드카를 통해 흐름 제어됨

제어 플레인 (Control Plane) 이 정책 및 설정을 사이드카에 전달

5. 구조 및 아키텍처

💡 구성 요소

| 구분 | 구성 요소 | 역할 |

|---|---|---|

| 필수 | 데이터 플레인 (Data Plane) | 실제 트래픽을 처리, Envoy 등 사이드카 |

| 필수 | 제어 플레인 (Control Plane) | 구성·정책 전달, 서비스 디스커버리, 보안 관리 |

| 선택 | Observability 모듈 | Prometheus, Grafana, Jaeger 등 연동 |

| 선택 | Ingress Gateway | 외부 요청을 내부 서비스로 연결 |

아키텍처 다이어그램 (텍스트 버전)

6. 구현 기법

| 기법 | 정의 | 목적 | 예시 |

|---|---|---|---|

| Sidecar Injection | 서비스와 함께 프록시 컨테이너를 배치 | 통신 가로채기 및 제어 | Istio 의 Envoy, Linkerd |

| mTLS 적용 | 서비스 간 암호화된 인증 | Zero Trust 보안 모델 구현 | Istio, Consul Connect |

| 트래픽 쉐이핑 | 흐름 제어, 라우팅 정책 적용 | A/B 테스트, Canary 배포 등 | Istio VirtualService |

| 분산 트레이싱 | 서비스 흐름 추적 | 장애 진단, 병목 분석 | Jaeger, Zipkin 연동 |

7. 장점과 단점

| 구분 | 항목 | 설명 |

|---|---|---|

| ✅ 장점 | 통신 보안 강화 | TLS/mTLS 로 모든 트래픽 암호화 |

| 트래픽 세분화 제어 | Canary, A/B 테스트 손쉬운 구현 | |

| 관측성 향상 | 메트릭·트레이싱 내장 제공 | |

| 플랫폼 독립성 | 앱 코드 변경 없이 적용 가능 | |

| ⚠ 단점 | 복잡도 증가 | 추가 컴포넌트로 인해 관리 부담 |

| 성능 저하 | 프록시 통신으로 인한 레이턴시 발생 | |

| 비용 증가 | CPU/Memory 사용량 증가 |

💡 해결 방법

경량 메시 도입: Linkerd, Kuma 등 경량 메시 사용

자동화 도구 사용: Istio Operator, Helm, GitOps 기반 배포

모니터링 최적화: 프록시 메트릭 필터링으로 부하 감소

계속해서 **서비스 메시 (Service Mesh)**에 대한 조사 내용을 이어 정리하겠습니다.

8. 도전 과제 및 해결 방안

| 도전 과제 | 설명 | 해결책 |

|---|---|---|

| 운영 복잡도 증가 | 다수의 프록시와 제어 플레인 관리 필요 | Helm, Istio Operator, GitOps 도입 |

| 성능 오버헤드 | 프록시로 인한 지연 시간 및 리소스 사용 증가 | 프록시 최적화, mTLS 비활성화 고려 |

| 관측성 노이즈 | 너무 많은 메트릭 및 로그 데이터 생성 | 샘플링 비율 조정, 필터링 설정 |

| 디버깅 어려움 | 네트워크 문제 추적이 어려움 | 분산 트레이싱 적극 활용 (Jaeger, Zipkin) |

| 러닝 커브 | 운영/개발 모두 학습량이 많음 | 점진적 도입, POC(Proof of Concept) 적용 |

9. 분류 기준에 따른 종류 및 유형

| 분류 기준 | 유형 | 설명 |

|---|---|---|

| 배포 모델 | Sidecar 모델 | 각 서비스마다 프록시를 배치 (Istio, Linkerd) |

| Node-level 프록시 | 노드 단위에 프록시 하나를 두는 방식 (Cilium) | |

| 제어 플레인 | 중앙 집중형 | 단일 제어 플레인에서 모든 설정 관리 (Istio) |

| 분산형 | 여러 제어 플레인이 동작 (Consul Connect) | |

| 통합 방식 | Kubernetes 네이티브 | K8s CRD(Custom Resource Definition) 기반 |

| 독립형 | Kubernetes 와 무관하게 구성 가능 |

10. 구현 예시 (Python 기반)

🧪 시나리오: Istio 를 활용한 A/B 테스트용 트래픽 분할

목표: 동일한 서비스에 대해 v1 과 v2 로 트래픽을 80:20 으로 분할

| |

reviews서비스의v1과v2버전에 트래픽을 80:20 으로 분배DestinationRule로 각 subset(v1, v2) 를 정의해야 함

11. 실무 적용 예시

| 산업 | 사용 목적 | 도입 기술 | 효과 |

|---|---|---|---|

| 이커머스 | A/B 테스트, 보안 통신 | Istio | 트래픽 제어 및 mTLS 보안 적용 |

| 금융 | 서비스 간 접근 통제 | Consul Connect | 인증·인가 자동화 |

| 게임 | 실시간 로그 및 트레이싱 | Linkerd + Prometheus | 실시간 모니터링 향상 |

| 플랫폼 | Canary 배포 | Istio + Argo Rollouts | 점진적 릴리스로 장애 감소 |

12. 활용 사례 상세

🎯 쿠팡 (가상의 예시 기반)

시스템 구성

Kubernetes + Istio + Envoy

Observability: Prometheus, Grafana, Jaeger

Argo CD, Argo Rollouts 로 배포 자동화

시스템 구성도 (텍스트)

Workflow

사용자의 요청은 Ingress Gateway 를 통해 들어옴

Gateway 가 서비스로 라우팅하며 사이드카를 거침

트래픽은 설정된 비율에 따라 버전별 서비스로 분기

결과는 Prometheus 와 Jaeger 로 수집 및 분석됨

역할

서비스 간 통신 보안 강화

Canary 배포 및 모니터링 자동화

서비스 오류 발생 시 자동 롤백

13. 실무에서 효과적으로 적용하기 위한 고려사항

| 항목 | 설명 | 권장 사항 |

|---|---|---|

| 네트워크 구성 | CNI 설정과 충돌 여부 확인 | Cilium, Calico 와의 호환성 테스트 |

| 리소스 사용량 | 프록시 오버헤드 고려 | CPU/Mem 모니터링 자동화 |

| 트래픽 분석 | 트래픽 로그 폭증 가능성 있음 | 메트릭 필터, 샘플링 조정 |

| 운영 전략 | 초기 설정 복잡성 존재 | Helm, Operator 사용 권장 |

| 보안 정책 | mTLS 설정 미숙시 장애 발생 | 정책 미리 검증 후 배포 |

14. 최적화하기 위한 고려사항

| 항목 | 설명 | 권장 사항 |

|---|---|---|

| Sidecar 주입 방식 | 자동/수동 주입 선택 | 자동 주입 후 예외 처리 규칙 정의 |

| 프록시 설정 | 디폴트 설정은 리소스 과다 소모 | 필요한 필드만 활성화 |

| 가시성 도구 | 무분별한 트레이싱은 오버헤드 발생 | 샘플링 비율 조정 (10% 추천) |

| 버전 관리 | Control Plane 하위 호환성 주의 | Canary 방식으로 업그레이드 |

| 배포 자동화 | 수동 설정 시 실수 발생 | GitOps + Argo CD 연계 권장 |

15. 기타 사항–문제 탐지 및 예방

| 항목 | 내용 |

|---|---|

| 원인 | 사이드카 주입 실패, 인증 오류 |

| 영향 | 서비스 간 통신 단절, 장애 전파 |

| 탐지 | 트래픽 로그 분석, Control Plane 상태 점검 |

| 예방 | Liveness/Readiness Probe 사용, Canary 방식 적용 |

| 해결 | 프록시 재시작, 설정 롤백, Helm 롤백 기능 활용 |

16. 주제와 관련하여 주목할 내용

| 주제 | 항목 | 설명 |

|---|---|---|

| 기술 | Istio | 가장 널리 쓰이는 오픈소스 서비스 메시 |

| 기술 | Linkerd | 경량 서비스 메시, 성능 최적화 특화 |

| 보안 | mTLS | 양방향 인증 및 암호화로 보안 강화 |

| 도구 | Kiali | Istio 시각화 및 관측성 도구 |

| 아키텍처 | 사이드카 패턴 | 서비스 메시의 기본적인 통신 모델 |

17. 추가로 알아야 할 내용 정리

| 카테고리 | 설명 | 주제 |

|---|---|---|

| 프로토콜 | HTTP/2, gRPC 등 메시 통신 최적화 필요 | 네트워크 |

| 오픈소스 | CNCF 서비스 메시 프로젝트 목록 숙지 | 플랫폼 선택 |

| 보안 정책 | 인증·인가 정책 설계 방법 | 보안 |

| 자동화 | GitOps 기반 운영 및 배포 자동화 | DevOps |

용어 정리

| 카테고리 | 용어 | 설명 |

|---|---|---|

| 네트워크 | 사이드카 (Sidecar) | 주 서비스 옆에 배치되는 보조 컨테이너 |

| 보안 | mTLS | Mutual TLS, 서비스 간 인증/암호화 |

| 관측성 | Tracing | 요청 흐름을 시각화하여 병목/오류 탐색 |

| DevOps | GitOps | Git 을 단일 소스로 하여 자동화 배포 운영 |

| 플랫폼 | Ingress Gateway | 외부 요청을 서비스 메시 내부로 라우팅하는 게이트웨이 |

참고 및 출처

더 필요한 항목이나 심화 주제가 있다면 이어서 도와드리겠습니다.

서비스 메시 (Service Mesh) 에 대해 체계적으로 조사하고 분석해드리겠습니다.이제 서비스 메시에 대한 포괄적인 조사가 완료되었습니다. 수집한 정보를 바탕으로 체계적으로 정리하여 답변드리겠습니다.

1. 주제 분류의 적절성 분석

서비스 메시 (Service Mesh) 의 분류인 “Computer Science and Engineering” > “DevOps and Infrastructure” > “Cloud Native Platforms” 는 매우 적절합니다.

근거:

- 서비스 메시는 클라우드 네이티브 환경에서 마이크로서비스 간 통신을 관리하는 인프라 계층입니다

- 컨테이너 오케스트레이션 플랫폼 (Kubernetes 등) 과 밀접하게 연결되어 작동합니다

- DevOps 운영 관점에서 보안, 관찰성, 트래픽 관리를 담당하는 핵심 인프라 구성요소입니다

- CNCF (Cloud Native Computing Foundation) 프로젝트로 분류되는 Istio, Linkerd 등이 대표적인 구현체입니다

2. 요약 설명 (200 자 내외)

서비스 메시는 마이크로서비스 아키텍처에서 서비스 간 통신을 관리하는 전용 인프라 계층으로, 사이드카 프록시를 통해 트래픽 관리, 보안, 관찰성 기능을 애플리케이션 코드 변경 없이 제공하여 복잡한 분산 시스템의 운영 복잡성을 줄이고 개발자가 비즈니스 로직에 집중할 수 있도록 돕습니다.

3. 개요 (250 자 내외)

서비스 메시는 마이크로서비스 간 통신을 추상화하여 인프라 계층에서 관리하는 아키텍처 패턴입니다. 데이터 플레인의 사이드카 프록시와 컨트롤 플레인의 중앙집중식 관리를 통해 서비스 디스커버리, 로드 밸런싱, 보안 (mTLS), 관찰성, 트래픽 제어 등의 기능을 제공합니다. Netflix, Lyft, Uber 등 대규모 기업에서 채택하여 시스템 안정성과 보안을 향상시키고 있으며, Istio, Linkerd 등이 주요 구현체입니다.

4. 핵심 개념

기본 개념

- 서비스 메시: 마이크로서비스 간 통신을 관리하는 전용 인프라 계층

- 사이드카 프록시: 각 서비스 인스턴스와 함께 배포되어 모든 네트워크 트래픽을 중개하는 프록시

- 데이터 플레인: 실제 트래픽을 처리하는 사이드카 프록시들의 집합

- 컨트롤 플레인: 프록시들을 관리하고 정책을 배포하는 중앙 관리 시스템

심화 개념

- mTLS (mutual TLS): 서비스 간 상호 인증 및 암호화 통신

- 서비스 아이덴티티: 워크로드 기반의 신원 확인 시스템

- 트래픽 정책: 라우팅, 로드 밸런싱, 서킷 브레이킹 등의 규칙

- 관찰성 (Observability): 메트릭, 로그, 분산 추적을 통한 시스템 가시성

제 1 부: 서비스 메시 기본 이해

배경

서비스 메시의 등장 배경은 마이크로서비스 아키텍처의 급속한 채택과 관련이 있습니다. 전통적인 모놀리식 애플리케이션에서 마이크로서비스로 전환하면서 다음과 같은 문제들이 대두되었습니다:

- 서비스 간 통신 복잡성 증가: 수십, 수백 개의 서비스가 네트워크를 통해 통신

- 운영 복잡성: 각 서비스별로 로깅, 모니터링, 보안 구현 필요

- 네트워크 신뢰성 문제: 분산 환경에서의 장애 전파 및 복구 어려움

- 보안 관리 어려움: 서비스별 개별 보안 구현의 일관성 부족

Google, Netflix, Lyft 등의 기업들이 대규모 마이크로서비스 환경을 운영하면서 이러한 문제를 해결하기 위해 서비스 메시 개념을 개발하게 되었습니다.

목적 및 필요성

주요 목적

- 통신 추상화: 서비스 간 통신 로직을 애플리케이션 코드에서 분리

- 운영 단순화: 횡단 관심사를 인프라 계층에서 일괄 처리

- 보안 강화: 제로 트러스트 보안 모델 구현

- 관찰성 향상: 전체 시스템에 대한 통합 모니터링 제공

필요성

- 스케일링 문제 해결: 마이크로서비스 수가 증가할수록 기하급수적으로 복잡해지는 관리 문제

- 개발 생산성 향상: 개발자가 비즈니스 로직에 집중할 수 있도록 지원

- 운영 일관성: 모든 서비스에 동일한 정책과 기준 적용

- 규정 준수: 보안 및 컴플라이언스 요구사항 충족

주요 기능 및 역할

핵심 기능

- 서비스 디스커버리: 동적으로 서비스 위치 파악 및 연결

- 로드 밸런싱: 트래픽을 여러 인스턴스에 분산

- 트래픽 관리: 라우팅, 리트라이, 타임아웃 등 제어

- 보안: mTLS, 인증, 권한 부여 자동화

- 관찰성: 메트릭, 로그, 분산 추적 수집

- 정책 집행: 속도 제한, 서킷 브레이킹 등

주요 역할

- 통신 중개자: 모든 서비스 간 통신을 프록시를 통해 중개

- 보안 게이트웨이: 서비스 간 인증 및 암호화 담당

- 모니터링 허브: 전체 시스템의 통신 패턴 및 성능 데이터 수집

- 정책 집행기: 중앙에서 정의된 정책을 분산 환경에서 집행

특징

- 투명성: 애플리케이션 코드 변경 없이 기능 제공

- 확장성: 마이크로서비스 수가 증가해도 선형적으로 확장

- 플랫폼 중립성: 다양한 언어와 플랫폼에서 동작

- 정책 중심: 선언적 구성을 통한 동작 제어

- 관찰 가능성: 전체 시스템에 대한 통합된 가시성

제 2 부: 아키텍처 및 구성 요소

핵심 원칙

- 관심사 분리: 비즈니스 로직과 통신 로직 분리

- 중앙집중식 제어: 분산된 프록시를 중앙에서 관리

- 제로 트러스트: 모든 통신을 검증하고 암호화

- 관찰 우선: 모든 통신을 모니터링하고 추적

- 정책 기반: 선언적 정책을 통한 동작 제어

주요 원리

사이드카 패턴

graph TB

subgraph "Pod/Container"

A[Application] <--> B[Sidecar Proxy]

end

B <--> C[Network]

subgraph "다른 Pod"

D[Application] <--> E[Sidecar Proxy]

end

E <--> C

작동 원리

sequenceDiagram

participant A as Service A

participant P1 as Proxy A

participant P2 as Proxy B

participant B as Service B

participant CP as Control Plane

CP->>P1: 정책 배포

CP->>P2: 정책 배포

A->>P1: 요청

P1->>P1: 정책 적용

P1->>P2: 요청 전달

P2->>P2: 정책 검증

P2->>B: 요청 전달

B->>P2: 응답

P2->>P1: 응답 전달

P1->>A: 응답

P1->>CP: 텔레메트리

P2->>CP: 텔레메트리

구조 및 아키텍처

전체 아키텍처

graph TB

subgraph "Control Plane"

CP[Control Plane]

subgraph "컴포넌트"

PI[Pilot]

CI[Citadel]

GA[Galley]

end

end

subgraph "Data Plane"

subgraph "Service A Pod"

A1[App A] <--> P1[Proxy]

end

subgraph "Service B Pod"

A2[App B] <--> P2[Proxy]

end

subgraph "Service C Pod"

A3[App C] <--> P3[Proxy]

end

end

CP --> P1

CP --> P2

CP --> P3

P1 <--> P2

P2 <--> P3

P1 <--> P3

구성 요소

필수 구성요소

1. 데이터 플레인 (Data Plane)

- 기능: 실제 트래픽 처리 및 프록시 기능 수행

- 역할:

- 모든 인바운드/아웃바운드 트래픽 중개

- 로드 밸런싱 및 라우팅 수행

- 보안 정책 집행

- 텔레메트리 데이터 수집

- 특징:

- 사이드카 패턴으로 배포

- 높은 성능과 낮은 지연시간 요구

- Envoy 프록시가 가장 널리 사용됨

2. 컨트롤 플레인 (Control Plane)

- 기능: 데이터 플레인 관리 및 정책 배포

- 역할:

- 프록시 구성 관리

- 서비스 디스커버리 정보 배포

- 보안 정책 및 인증서 관리

- 텔레메트리 수집 및 분석

- 특징:

- 중앙집중식 관리

- API 기반 구성

- 고가용성 및 확장성 필요

선택 구성요소

1. 관리 플레인 (Management Plane)

- 기능: 서비스 메시 라이프사이클 관리

- 역할:

- 여러 메시 간 연동 관리

- 정책 검증 및 거버넌스

- 통합 모니터링 및 대시보드

- 특징:

- 엔터프라이즈 기능 제공

- 멀티 클러스터 지원

- 비즈니스 프로세스 통합

2. 게이트웨이 (Gateway)

- 기능: 외부 트래픽 진입점 관리

- 역할:

- 인그레스/이그레스 트래픽 제어

- TLS 종료 및 인증서 관리

- 외부 연결 보안

- 특징:

- L7 프로토콜 지원

- 고급 라우팅 기능

- 보안 강화

제 3 부: 구현 및 활용

구현 기법

1. 사이드카 기반 구현

- 정의: 각 서비스 인스턴스와 함께 별도의 프록시 컨테이너 배포

- 구성:

- 애플리케이션 컨테이너와 사이드카 프록시가 같은 파드에 위치

- 모든 네트워크 트래픽이 프록시를 통해 라우팅

- 목적: 세밀한 제어와 격리 제공

- 실제 예시:

- Kubernetes 환경에서 Istio + Envoy 배포

- 각 마이크로서비스마다 독립적인 프록시 인스턴스

2. 노드 기반 구현 (Ambient Mesh)

- 정의: 호스트 단위로 프록시 배포하여 여러 서비스가 공유

- 구성:

- 노드당 하나의 프록시가 여러 애플리케이션 서비스 처리

- eBPF 와 같은 커널 레벨 기술 활용

- 목적: 리소스 효율성과 운영 단순화

- 실제 예시:

- Istio Ambient Mesh 모드

- Cilium Service Mesh 구현

3. 프록시 기반 구현

- 정의: 호스트별 단일 프록시로 여러 서비스 인스턴스 처리

- 구성:

- 호스트 레벨에서 중앙집중식 프록시 배포

- 서비스별 개별 프록시 불필요

- 목적: 리소스 사용량 최적화

- 실제 예시:

- 레거시 환경과의 하이브리드 배포

- VM 기반 워크로드 지원

장점과 단점

| 구분 | 항목 | 설명 |

|---|---|---|

| ✅ 장점 | 개발 생산성 향상 | 횡단 관심사를 인프라 계층에서 처리하여 비즈니스 로직에 집중 |

| 일관된 정책 집행 | 모든 서비스에 동일한 보안 및 통신 정책 적용 | |

| 향상된 보안 | mTLS, 인증, 권한 부여 자동화 | |

| 통합 관찰성 | 전체 시스템에 대한 통합 모니터링 및 추적 | |

| 플랫폼 중립성 | 다양한 언어와 플랫폼에서 동작 | |

| 트래픽 관리 | 카나리 배포, A/B 테스트, 트래픽 분할 지원 | |

| ⚠ 단점 | 성능 오버헤드 | 추가 네트워크 홉으로 인한 지연시간 증가 |

| 운영 복잡성 | 새로운 인프라 계층 관리 필요 | |

| 리소스 소비 | 사이드카 프록시로 인한 CPU/메모리 사용량 증가 | |

| 디버깅 어려움 | 추가 계층으로 인한 문제 진단 복잡성 | |

| 기술 습득 비용 | 팀의 새로운 기술 스택 학습 필요 | |

| 벤더 종속성 | 특정 서비스 메시 솔루션에 대한 의존성 |

단점 해결 방법

성능 오버헤드 해결:

- 사이드카 프록시 리소스 최적화

- 캐싱 전략 적용

- 네트워크 지역성 고려한 배치

운영 복잡성 해결:

- GitOps 기반 구성 관리

- 자동화된 배포 파이프라인

- 단계적 도입 전략

디버깅 어려움 해결:

- 분산 추적 시스템 구축

- 통합 로깅 플랫폼 활용

- 관찰성 도구 강화

도전 과제

1. 복잡성 관리

- 설명: 서비스 메시 자체가 복잡한 분산 시스템

- 해결책:

- 점진적 도입 전략

- 자동화 도구 활용

- 표준화된 운영 절차

2. 성능 최적화

- 설명: 프록시 계층 추가로 인한 성능 영향

- 해결책:

- 고성능 프록시 선택

- 캐싱 및 커넥션 풀링

- 리소스 튜닝

3. 보안 관리

- 설명: 메시 자체가 공격 대상이 될 수 있음

- 해결책:

- 정기적인 보안 감사

- 제로 트러스트 원칙 적용

- 인증서 자동 순환

4. 기술 숙련도

- 설명: 새로운 기술 스택에 대한 학습 곡선

- 해결책:

- 체계적인 교육 프로그램

- 실습 환경 제공

- 커뮤니티 참여

분류 기준에 따른 종류 및 유형

| 분류 기준 | 유형 | 특징 | 대표 솔루션 |

|---|---|---|---|

| 배포 방식 | 사이드카 기반 | 서비스별 개별 프록시, 세밀한 제어 | Istio, Linkerd |

| 노드 기반 | 호스트별 공유 프록시, 리소스 효율성 | Ambient Mesh | |

| 플랫폼 지원 | Kubernetes 전용 | K8s 네이티브, 최적화된 통합 | Linkerd 2.x |

| 멀티 플랫폼 | VM, 컨테이너, 클라우드 지원 | Istio, Consul | |

| 관리 방식 | 오픈소스 | 커뮤니티 주도, 무료 사용 | Istio, Linkerd |

| 상용/관리형 | 엔터프라이즈 지원, SLA 보장 | AWS App Mesh | |

| 아키텍처 복잡도 | 단순형 | 기본 기능, 쉬운 운영 | Linkerd |

| 고기능형 | 풍부한 기능, 높은 확장성 | Istio | |

| 프록시 유형 | Envoy 기반 | 고성능, 확장성 | Istio, AWS App Mesh |

| 자체 프록시 | 최적화된 성능, 단순함 | Linkerd-proxy |

제 4 부: 실무 적용 및 최적화

구현 예시 (JavaScript)

| |

실무 적용 예시

| 업계/회사 | 적용 사례 | 해결 문제 | 사용 기술 | 성과 |

|---|---|---|---|---|

| 스트리밍 | Netflix | 마이크로서비스 간 통신 복잡성 | Envoy + 자체 컨트롤 플레인 | 제로 다운타임 배포, 장애 격리 |

| 차량 공유 | Lyft | 서비스 장애 전파 방지 | Envoy 기반 서비스 메시 | 99.95% 가용성 달성 |

| 차량 공유 | Uber | 대규모 분산 시스템 관리 | Istio + Kubernetes | 배포 속도 50% 향상 |

| 전자상거래 | Amazon | 마이크로서비스 보안 강화 | AWS App Mesh | 보안 인시던트 80% 감소 |

| 금융 | JPMorgan | 규정 준수 및 감사 | Istio + 커스텀 정책 | 컴플라이언스 100% 달성 |

| 통신 | Verizon | 멀티 클라우드 연결성 | Consul Connect | 클라우드 간 지연시간 30% 감소 |

활용 사례: Netflix 의 서비스 메시 구현

Netflix 는 대규모 마이크로서비스 환경에서 발생하는 통신 복잡성을 해결하기 위해 서비스 메시를 도입했습니다.

시스템 구성

Netflix 의 서비스 메시는 다음과 같은 구성으로 이루어져 있습니다:

핵심 컴포넌트

- Envoy 프록시: 데이터 플레인의 핵심으로 모든 서비스 간 통신 중개

- Eureka: 서비스 디스커버리 시스템으로 동적 서비스 등록/해제

- Ribbon: 클라이언트 사이드 로드 밸런서

- Hystrix: 서킷 브레이커 패턴 구현체

- Zuul: API 게이트웨이 역할

시스템 아키텍처 다이어그램

graph TB

subgraph "Netflix Service Mesh Architecture"

subgraph "Control Plane"

E[Eureka Service Registry]

C[Configuration Service]

M[Monitoring & Metrics]

end

subgraph "Data Plane"

subgraph "Microservice A"

A1[Application A] <--> EP1[Envoy Proxy]

end

subgraph "Microservice B"

A2[Application B] <--> EP2[Envoy Proxy]

end

subgraph "Microservice C"

A3[Application C] <--> EP3[Envoy Proxy]

end

end

subgraph "Gateway Layer"

Z[Zuul Gateway]

end

EXT[External Clients] --> Z

Z --> EP1

Z --> EP2

Z --> EP3

E --> EP1

E --> EP2

E --> EP3

EP1 <--> EP2

EP2 <--> EP3

EP1 <--> EP3

EP1 --> M

EP2 --> M

EP3 --> M

end

활용 사례 Workflow

sequenceDiagram

participant User as 사용자

participant Zuul as Zuul Gateway

participant UserSvc as User Service

participant UserProxy as User Proxy

participant RecProxy as Recommendation Proxy

participant RecSvc as Recommendation Service

participant Eureka as Service Registry

participant Metrics as Metrics System

User->>Zuul: 영화 추천 요청

Zuul->>UserSvc: 사용자 인증 요청

UserSvc->>UserProxy: localhost 호출

UserProxy->>Eureka: Recommendation 서비스 위치 조회

Eureka->>UserProxy: 서비스 엔드포인트 반환

UserProxy->>RecProxy: mTLS 암호화 요청

RecProxy->>RecSvc: 요청 전달

RecSvc->>RecProxy: 추천 목록 응답

RecProxy->>UserProxy: 암호화된 응답

UserProxy->>Metrics: 호출 메트릭 전송

UserProxy->>UserSvc: 응답 전달

UserSvc->>Zuul: 최종 응답

Zuul->>User: 영화 추천 목록

Netflix 의 서비스 메시 역할

제로 구성 서비스 디스커버리:

- 서비스가 다른 서비스 위치를 자동으로 발견

- 동적 스케일링 시 자동 등록/해제

지능형 트래픽 라우팅:

- 카나리 배포를 통한 점진적 롤아웃

- A/B 테스트를 위한 트래픽 분할

장애 격리 및 복구:

- 서킷 브레이커로 장애 전파 방지

- 자동 재시도 및 폴백 메커니즘

보안 강화:

- 모든 서비스 간 통신에 mTLS 적용

- 서비스 단위 인증 및 권한 부여

관찰성 향상:

- 모든 요청에 대한 분산 추적

- 실시간 메트릭 수집 및 알림

실무에서 효과적으로 적용하기 위한 고려사항 및 주의할 점

| 구분 | 고려사항 | 설명 | 권장사항 |

|---|---|---|---|

| 도입 전략 | 점진적 마이그레이션 | 전체 시스템을 한번에 변경하지 않고 단계적 적용 | • 중요도가 낮은 서비스부터 시작 • 파일럿 프로젝트로 검증 • 롤백 계획 수립 |

| 팀 역량 | 기술 숙련도 확보 | 서비스 메시 운영을 위한 전문 지식 필요 | • 체계적 교육 프로그램 운영 • 실습 환경 제공 • 외부 전문가 컨설팅 활용 |

| 성능 관리 | 리소스 오버헤드 최소화 | 프록시 추가로 인한 성능 영향 관리 | • 프록시 리소스 최적화 • 네트워크 지역성 고려 • 캐싱 전략 적용 |

| 보안 | 메시 자체 보안 강화 | 서비스 메시가 공격 대상이 될 수 있음 | • 컨트롤 플레인 보안 강화 • 정기적 보안 감사 • 인증서 자동 순환 |

| 관찰성 | 통합 모니터링 구축 | 전체 시스템에 대한 가시성 확보 | • 분산 추적 시스템 구축 • 중앙집중식 로깅 • 실시간 대시보드 구성 |

| 운영 | 표준화된 운영 절차 | 일관된 운영 방식 확립 | • GitOps 기반 구성 관리 • 자동화된 배포 파이프라인 • 장애 대응 절차 문서화 |

최적화하기 위한 고려사항 및 주의할 점

| 구분 | 최적화 요소 | 설명 | 권장사항 |

|---|---|---|---|

| 성능 최적화 | 프록시 튜닝 | 사이드카 프록시 성능 최적화 | • 커넥션 풀 크기 조정 • 버퍼 크기 최적화 • Keep-alive 설정 |

| 리소스 관리 | 스케일링 전략 | 효율적인 리소스 사용 | • HPA/VPA 적용 • 리소스 요청/제한 설정 • 노드 어피니티 활용 |

| 네트워크 최적화 | 트래픽 최적화 | 네트워크 지연시간 최소화 | • 지역별 서비스 배치 • CDN 활용 • 프로토콜 최적화 |

| 보안 최적화 | 제로 트러스트 구현 | 강화된 보안 정책 적용 | • mTLS 자동화 • 최소 권한 원칙 • 정책 기반 액세스 제어 |

| 관찰성 최적화 | 데이터 효율성 | 메트릭/로그 데이터 최적화 | • 샘플링 전략 적용 • 중요 메트릭 우선순위 • 데이터 보존 정책 |

| 운영 최적화 | 자동화 강화 | 수동 작업 최소화 | • Infrastructure as Code • 자동 롤백 메커니즘 • 셀프 힐링 기능 |

기타 사항: 서비스 메시 관련 문제 및 해결 방안

1. 프록시 오버헤드 문제

원인: 사이드카 프록시 추가로 인한 CPU/메모리 사용량 증가 영향: 애플리케이션 성능 저하, 비용 증가 탐지 및 진단:

- 리소스 사용량 모니터링

- 응답 시간 메트릭 분석

- 처리량 변화 추적

예방 방법:

- 적절한 리소스 할당

- 프록시 설정 최적화

- 캐싱 전략 적용

해결 방법 및 기법:

2. 구성 복잡성 문제

원인: 서비스 메시 설정의 복잡성과 상호 의존성 영향: 설정 오류, 운영 복잡성 증가 탐지 및 진단:

- 구성 검증 도구 사용

- 설정 변경 이력 추적

- 의존성 분석

예방 방법:

- GitOps 기반 구성 관리

- 자동화된 검증 프로세스

- 단계적 배포

해결 방법:

3. 네트워크 분할 문제

원인: 컨트롤 플레인과 데이터 플레인 간 네트워크 연결 장애 영향: 서비스 간 통신 중단, 정책 적용 실패 탐지 및 진단:

- 네트워크 연결성 모니터링

- 컨트롤 플레인 상태 확인

- 프록시 동기화 상태 점검

예방 방법:

- 다중 AZ 배포

- 네트워크 중복화

- 정기적 헬스 체크

해결 방법:

- 수동 페일오버 메커니즘

- 로컬 캐시 활용

- 우아한 성능 저하 모드

4. 인증서 만료 문제

원인: mTLS 인증서 자동 갱신 실패 영향: 서비스 간 통신 중단, 보안 위험 탐지 및 진단:

- 인증서 만료일 모니터링

- TLS 핸드셰이크 오류 추적

- 로그 분석

예방 방법:

- 자동 인증서 갱신 설정

- 만료 알림 시스템

- 짧은 TTL 설정

해결 방법:

| |

용어 정리

| 카테고리 | 용어 | 설명 |

|---|---|---|

| 아키텍처 | 사이드카 패턴 (Sidecar Pattern) | 주 애플리케이션과 함께 배포되어 보조 기능을 제공하는 컨테이너 패턴 |

| 아키텍처 | 엠비언트 메시 (Ambient Mesh) | 사이드카 없이 노드 레벨에서 서비스 메시 기능을 제공하는 배포 모델 |

| 보안 | 상호 TLS (mutual TLS, mTLS) | 클라이언트와 서버가 서로 인증서를 검증하는 양방향 인증 방식 |

| 보안 | 제로 트러스트 (Zero Trust) | 네트워크 내부를 포함한 모든 연결을 검증하는 보안 모델 |

| 보안 | RBAC (Role-Based Access Control) | 사용자의 역할에 따라 접근 권한을 제어하는 보안 방식 |

| 네트워킹 | 서킷 브레이커 (Circuit Breaker) | 장애 전파를 방지하기 위해 연결을 차단하는 패턴 |

| 네트워킹 | 카나리 배포 (Canary Deployment) | 새 버전을 일부 트래픽에만 적용하여 점진적으로 배포하는 방식 |

| 네트워킹 | 트래픽 쉐이핑 (Traffic Shaping) | 네트워크 트래픽의 흐름과 우선순위를 제어하는 기법 |

| 관찰성 | 분산 추적 (Distributed Tracing) | 마이크로서비스 간 요청 흐름을 추적하고 분석하는 기법 |

| 관찰성 | 텔레메트리 (Telemetry) | 시스템에서 자동으로 수집되는 메트릭, 로그, 추적 데이터 |

| 운영 | GitOps | Git 저장소를 통해 인프라와 애플리케이션을 선언적으로 관리하는 방법론 |

| 운영 | 이그레스 (Egress) | 내부 네트워크에서 외부로 나가는 트래픽 |

| 운영 | 인그레스 (Ingress) | 외부에서 내부 네트워크로 들어오는 트래픽 |

| 프로토콜 | gRPC | Google 에서 개발한 고성능 RPC 프레임워크 |

| 프로토콜 | HTTP/2 | HTTP 프로토콜의 두 번째 주요 버전으로 멀티플렉싱 지원 |

참고 및 출처

- Kong - Service Mesh 가이드

- Red Hat - 서비스 메시란 무엇인가

- Istio 공식 문서

- AWS 서비스 메시 설명

- Tigera - 서비스 메시 아키텍처

- Solo.io - 서비스 메시 개요

- Netflix 기술 블로그 - 제로 구성 서비스 메시

- InfoQ - Lyft의 Envoy 서비스 메시 사례

- Google Cloud - 서비스 메시 보안 모범 사례

- CNCF - 서비스 메시 비교 분석

마이크로서비스 아키텍처에서 서비스 간 통신을 관리하고 제어하기 위한 인프라 계층.

현대의 마이크로서비스 아키텍처에서는 수많은 서비스들이 서로 통신하면서 복잡한 네트워크를 형성한다.

이러한 환경에서 서비스 간 통신의 안정성, 보안, 관찰 가능성을 확보하는 것이 매우 중요한 과제가 되었고, 이러한 문제들을 해결하고 애플리케이션 코드 변경 없이 인프라 수준에서 통신을 제어하기 위해 서비스 메시가 등장하였다.

서비스 메시는 사이드카 프록시 (Sidecar Proxy) 를 사용하여 서비스 간 통신을 처리한다.

각 서비스 인스턴스 옆에 프록시가 배치되어, 마치 오토바이의 사이드카처럼 함께 동작한다.

서비스 메시 패턴은 Istio, Linkerd, Consul Connect 등의 구현체를 통해 실제로 적용할 수 있다.

구성 요소 및 기능

데이터 플레인 (Data Plane):

- 각 서비스에 사이드카 프록시로 배치

- 서비스 간 모든 네트워크 통신 처리

- 주요 기능:

- 로드 밸런싱

- 서킷 브레이킹

- 재시도 및 타임아웃

- 메트릭 수집

- TLS 암호화

- 접근 제어

컨트롤 플레인 (Control Plane):

- 데이터 플레인의 프록시 구성 및 관리

- 정책 설정 및 배포

- 서비스 디스커버리 및 인증 관리

구현 방식

서비스 메시는 주로 사이드카 프록시 패턴을 사용하여 구현된다.

각 서비스 인스턴스와 함께 프록시가 배포되어 모든 인바운드 및 아웃바운드 트래픽을 처리한다.

장점

- 애플리케이션 코드 복잡성 감소

- 보안 강화 (제로 트러스트 모델 적용)

- 트래픽 관리 용이성 (A/B 테스트, 블루/그린 배포 등)

- 관측성 향상으로 문제 해결 및 최적화 용이

- 서비스 간 통신의 표준화 및 일관성 유지

사용 사례

- 대규모 마이크로서비스 환경

- 멀티 클라우드 또는 하이브리드 클라우드 배포

- 레거시 시스템과 현대적인 애플리케이션의 통합

용어 정리

| 용어 | 설명 |

|---|---|

참고 및 출처

서비스 메시 (Service Mesh) 는 마이크로서비스 아키텍처에서 서비스 간 통신을 관리하는 전용 인프라 계층입니다. 개발자가 비즈니스 로직에 집중할 수 있도록 네트워크 통신, 보안, 관찰 가능성 등을 추상화합니다. 2025 년 현재 서비스 메시는 클라우드 네이티브 환경의 핵심 기술로 자리 잡았으며, AI 통합과 엣지 컴퓨팅 확대에 따른 진화가 예상됩니다.

핵심 개념

- 정의: 서비스 메시는 마이크로서비스 간 통신을 제어하는 인프라 계층으로, 사이드카 프록시를 통해 트래픽 관리, 보안, 모니터링을 자동화합니다 1.

- 목적: 서비스 간 통신 복잡성 해소, 개발자의 비즈니스 로직 집중 지원 [2][11].

- 필요성: MSA 확산에 따른 서비스 간 통신 장애 진단 어려움, 보안 강화 요구 증가 [3][14].

주요 기능 및 아키텍처

기능

- 트래픽 관리: 로드 밸런싱, 카나리아 배포 [12].

- 보안: mTLS 암호화, 인증/권한 부여 [4][14].

- 관측성: 분산 추적, 지표 수집 [3][17].

- 복원력: 서킷 브레이커, 재시도 정책 [15].

아키텍처

| 구성 요소 | 역할 |

|---|---|

| Control Plane | 트래픽 정책 관리, 프록시 구성 전달 (예: Istio Pilot)[3][12]. |

| Data Plane | 실제 트래픽 처리 (예: Envoy 프록시)[3][13]. |

장점과 단점

| 구분 | 항목 | 설명 |

|---|---|---|

| ✅ 장점 | 관측성 강화 | 모든 트래픽 메트릭 수집으로 문제 진단 용이 [3][12]. |

| 보안 자동화 | mTLS 기반 암호화로 보안 정책 일괄 적용 [4][14]. | |

| ⚠ 단점 | 리소스 오버헤드 | 사이드카 프록시로 인한 CPU/메모리 사용량 증가 [18][14]. |

| 복잡성 | Istio 등의 도구 러닝 커브가 높음 [18][15]. |

분류 및 실무 적용

유형 분류

| 유형 | 설명 | 예시 |

|---|---|---|

| 사이드카 프록시 | 서비스와 분리된 프록시 사용 | Istio, Linkerd[5][17]. |

| 라이브러리 기반 | 애플리케이션 코드에 통합 | Netflix OSS5. |

실무 적용 예시

| 시나리오 | 적용 방법 |

|---|---|

| 카나리아 배포 | 트래픽의 5% 를 새 버전에 라우팅 [12][17]. |

| 다중 클라우드 통합 | 서로 다른 클라우드 간 서비스 연결 관리 [15]. |

2025 년 최신 동향

| 주제 | 항목 | 설명 |

|---|---|---|

| AI 통합 | 예측 기반 트래픽 관리 | AI 를 활용한 자동 트래픽 최적화 9. |

| 엣지 컴퓨팅 | 지연 시간 감소 | 서비스 메시를 엣지 노드에 배치 [9][16]. |

| API 게이트웨이 통합 | 기능 병합 | 서비스 메시가 API 게이트웨이 역할 흡수 3. |

고려사항

| 분야 | 내용 |

|---|---|

| 리소스 관리 | 사이드카 프록시의 리소스 할당 최적화 필요 [18]. |

| 보안 정책 | mTLS 인증서 주기적 갱신 및 권한 관리 [4][14]. |

| 버전 호환성 | Control Plane 과 Data Plane 버전 일관성 유지 [17]. |

용어 정리

| 용어 | 설명 |

|---|---|

| 사이드카 | 서비스와 함께 배포되는 프록시 컨테이너 3. |

| mTLS | 상호 TLS 암호화로 서비스 간 신원 검증 4. |

요약

서비스 메시는 마이크로서비스 환경의 통신 복잡성을 해결하는 핵심 인프라입니다. 2025 년에는 AI 기반 트래픽 최적화와 엣지 컴퓨팅 통합이 주요 트렌드로 부상하며, 리소스 관리와 보안 정책이 실무 적용의 핵심 고려사항입니다. Istio, Linkerd 등의 오픈소스 도구가 시장을 주도하고 있습니다.

참고:

Citations:

1 https://glossary.cncf.io/ko/service-mesh/

2 https://www.samsungsds.com/kr/insights/service_mesh.html

3 https://kkongchii.tistory.com/entry/CLOUD-%EC%84%9C%EB%B9%84%EC%8A%A4-%EB%A9%94%EC%8B%9C-Service-Mesh

4 https://ksb-dev.tistory.com/383

5 https://velog.io/@yyeongjin/%EC%84%9C%EB%B9%84%EC%8A%A4-%EB%A9%94%EC%89%AC-%EC%A0%95%EB%A6%AC

6 https://api7.ai/ko/blog/what-is-service-mesh

7 https://f-lab.kr/insight/service-mesh-namespace-management-optimization-20241010

8 https://www.businessresearchinsights.com/ko/market-reports/service-mesh-market-100139

9 https://ptbaepro.tistory.com/entry/2025%EB%85%84-IT-%ED%8A%B8%EB%A0%8C%EB%93%9C-%EC%A0%84%EB%A7%9D-AI-%EB%A9%94%ED%83%80%EB%B2%84%EC%8A%A4-%EC%9B%B930-%EC%96%B4%EB%96%A4-%EA%B8%B0%EC%97%85%EB%93%A4%EC%9D%B4-%EC%95%9E%EC%84%9C%EA%B0%80%EA%B3%A0-%EC%9E%88%EC%9D%84%EA%B9%8C

10 https://www.comworld.co.kr/news/articleView.html?idxno=51426

[11] https://post.naver.com/viewer/postView.naver?volumeNo=35069716&memberNo=36733075

[12] https://learn.microsoft.com/ko-kr/azure/aks/servicemesh-about

[13] https://velog.io/@gun_123/Service-Mesh-%EC%84%9C%EB%B9%84%EC%8A%A4-%EB%A9%94%EC%8B%9C-%EB%A7%88%EC%9D%B4%ED%81%AC%EB%A1%9C%EC%84%9C%EB%B9%84%EC%8A%A4-%EC%95%84%ED%82%A4%ED%85%8D%EC%B2%98%EC%9D%98-%ED%95%B5%EC%8B%AC-%EA%B5%AC%EC%84%B1-%EC%9A%94%EC%86%8C

[14] https://www.redhat.com/ko/topics/microservices/what-is-a-service-mesh

[15] https://aws.amazon.com/ko/what-is/service-mesh/

[16] https://www.researchnester.com/kr/reports/wireless-mesh-network-market/5024

[17] https://docs.redhat.com/ko/documentation/openshift_container_platform/4.9/html-single/service_mesh/index

[18] https://s-core.co.kr/insight/view/msa%EC%99%80-%EB%B6%84%EC%82%B0-%EC%95%84%ED%82%A4%ED%85%8D%EC%B2%98-%EC%88%98%EC%9A%A9%EC%9D%84-%EC%9C%84%ED%95%9C-%EB%B0%A9%EB%B2%95-%EC%84%9C%EB%B9%84%EC%8A%A4-%EB%A9%94%EC%89%AC%EC%99%80/

[19] https://www.giikorea.co.kr/report/moi1640522-wireless-mesh-networking-market-share-analysis.html

[20] https://product.kyobobook.co.kr/detail/S000061352304

[21] https://velog.io/@youngerjesus/Service-Mesh-Istio

[22] https://itpe.jackerlab.com/entry/%EC%84%9C%EB%B9%84%EC%8A%A4-%EB%A9%94%EC%8B%9CService-Mesh

[23] https://www.globalgrowthinsights.com/ko/market-reports/service-mesh-tools-software-market-101954

[24] https://ydy1201.tistory.com/90

[25] https://www.businessresearchinsights.com/ko/market-reports/service-mesh-tools-software-market-102436

[26] https://api7.ai/ko/blog/what-is-service-mesh

[27] https://velog.io/@rjsgy33/3.-MSA-%EC%99%80-Service-Mesh

[28] https://aigishoo.tistory.com/17

[29] https://with-cloud.tistory.com/39

[30] https://junuuu.tistory.com/206

[31] https://binux.tistory.com/179

[32] https://aws.amazon.com/ko/what-is/service-mesh/

[33] https://velog.io/@willie/%EC%84%9C%EB%B9%84%EC%8A%A4-%EB%A9%94%EC%8B%9CService-Mesh%EB%9E%80

[34] https://maily.so/newslettertodevops/posts/xyow6791r28

[35] https://s-core.co.kr/insight/view/msa%EC%99%80-%EB%B6%84%EC%82%B0-%EC%95%84%ED%82%A4%ED%85%8D%EC%B2%98-%EC%88%98%EC%9A%A9%EC%9D%84-%EC%9C%84%ED%95%9C-%EB%B0%A9%EB%B2%95-%EC%84%9C%EB%B9%84%EC%8A%A4-%EB%A9%94%EC%89%AC%EC%99%80/

[36] https://velog.io/@tedigom/MSA-%EC%A0%9C%EB%8C%80%EB%A1%9C-%EC%9D%B4%ED%95%B4%ED%95%98%EA%B8%B0-4Service-Mesh-f8k317qn1b

[37] https://ksb-dev.tistory.com/383

[38] https://well-made-codestory.tistory.com/28

[39] https://www.samsungsds.com/kr/insights/service_mesh_istio.html

[40] https://digitalbourgeois.tistory.com/264

[41] https://kmaster.tistory.com/136

[42] https://velog.io/@vernolog/Service-Mesh%EC%99%80-Istio