서비스 메시 (Service Mesh)

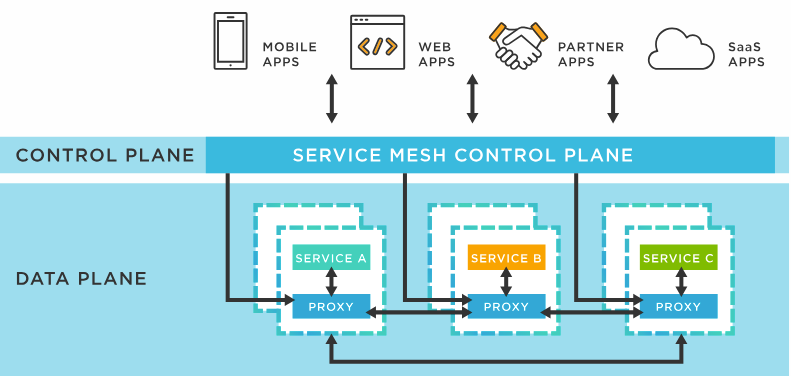

서비스 메시 (Service Mesh) 는 마이크로서비스 간 통신을 자동화되고 일관되게 처리하는 인프라레이어이다. 각 서비스에 사이드카 프록시를 연결해 트래픽 라우팅, 로드 밸런싱, mTLS 기반 보안, 리트라이·서킷 브레이커, 분산추적·메트릭 수집 등의 기능을 비즈니스 코드에서 분리해 제공한다. 제어 평면 (Control Plane) 은 정책을 중앙에서 설정하며, 데이터 평면 (Data Plane) 은 사이드카를 통해 실제 플로우를 처리한다. Istio, Linkerd, Consul, Cilium 등이 대표 솔루션이다.

등장 배경 및 발전 과정

클라우드 네이티브 환경에서 마이크로서비스가 확산되면서, 서비스 간 통신 관리의 복잡성, 보안, 관찰성이 문제가 되었다.

초기에는 애플리케이션 코드에 통신 로직 (재시도, TLS, 라우팅 등) 을 직접 구현하거나, 라이브러리 (API Gateway 나 SDK) 로 해결했지만, 이는 언어·프레임워크 종속, 운영 복잡성 증가 등의 한계가 있었다.

마이크로서비스는 수백~수천 개의 독립 컴포넌트로 구성되고, 새로운 네트워크 요구사항이 지속적으로 등장함에 따라 이러한 문제를 해결하기 위한 인프라 기반의 네트워크 계층이 필요해졌다.

- 서비스 간 통신 복잡성 증가: 수십, 수백 개의 서비스가 네트워크를 통해 통신

- 운영 복잡성: 각 서비스별로 로깅, 모니터링, 보안 구현 필요

- 네트워크 신뢰성 문제: 분산 환경에서의 장애 전파 및 복구 어려움

- 보안 관리 어려움: 서비스별 개별 보안 구현의 일관성 부족

이러한 문제들로 2010 년대 후반 Netflix, Google, Lyft 등이 대규모 마이크로서비스 환경에서 겪은 통신 복잡성 문제를 해결하기 위해 개발되었다.

발전 단계:

- 1 세대 (2016-2017): Linkerd 1.x, Envoy Proxy 등장

- 2 세대 (2017-2019): Istio, Linkerd 2.x 출시, CNCF 프로젝트화

- 3 세대 (2019- 현재): 성능 최적화, 간소화, 멀티 클러스터 지원

목적 및 필요성

목적 (Purpose)

| 목적 항목 | 설명 |

|---|---|

| 서비스 간 통신 추상화 | 마이크로서비스 간 복잡한 통신 로직을 코드에서 제거하고 인프라 계층 (Sidecar 등) 으로 위임 |

| 횡단 관심사 중앙화 관리 | 인증/인가, 트래픽 제어, 로깅/모니터링 등 공통 기능을 중앙 집중형으로 관리 |

| 개발 생산성 향상 | 네트워크/보안 로직에서 개발자를 분리해 비즈니스 로직 개발에 집중할 수 있도록 함 |

| 보안 강화 (Zero Trust) | 모든 서비스 간 통신을 암호화하고, 인증/인가 정책을 코드 외부에서 강제 적용 |

| 관찰성 향상 (Observability) | 전체 서비스 흐름과 성능을 트레이싱/로깅/메트릭 수집을 통해 통합적으로 모니터링 |

| 운영 표준화 및 자동화 | 서비스 라우팅, 배포 전략, 복원 전략 등을 인프라 수준에서 일관되고 자동화된 방식으로 관리 |

필요성 (Need)

| 필요 항목 | 설명 |

|---|---|

| 마이크로서비스의 확산 | 서비스 수가 증가함에 따라 통신 관계가 복잡해지고, 관리 비용이 기하급수적으로 상승 |

| 보안 요구의 고도화 | 기업 내/외부 보안 요구사항 증가에 따른 제로 트러스트 네트워크 구현 필요 |

| 정책 일관성 확보 필요 | 모든 마이크로서비스에 **일관된 정책 (보안, 라우팅, 인증)**을 적용하기 위한 수단 필요 |

| 운영 복잡성의 증가 | 서비스 배포/업데이트/롤백이 잦은 환경에서 정책 관리, 트래픽 제어, 장애 복구의 자동화 필요 |

| 관찰 가능성 확보 | 서비스 간 의존성과 장애 지점을 빠르게 파악하기 위한 분산 트레이싱, 메트릭, 로그 수집 체계 필요 |

| 레질리언스 확보 (복원력) | 장애 복구, 자동 재시도, 회로 차단, 페일오버 등 운영 안정성을 위한 내결함성 제어 필요 |

| DevOps/플랫폼 팀의 요구 | 플랫폼팀이 통합 제어 권한을 갖고 정책과 통신 제어를 수행할 수 있도록 표준화된 인프라 도구 필요 |

핵심 개념

서비스 메시는 마이크로서비스 아키텍처에서 서비스 간 통신을 처리하는 전용 인프라 레이어이다. 애플리케이션 계층과 분리되어 네트워크 통신의 복잡성을 추상화한다.

기본 개념

| 구성 요소 | 정의 및 역할 |

|---|---|

| Service Mesh | 마이크로서비스 간 통신을 추상화하고 제어하는 인프라 계층. 보안, 정책, 관찰성 등을 통합 관리 |

| Sidecar Proxy | 각 서비스 인스턴스와 함께 배포되는 네트워크 프록시. 모든 트래픽을 가로채어 보안, 라우팅, 로깅 등을 처리 |

| Data Plane | 실제 트래픽을 전달하는 사이드카 프록시들의 집합. 로드 밸런싱, 재시도, 트래픽 분할 등 실행 책임을 가짐 |

| Control Plane | 정책 설정, 사이드카 구성 관리, 인증서 배포, 서비스 디스커버리 등 중앙 관리 기능 담당 |

| mTLS | 서비스 간 상호 인증을 수행하고 데이터를 암호화하는 방식. Zero-Trust 보안의 핵심 메커니즘 |

| Observability | 메트릭, 로그, 분산 트레이싱을 통해 전체 서비스 간 호출 관계와 상태를 가시화 |

| xDS API | Envoy 가 컨트롤 플레인으로부터 설정을 받아오는 동적 구성 프로토콜 집합 (CDS, EDS, LDS 등) |

실무 구현 연관성

| 항목 | 설명 |

|---|---|

| 프록시 주입 방식 | Kubernetes 의 mutating admission webhook 을 통해 사이드카 자동 주입 |

| 트래픽 제어 | Canary, A/B 테스트, Circuit Breaker, Retry, Timeout 등을 네트워크 계층에서 제어 |

| 보안 연동 | Citadel, cert-manager 등과 연계한 mTLS 인증서 자동 발급 및 갱신 |

| 관찰성 구성 | Prometheus (메트릭), Grafana (시각화), Jaeger/Kiali (트레이싱) 통합 |

| 정책 관리 | YAML 기반 VirtualService, DestinationRule 등으로 라우팅 및 QoS 정책 선언 가능 |

| GitOps 통합 | ArgoCD, Flux 등을 이용해 Service Mesh 설정 및 배포 자동화 실현 |

| 서비스 디스커버리 | Kubernetes 서비스 레지스트리 기반. Control Plane 이 Endpoint 변경을 프록시에 전파함 |

기술적으로 검토된 적합성

| 항목 | 분석 결과 |

|---|---|

| 사이드카 구조 | Istio, Linkerd, Kuma, Consul Connect 등 대부분의 구현체에서 사이드카 패턴이 기본 구조로 채택됨 |

| 데이터/컨트롤 플레인 분리 | CNCF 권고 구조이며 Envoy 기반 메시들은 모두 해당 아키텍처 구성 유지 |

| mTLS 및 인증 자동화 | 보안 요구사항 강화로 필수 적용 중. Istio 는 Citadel, 최신 Istio 는 Istiod 로 통합됨 |

| 관찰성 구성요소 통합 | SRE 및 DevOps 흐름에서 핵심 요소. Istio, Linkerd 는 Prometheus 및 Jaeger 기본 통합 제공 |

| xDS 동적 구성 | Envoy 기반 프록시에서 핵심 구성 원리이며, Proxyless Mesh 에도 일부 연계 사용됨 |

| 서비스 메시 → API 게이트웨이 비교 | API 게이트웨이는 외부 요청 처리 (L7 Entry), 메시지는 내부 트래픽 (East-West) 제어에 중점 |

주요 기능 및 역할

핵심 기능 (Key Functional Capabilities)

| 기능 카테고리 | 세부 기능 | 설명 |

|---|---|---|

| 트래픽 관리 (Traffic Management) | - 라우팅 (L7 기반) - 로드 밸런싱 - 트래픽 분할 - A/B 테스트 - 카나리/블루그린 배포 - Fault Injection | 네트워크 트래픽을 제어하여 장애 테스트, 배포 전략, QoS 향상을 가능케 함 |

| 서비스 디스커버리 (Service Discovery) | - 동적 서비스 탐색 - 클러스터 내 인스턴스 자동 등록/해제 | Kubernetes 와 통합하여 서비스 인스턴스를 자동 탐지하고 라우팅 |

| 보안 (Security) | - 자동 mTLS 적용 - 인증/인가 (RBAC, JWT 등) - 인증서 관리 | 제로 트러스트 보안 모델 구현. 애플리케이션 코드 변경 없이 통신 보안 강화 |

| 관찰성 (Observability) | - 메트릭 수집 (Prometheus) - 로그 분석 (Fluentd 등) - 분산 추적 (Jaeger, Zipkin) - 서비스 토폴로지 시각화 | 서비스 흐름 및 성능 병목 파악. 운영 환경의 실시간 상태 가시화 |

| 레질리언스 (Resilience) | - 재시도 - 타임아웃 - Circuit Breaker - 장애 격리 - 페일오버 | 장애 전파 방지 및 고가용성 유지. 운영 환경에서 자체 복원력 확보 |

| 정책 관리 (Policy Enforcement) | - 트래픽 정책 (VirtualService) - 보안 정책 (AuthorizationPolicy) - 속도 제한, ACL | 선언적 YAML 정책으로 중앙 통제 및 표준화된 관리 가능 |

핵심 역할 (Operational Roles)

| 역할 | 설명 |

|---|---|

| 통신 제어자 | 애플리케이션 코드 외부에서 모든 트래픽 흐름을 제어하며, 트래픽 분산, 라우팅, 복구 등을 수행 |

| 보안 게이트웨이 | mTLS 를 통한 트래픽 암호화와 인증, 인가를 수행하여 네트워크 수준의 보안을 담당 |

| 관찰성 허브 | 메트릭, 로그, 트레이싱을 통합 수집하고 시각화하여 시스템의 상태 및 이상 탐지 지원 |

| 정책 집행자 | 네트워크 정책 및 보안 규칙을 중앙에서 정의하고, 모든 서비스에 일관되게 적용 |

| 개발 부담 해소자 | 횡단 관심사 (보안, 로깅, 장애 복구 등) 를 코드에서 제거하여 개발자가 비즈니스 로직에 집중 가능하게 함 |

| 배포 보조자 | Canary, Blue/Green, Traffic Shadowing 등 유연한 배포 전략을 실행하는 인프라 계층 도구 역할 |

요약 정리

| 구분 | 요약 내용 |

|---|---|

| 기능 | 서비스 메시의 기능은 크게 트래픽 제어, 보안, 관찰성, 정책 관리, 장애 복원, 서비스 탐색으로 구성되며, 모든 기능은 인프라 계층에서 실행됨 |

| 역할 | 개발자 대신 네트워크 및 운영 기능을 통합 제어하는 인프라 구성 요소로서 작동하며, 마이크로서비스 운영에 필수적인 제어력과 일관성을 제공함 |

특징

| 분류 | 특징 항목 | 설명 |

|---|---|---|

| 1. 구조적 특징 | 사이드카 프록시 기반 아키텍처 | 모든 네트워크 트래픽을 가로채는 프록시가 서비스와 함께 배포되어 기능을 처리 (예: Envoy, Linkerd-proxy) |

| 제어 평면/데이터 평면 분리 | 정책 제어 (Control Plane) 와 트래픽 처리 (Data Plane) 가 분리되어 운영과 실행이 독립됨 | |

| 분산형 구성 | 데이터 평면은 완전히 분산되어 있고, 제어 평면은 중앙화 또는 이중화 가능 | |

| 2. 운용 특성 | 투명성 (Transparency) | 애플리케이션 코드를 변경하지 않고도 보안, 모니터링, 트래픽 정책이 적용됨 |

| 언어/플랫폼 독립성 | 다양한 언어 및 런타임의 서비스와 통신 가능 (REST, gRPC, HTTP/2 등 지원) | |

| 플랫폼 중립성 | Kubernetes 뿐 아니라 VM, 클라우드 등 다양한 인프라에서도 적용 가능 | |

| 3. 자동화 및 정책 | 정책 중심 설계 | YAML 기반의 선언적 구성으로 정책을 정의 및 배포 가능 (VirtualService, AuthorizationPolicy 등) |

| 자동화 연계 | GitOps, CI/CD, mTLS 인증서 갱신 등 다양한 운영 요소와 통합 가능 | |

| 4. 확장성과 안정성 | 선형 확장성 | 서비스 수 증가에 따라 사이드카가 자동 배포되어 성능과 기능이 함께 확장됨 |

| 세밀한 제어 능력 | 요청 단위 라우팅, 리트라이, Fault Injection, Rate Limit 등의 미세 정책 적용 가능 |

기술적 검토 요약

| 검토 항목 | 분석 결과 |

|---|---|

| 투명성 | 사이드카 구조의 핵심 장점. 코드 수정 없이 트래픽 제어 가능 (Istio 공식 문서 기준 확정) |

| 프로그래밍 언어 독립성 | HTTP/gRPC 기반이므로 언어와 프레임워크에 독립적 (RESTful/GraphQL/Protobuf 등) |

| 구성 요소 분리 원칙 | Control Plane ↔ Data Plane 분리는 Envoy 기반 메시 구현체의 구조적 표준 |

| 자동화 연동성 | GitOps 기반 운영 (ArgoCD, Flux) 또는 Helm + Terraform 으로 쉽게 통합 가능 |

| 확장성 | 서비스 증가 시 사이드카 배포만으로 기능 복제 가능 → 클러스터 확장성에 일관성 유지 |

| 제어 정밀도 | Envoy Filter 및 Policy 수준에서 L7 기반 요청 단위 트래픽 제어 가능 |

통합 요약

| 분류 | 설명 |

|---|---|

| 구조 | 사이드카 기반, 제어/데이터 평면 분리, 분산형 아키텍처 |

| 투명성 | 코드 수정 없이 트래픽 제어, 보안, 모니터링 가능 |

| 독립성 | 언어, 플랫폼, 배포 환경과 무관하게 통합 운영 가능 |

| 확장성 | 서비스 수 증가에 따라 자동 사이드카 확장 가능 |

| 자동화 및 선언적 구성 | YAML 기반 정책 선언 + GitOps 연동 |

| 정밀 제어 | 요청 단위의 트래픽 제어, 인증, 로깅, 재시도 등 가능 |

핵심 원칙

| 범주 | 원칙 | 설명 |

|---|---|---|

| 1. 아키텍처 설계 원칙 | 관심사 분리 (Separation of Concerns) | 네트워크 트래픽, 보안, 로깅 등의 기능을 애플리케이션 코드로부터 분리하여 인프라 계층에서 처리 |

| 사이드카 패턴 적용 | 프록시를 각 서비스 옆에 배치하여 트래픽을 제어하고 기능을 주입 (대표적으로 Envoy 기반) | |

| 제어 평면과 데이터 평면 분리 | 설정/정책은 Control Plane, 실행은 Data Plane 이 담당하여 책임을 분리 | |

| 2. 정책 기반 운영 원칙 | 선언적 구성 및 정책 중심 운영 | YAML 등 선언형 방식으로 트래픽/보안 정책 정의. 코드 수정 없이 변경 가능 |

| 중앙집중 정책 통제와 자동화 | 모든 서비스에 동일한 보안 및 라우팅 정책을 자동·일관되게 적용 | |

| 3. 보안 설계 원칙 | Zero Trust 보안 모델 | 기본 가정은 " 모든 통신은 불신 " → mTLS 를 기본 적용하여 상호 인증 + 암호화 |

| 4. 운영 및 확장성 원칙 | 확장성과 이식성 | 다양한 언어·플랫폼·인프라 환경에서 동일한 기능 구현 가능 (Kubernetes 외 VM 포함) |

| 점진적 도입 가능성 | 기존 시스템에 Sidecar 프록시만 주입하면 단계적 도입 가능 (Non-invasive Integration) | |

| 5. 관찰성 및 가시성 원칙 | 관찰성 기본 내장 (Observability-by-default) | 메트릭, 로그, 트레이싱을 자동 수집하여 운영 가시성을 확보 |

| 트래픽 흐름 감시 및 시각화 | 서비스 간 트래픽 흐름 및 장애 탐지 가능 (서비스 토폴로지 및 성능 분석 포함) |

기술적 검토 및 타당성 분석

| 검토 항목 | 분석 결과 |

|---|---|

| 관심사 분리 | 핵심 원칙이며, Envoy 기반 메시 구현체에서 구조적으로 보장됨 |

| 정책 - 데이터 분리 구조 | Control Plane (정책) ↔ Data Plane (트래픽) 의 분리는 CNCF 표준 구조 |

| 보안 모델 (mTLS 중심) | Istio, Linkerd, Consul 등 모두 기본적으로 mTLS 암호화 및 인증 제공 |

| 선언형 정책 관리 | Kubernetes CRD 와 YAML 구성을 통해 일관성 있게 적용 가능 |

| 관찰성 및 자동화 내장 여부 | Prometheus, Jaeger, Grafana 등의 통합이 공식적으로 제공되며, GitOps 연계 가능 |

| 점진적 도입/확장 | Istio 등은 namespace 단위 적용, VM + K8s hybrid 구성도 지원 가능 |

요약 정리

| 범주 | 핵심 원칙 요약 |

|---|---|

| 설계 철학 | 코드에서 네트워크·보안·모니터링 로직 분리, 사이드카 기반 구조 채택 |

| 운영 정책 | 선언적 구성 (YAML) 과 중앙 집중 정책 관리로 자동화 및 일관성 확보 |

| 보안 전략 | mTLS 기반 Zero Trust 모델 구현, 인증서 자동 관리 포함 |

| 확장성 및 도입 유연성 | 다양한 플랫폼 지원, 점진적 적용 가능성 보장 |

| 가시성 및 안정성 | 관찰성 도구 기본 내장, 트래픽 흐름 추적 및 장애 감지 지원 |

주요 원리

- 프록시 기반 통신: 각 서비스에 사이드카 프록시 배치, 모든 트래픽을 프록시가 처리.

- 정책 기반 관리: 컨트롤 플레인에서 정책을 정의, 데이터 플레인에 적용.

- 분산 추적 및 모니터링: 모든 트래픽을 관찰 가능하게 함.

flowchart TB

subgraph "Service A Pod"

SA[Service A]

PA[Sidecar Proxy A]

end

subgraph "Service B Pod"

SB[Service B]

PB[Sidecar Proxy B]

end

subgraph "Control Plane"

CP["Control Plane (Istiod)"]

CFG["Config API (CRDs)"]

end

subgraph "Observability Systems"

MET[Prometheus / Grafana]

TRACE[Jaeger / Zipkin]

end

SA --> PA

PA --> PB

PB --> SB

CFG --> CP

CP --> PA

CP --> PB

PA --> MET

PB --> MET

PA --> TRACE

PB --> TRACE

- ControlPlane 은 정책/설정을 프록시에 전달

- App1 에서 App2 로의 모든 네트워크 요청은 각각의 사이드카를 통해 제어/관찰/정책 적용됨

작동 흐름

sequenceDiagram

participant Client as 클라이언트

participant ProxyA as Service A Proxy

participant ServiceA as Service A

participant ProxyB as Service B Proxy

participant ServiceB as Service B

participant Control as 컨트롤 플레인

Control->>ProxyA: 정책 및 라우팅 규칙 배포

Control->>ProxyB: 정책 및 라우팅 규칙 배포

Client->>ProxyA: 요청

ProxyA->>ProxyA: 인증, 권한 확인

ProxyA->>ServiceA: 요청 전달

ServiceA->>ProxyA: 응답

ProxyA->>ProxyB: Service B 호출

ProxyB->>ProxyB: 보안 정책 적용

ProxyB->>ServiceB: 요청 전달

ServiceB->>ProxyB: 응답

ProxyB->>ProxyA: 응답

ProxyA->>Client: 최종 응답

ProxyA->>Control: 텔레메트리 데이터

ProxyB->>Control: 텔레메트리 데이터

- 각 서비스에 사이드카 (프록시) 가 삽입되고, 모든 통신은 사이드카를 통해 흐름 제어됨

- 제어 플레인 (Control Plane) 이 정책 및 설정을 사이드카에 전달

구조 및 아키텍처

flowchart TB

subgraph "User"

U[External Client]

end

subgraph "Kubernetes Cluster"

subgraph "Ingress"

GW["Ingress Gateway<br/>(Deployment + Service)"]

end

subgraph "Application Pods"

APP1["Order Service Pod<br/>(App + Envoy Sidecar)"]

APP2["Payment Service Pod<br/>(App + Envoy Sidecar)"]

end

subgraph "Control Plane (istio-system)"

CP1["Pilot (xDS)"]

CP2["Citadel (mTLS)"]

CP3["Telemetry (Prometheus Hook)"]

end

subgraph "Management Plane (Optional)"

MGMT["Gloo / Tetrate / Mesh Hub"]

end

end

U --> GW

GW --> APP1

GW --> APP2

CP1 -.-> APP1

CP1 -.-> APP2

CP2 -.-> APP1

CP2 -.-> APP2

CP3 -.-> APP1

CP3 -.-> APP2

MGMT -.-> CP1

MGMT -.-> CP2

MGMT -.-> CP3

APP1,APP2: 각각의 서비스에 사이드카 프록시가 주입된 PodIngress Gateway: 외부 요청 진입점 (Istio 에서 일반적으로istio-ingressgateway)Control Plane: Istio 의 핵심 컴포넌트들 (Pilot,Citadel,Telemetry,Injector등)Management Plane: Istio 에는 기본적으로 없지만, Tetrate, Gloo Mesh 등 외부 솔루션에서 제공됨

구성 요소

| 구성요소 | 분류 | 기능 | 주요 역할 | 특징 |

|---|---|---|---|---|

| 데이터 플레인 (Data Plane) | 필수 | 실제 트래픽 처리 및 프록시 기능 수행 | - 모든 인바운드/아웃바운드 트래픽 중개 - 로드 밸런싱 및 라우팅 - 보안 정책 집행 - 텔레메트리 데이터 수집 | - 사이드카 패턴으로 배포 - 낮은 지연시간과 높은 성능 요구 - Envoy 가 대표 구현체 |

| 컨트롤 플레인 (Control Plane) | 필수 | 프록시 제어 및 정책 관리 | - 프록시 설정 전달 - 서비스 디스커버리 정보 배포 - 인증서 및 정책 배포 - 텔레메트리 수집/분석 | - 중앙 집중식 관리 - API 기반 구성 - 고가용성/확장성 요구 |

| 관리 플레인 (Management Plane) | 선택 | 서비스 메시 라이프사이클 통합 관리 | - 여러 메시/클러스터 통합 - 정책 검증 및 거버넌스 - 통합 대시보드/모니터링 제공 | - 엔터프라이즈 기능 중심 - 멀티 클러스터/테넌시 지원 - 비즈니스 도구 연계 |

| 게이트웨이 (Gateway) | 선택 | 외부 트래픽 진입점 관리 | - 인그레스/이그레스 트래픽 제어 - TLS 종료 및 인증서 관리 - 외부 보안 연결 처리 | - L7 라우팅 지원 - 고급 라우팅 기능 - 보안 강화 기능 포함 |

- 데이터 플레인과 컨트롤 플레인은 모든 Service Mesh 에서 반드시 필요.

- 관리 플레인은 멀티 클러스터 운영이나 엔터프라이즈급 통합 관리에 필요하며, 운영 도구 (예: Tetrate, Gloo Mesh) 가 이를 담당.

- 게이트웨이는 외부 연동 시점에서 Ingress/Egress 트래픽을 통제하며, 인증서 관리와 고급 라우팅 기능까지 포함됨.

Service Mesh 구성요소 ↔ Kubernetes 리소스 매핑표

| 구성요소 | Kubernetes 리소스/구성 | 설명 |

|---|---|---|

| Data Plane (데이터 플레인) | Pod 내 Sidecar (Envoy)Deployment 또는 DaemonSet | 각 서비스마다 Envoy 프록시가 사이드카로 자동 주입되어 트래픽을 중계함 |

| Control Plane (컨트롤 플레인) | DeploymentServiceConfigMapSecretCRD: VirtualService, DestinationRule, PeerAuthentication 등 | 정책과 구성 정보를 관리하고 Data Plane 에 전달 |

| Management Plane (관리 플레인) | (해당 구현체 전용 리소스) 예: Gloo, Tetrate, ServiceMeshHub 등의 Deployment, Custom CRDHelm 또는 GitOps 로 구성 | 여러 클러스터 및 메시를 통합 관리하는 도구. 직접적인 K8s 기본 리소스보다 Operator 또는 Extension 형태로 배포됨 |

| Gateway (게이트웨이) | Gateway (Istio CRD)VirtualServiceIngressGateway (Deployment + Service) | 외부 트래픽 진입점을 제어하고 TLS 종료, 인증, 라우팅 등을 수행함 |

구현 기법

| 분류 | 구현 기법 | 정의/구성 | 목적 | 대표 예시 |

|---|---|---|---|---|

| A. 사이드카 기반 | Sidecar Proxy | 각 서비스 인스턴스에 프록시 컨테이너를 주입하여 통신 가로채기 | 트래픽 제어, 보안, 관찰성, 코드 분리 | Istio + Envoy, Linkerd |

| 자동 사이드카 주입 | 네임스페이스 라벨과 Mutating Webhook 기반 자동 주입 | 개발자 개입 없이 자동화된 구성 적용 | istio-injection=enabled, Istio Pilot | |

| 트래픽 인터셉션 (iptables) | Init Container 또는 CNI 를 통해 모든 패킷을 프록시로 전달 | 코드 수정 없는 투명한 트래픽 제어 | Istio-proxy init container | |

| mTLS 통신 암호화 | 프록시 간 TLS 암호화, 인증서 자동 갱신 | 제로 트러스트 보안 모델 구현 | Istio, Consul Connect | |

| 정책 기반 라우팅 | 컨트롤 플레인에서 선언형 정책 (YAML 등) 을 통해 데이터 플레인에 전달 | 일관된 통신 제어, A/B 테스트, 재시도 정책 적용 | VirtualService, DestinationRule | |

| B. 노드 기반 (사이드카리스) | Shared Proxy per Node | 노드 단위로 프록시 데몬셋 구성, 각 Pod 간 트래픽을 프록시가 처리 | 리소스 사용 최적화, 오버헤드 감소 | Istio Ambient Mesh, Cilium Service Mesh |

| eBPF 기반 메시 처리 | 커널 레벨에서 트래픽 제어 수행 (프록시 미포함 또는 최소화) | 지연 시간 최소화, CPU 오버헤드 절감 | Cilium, Ambient Mesh (security-only mode) | |

| C. 프록시리스 (Proxy-less) | gRPC xDS | Envoy 없이 애플리케이션이 xDS API 와 직접 통신 | 프록시 제거로 성능 최적화, 프레임워크 내 통합 | gRPC 라이브러리 기반 메시 통신 |

| Native SDK/Agent 기반 통합 | 앱 내부에 프록시 기능 내장 또는 라이브러리 형태로 통합 | 마이크로서비스 라이브러리 수준의 보안·트래픽 관리 기능 | Istio Wasm SDK, AppMesh SDK 등 | |

| D. 확장/표준화 인터페이스 | SMI (Service Mesh Interface) | CRD 기반 서비스 메시 표준 인터페이스 제공 | 벤더 중립적 메시 운영, 교체 가능성 확보 | SMI, Meshery 등 |

| Telemetry 통합 | Jaeger, Zipkin 등과 연동하여 Trace, Metrics 수집 | 서비스 관찰성 확보, 분산 트랜잭션 디버깅 지원 | Jaeger, OpenTelemetry |

요약 정리

| 구분 | 핵심 특징 요약 |

|---|---|

| 사이드카 기반 | 가장 일반적인 방식. 서비스당 프록시 배포. 세밀한 정책 제어와 관찰성 제공. 개발자 관여 없이 자동 주입 가능. |

| 노드 기반 | 노드 단위 공유 프록시 방식으로 리소스 절약에 유리. Istio Ambient Mesh, eBPF 기반 기술이 대표적. |

| 프록시리스 | 프록시를 제거하고 직접 API 제어. 성능에 민감한 환경에서 활용. gRPC 기반 통합 사례 증가 중. |

| 표준화 인터페이스 | 서비스 메시 구현 간 호환성을 위한 표준 API. 메시 벤더 간 교체 용이성 보장. |

사이드카 기반 구성 (Sidecar-Based Service Mesh)

flowchart TD

Client[Client]

subgraph Pod A

AppA[App A]

ProxyA[Envoy Proxy A]

end

subgraph Pod B

AppB[App B]

ProxyB[Envoy Proxy B]

end

Client -->|Request| ProxyA --> AppA

AppA --> ProxyA -->|Call Service B| ProxyB --> AppB

AppB --> ProxyB -->|Response| ProxyA --> AppA --> ProxyA -->|Response| Client

YAML 예시 (Istio 기반)

| |

노드 기반 구성 (Ambient Mesh / 사이드카리스)

flowchart TD

Client[Client]

subgraph Node

ProxyN["Ztunnel (Node Proxy)"]

AppA[App A Pod]

AppB[App B Pod]

end

Client -->|Request| ProxyN --> AppA

AppA --> ProxyN --> AppB

AppB --> ProxyN --> AppA --> ProxyN -->|Response| Client

YAML 예시 (Istio Ambient Mesh 기반 예시)

- Ambient Mesh 는 Istio 1.18+ 에서 사용 가능하며,

ztunnel데몬셋으로 노드 프록시 구성

| |

- ztunnel 및 waypoint-proxy 는 Istio 설치 시 자동 구성됨

프록시리스 구성 (Proxy-less / gRPC xDS 방식)

flowchart TD

Client[Client gRPC Stub]

AppA["App A (gRPC xDS Client)"]

AppB["App B (gRPC Server)"]

Client -->|gRPC Call| AppA -->|Direct gRPC| AppB -->|Response| AppA --> Client

YAML 예시 (프록시 없는 앱 직접 xDS 처리)

- gRPC xDS 라이브러리를 내장한 앱으로 구성하며, 별도의 Envoy 가 없음

| |

- 앱 내부에서

grpc-xds라이브러리를 통해 Control Plane 과 xDS 직접 통신

확장/표준화 인터페이스 구성 (SMI 기반)

flowchart TD

Client[Client]

AppA[Service A]

AppB[Service B]

TrafficPolicy[TrafficTarget + HTTPRoute]

Client --> AppA -->|→ SMI 정책 참조| TrafficPolicy -.-> AppB

AppB --> AppA --> Client

YAML 예시 (SMI 표준 적용)

| |

- Consul, Linkerd 등에서 사용 가능하며, SMI 는 CRD 로 구성되어 확장성이 뛰어남.

장점

| 카테고리 | 항목 | 설명 |

|---|---|---|

| 보안 | 자동화된 mTLS | 서비스 간 통신을 암호화하고 상호 인증을 자동 적용하여 zero-trust 모델 실현 |

| 세밀한 접근 제어 | RBAC, 인증/인가, 정책 기반 보안 설정 가능 | |

| 관찰성 | 메트릭, 로그, 트레이싱 | 모든 트래픽을 자동 수집하여 실시간 모니터링, 장애 추적, 성능 분석에 활용 |

| APM 연동 지원 | Prometheus, Grafana, Jaeger 등과 연동하여 고급 관찰성 구현 | |

| 트래픽 제어 | 라우팅 정책 | Canary, A/B 테스트, 트래픽 쉐이핑, 미러링 등 고급 라우팅 정책 적용 가능 |

| 부하 분산 | 서비스 레벨에서 동적 라우팅, 로드밸런싱을 프록시 수준에서 수행 | |

| 회복력 | 장애 자동 복구 | 재시도, 타임아웃, 서킷브레이커, 폴백 (Fallback) 기능으로 고가용성 확보 |

| 운영 효율성 | 정책 중앙관리 | 컨트롤 플레인을 통해 보안/트래픽 정책을 선언적 방식 (YAML) 으로 일관되게 관리 |

| 점진적 도입 | 사이드카 방식으로 기존 시스템을 변경 없이 점진적으로 도입 가능 | |

| 인프라/정책 분리 | 네트워크 로직을 애플리케이션 코드에서 분리하여 인프라 계층으로 위임 | |

| 개발 생산성 | 비즈니스 로직 집중 | 개발자가 보안/네트워크 로직에서 벗어나 비즈니스 구현에만 집중 가능 |

| 언어 독립성 | 다양한 언어로 작성된 서비스 간에도 동일한 기능 제공 (프록시 기반) | |

| 확장성 | 정책 자동 적용 | 서비스 추가/삭제 시 컨트롤 플레인을 통해 자동 정책 적용으로 운영 부담 최소화 |

| 일관성 보장 | 모든 서비스에 동일한 네트워크/보안 정책을 자동 적용하여 구성의 표준화 가능 |

요약 정리

| 카테고리 | 핵심 장점 요약 문장 |

|---|---|

| 보안 | mTLS 와 인증 정책의 자동 적용을 통해 안전한 통신 보장 |

| 관찰성 | 트래픽, 로그, 메트릭, 트레이싱을 자동 수집하여 전체 시스템 가시성 확보 |

| 트래픽 제어 | 고급 라우팅 및 테스트 전략 (Canary, A/B 등) 을 통한 세밀한 트래픽 관리 |

| 회복력 | 서킷 브레이커, 재시도, 폴백을 통한 자동 장애 복구 기능 내장 |

| 운영 효율성 | 중앙 집중식 컨트롤 플레인으로 정책 관리 자동화 및 코드 분리 실현 |

| 개발 생산성 | 인프라 로직을 사이드카로 위임하여 개발자는 비즈니스 로직에만 집중 가능 |

| 확장성/일관성 | 서비스 증가에도 자동 정책 적용 및 구성 일관성 유지 |

단점과 문제점 그리고 해결방안

단점

| 구분 | 항목 | 설명 | 해결 방안 요약 |

|---|---|---|---|

| 운영 복잡성 | 구성 복잡도 | 사이드카, 정책, 제어 플레인 추가로 운영 난이도 상승 | 자동화 도구, 문서화, GitOps, 점진적 도입 |

| 학습 곡선 | 신규 기술 도입에 따른 팀 학습 부담 | 교육 프로그램, 단계적 도입, 교육 문서 제공 | |

| 성능 문제 | 프록시로 인한 오버헤드 | 사이드카 프록시로 인한 CPU/메모리 소비 및 지연 증가 | 경량 프록시, eBPF, Ambient Mesh 도입, 최적화 설정 |

| 네트워크 지연 | 프록시 추가 홉으로 인한 RTT 증가 | 커넥션 재사용, 성능 튜닝, 프록시 배치 최적화 | |

| 자원 사용량 | 리소스 소비 증가 | 서비스 수 증가 시 프록시 개수 및 사용 리소스 기하급수적으로 증가 | 리소스 할당 조절, 프록시 공용화 (Shared Proxy), HPA 적용 |

| 운영 부담 | 디버깅 및 모니터링 어려움 | 트래픽이 사이드카를 통해 흐르기 때문에 분석 복잡도 증가 | OpenTelemetry, Kiali, Jaeger 연동 시각화 |

| 기술 종속 | 벤더 종속성 | Istio, AWS App Mesh 등 특정 벤더 API 또는 구성 방식에 의존 | SMI 지원 메시 선택, 추상화 레이어 구성 |

- 운영 복잡성과 성능 이슈가 주요 핵심 단점.

- 사이드카 구조 자체의 한계 (리소스 소비, 디버깅 어려움 등) 가 중심.

- eBPF, ambient mesh, 자동화 도구 등으로 완화 가능.

문제점

| 구분 | 항목 | 원인 | 영향 | 탐지 및 진단 | 예방 및 해결 방안 요약 |

|---|---|---|---|---|---|

| 신뢰성 | 프록시 장애 | 사이드카 충돌, 리소스 부족, 설정 오류 | 서비스 간 통신 단절 | 헬스체크, 로그 분석, 알림 | 자동 재시작, 우회 경로 구성, Canary 배포 |

| 제어 플레인 장애 | Istiod 또는 Consul 등 제어 구성 장애 | 정책 배포 불가, 네트워크 분할 | 모니터링, 이중화 상태 점검 | 고가용성 구성, 백업 정책, failover 시나리오 설계 | |

| 정책/구성 문제 | 정책 충돌 / 구성 오류 | 중복, 상쇄 정책, 버전 차이, 인증서 만료 등 | 트래픽 차단, 잘못된 라우팅, 보안 문제 | CI/CD 설정 검증, 정책 테스트, 알림 | 선언적 정책 통합, 자동 검증 파이프라인, 롤백 메커니즘 구성 |

| 보안 문제 | 인증서 갱신 실패 | mTLS 인증서 만료, Citadel/CA 설정 미비 | TLS 연결 실패, 서비스 간 암호화 실패 | 인증서 만료 모니터링, 주기 점검 | 자동 갱신 설정, 예비 인증서 구성, 관리 자동화 |

| 성능 문제 | 병목/트래픽 과부하 | 프록시 설정 오류, 트래픽 집중, 리소스 과소 할당 | 전체 지연 증가, 타임아웃 발생 | 지연 분석, tracing, latency metrics | proxy-less 일부 도입, 프록시 분산, 리소스 확장 |

| 장애 확산 | 의존성으로 인한 장애 전파 | 서비스 간 강결합 및 장애 감지 미흡 | 전체 시스템 장애 유발 | 장애 전파 시각화, distributed tracing | 서킷 브레이커, 리트라이 정책, 격리된 서비스 구성 |

- 프록시 장애, 정책 오류, 제어 플레인 불안정이 주요 원인.

- 특히 mTLS 인증서 만료, 트래픽 병목, 장애 전파는 실무에서 자주 발생.

- CI 기반 자동 검증, Canary 배포, 서킷브레이커 등 실질적인 대응 전략 중요.

도전 과제

| 카테고리 | 도전 과제 | 설명 | 원인/영향 | 대표적인 해결 전략/기술 예시 |

|---|---|---|---|---|

| 성능 | 프록시 오버헤드 | 사이드카 프록시로 인한 네트워크 지연 및 리소스 소비 | 응답 시간 증가, CPU/메모리 증가 | eBPF, Ambient Mesh, 경량 프록시 도입 |

| 확장성 | 대규모 트래픽 또는 서비스 수 증가 시 제어/데이터 플레인의 병목 | 트래픽 증가에 따른 처리 지연, 제어 평면 과부하 | HPA, Scalable Control Plane, Istio Remote CP | |

| 운영 복잡성 | 멀티 클러스터/테넌시 관리 | 여러 클러스터 간 일관된 정책 적용 및 통합 제어 난이도 | 클러스터 간 통신 실패, 정책 불일치 | Federation, Global Control Plane, SMI 준수 |

| 복잡한 구성/운영 자동화 | 서비스 메시 도입 시 초기 설정, 사이드카 주입, 정책 구성의 복잡성 | 운영 부담 증가, 관리 오류 가능성 | Helm, IstioOperator, GitOps, Terraform, CI/CD | |

| 디버깅 및 문제 해결 어려움 | 트래픽 흐름이 사이드카를 경유하여 tracing 및 분석 난이도 증가 | 장애 원인 파악 지연, 운영 이슈 누락 | OpenTelemetry, Kiali, Jaeger, eBPF trace | |

| 보안 | 인증서 갱신 및 정책 충돌 | mTLS 인증서 수명 관리 실패, 정책 불일치로 인한 서비스 장애 | 인증 실패, 트래픽 차단, 보안 정책 미적용 | 자동 갱신 도구 (Citadel, Vault), 정책 검증 도구 |

| 이식성/호환성 | 레거시/이기종 환경 지원 | VM, 에지, 온프레미스 등 다양한 환경에서의 통합 운용 어려움 | Kubernetes 강의존성, 에지 환경 리소스 제약 | VM 지원 메시 (Linkerd, Kuma), Sidecar-less Mesh(e.g., Cilium) |

| L7 프로토콜 처리 한계 | HTTP/2, gRPC 등 고급 프로토콜 처리 시 eBPF 의 한계 | 성능 저하, 비정상 동작 발생 가능 | eBPF + Sidecar 하이브리드, WASM 필터로 기능 확장 | |

| 표준화 및 전략 | 상호운용성 부족 | 메시 솔루션 간 API/구성 방식 차이, 벤더 종속성 이슈 | 툴체인 변경 시 재설계 필요 | SMI 지원 메시 선택, Envoy 기반 구성으로 표준화 |

| 조직 내 도입 장벽 | SRE, DevOps 팀의 이해 부족 및 진입 장벽 존재 | 오·운영 및 정책 미적용, 장기 확산 실패 | 단계별 도입, 교육 프로그램 운영, 설계 시 도메인 중심 접근 |

요약 정리

| 범주 | 주요 이슈 설명 |

|---|---|

| 성능/확장성 | 프록시 구조의 한계로 인한 성능 저하, 트래픽 증가에 따른 병목 발생—eBPF 및 Ambient 구조로 완화 가능 |

| 운영 복잡성 | 구성, 정책, 사이드카 운영이 복잡하며, 다중 클러스터 또는 환경에서 운영 자동화 및 관리가 어려움 |

| 보안 문제 | 인증서 수명 관리, 정책 충돌 등 보안 정책의 일관성 유지가 어려움—자동화와 검증 체계 필요 |

| 이식성과 호환성 | 쿠버네티스 의존성, VM 및 에지 환경 대응 미비 등 다양한 워크로드에 대한 유연한 대응이 도전 과제 |

| 표준화 부족 | 솔루션 간 API 불일치 및 벤더 종속성—SMI 등 표준 인터페이스와 추상화 계층 도입이 필요 |

| 조직 내 도입 장벽 | 운영팀의 학습 곡선 및 도입 장벽으로 인해 메시 확산이 어려울 수 있음—체계적인 교육과 도입 전략 중요 |

도전 과제별 실제 사례 아키텍처

Pinterest - 사이드카 오버헤드 → Ambient Mesh 전환

사례:

- Pinterest 는 Istio 사이드카 프록시로 인해 서비스 호출 지연이 평균 12% 증가함.

- 대규모 트래픽 발생 시 CPU/메모리 급상승 문제 발생

대응 전략/해결 방법:

- Ambient Mesh PoC 도입하여 TCP-only 서비스에 사이드카 제거.

- 프록시 리소스 20~30% 절감

flowchart TD

subgraph Legacy_Sidecar

A1[App A] --> A2[Envoy Proxy]

B1[App B] --> B2[Envoy Proxy]

A2 -->|mTLS| MeshNet

B2 -->|mTLS| MeshNet

end

subgraph Ambient_Mesh

A3[App A] --> MeshTunnel

B3[App B] --> MeshTunnel

MeshTunnel --> MeshNet

end

style Legacy_Sidecar fill:#fff5f5,stroke:#f66

style Ambient_Mesh fill:#f5fff5,stroke:#6f6

전환 효과: 사이드카 제거 → CPU 사용량 30% 감소, 네트워크 RTT 10% 단축

T-Mobile - Multi-cluster 메시 연합 구성

사례:

- T-Mobile 은 4 개 이상의 K8s 클러스터를 연합 구성하여 운영 중, Istio 에서 클러스터 간 정책 불일치로 인한 트래픽 누락 현상 발생

대응 전략/해결 방법:

- Istio 의 Multi-primary 구성 + Gateway-based cross-cluster 설정을 통해 네임스페이스 격리 정책 통일

flowchart TD

subgraph Cluster-A

A1[Service A] --> A2[Ingress Gateway]

end

subgraph Cluster-B

B1[Service B] --> B2[Ingress Gateway]

end

A2 <--> B2

A2 --> CP1["Istiod (Primary)"]

B2 --> CP2["Istiod (Remote)"]

CP1 ---|Global Policies| CP2

Global Control Plane 연동을 통해 다중 클러스터 정책 동기화 달성

AutoTrader UK - 트레이싱 강화 (Kiali + OTEL)

사례:

- AutoTrader UK 는 서비스 간 예외 상황 발생 시 트래픽 경로가 사이드카 경유로 인해 trace 불완전, root cause 분석에 2 배 이상 시간 소요

대응 전략/해결 방법:

- Kiali + OpenTelemetry + Jaeger 를 통합하여 trace 흐름 시각화, alert 기반 전파 경로 추적 기능 도입

flowchart LR

User --> Proxy1[Envoy A]

Proxy1 --> App1[Service A]

App1 --> Proxy2[Envoy B]

Proxy2 --> App2[Service B]

Proxy1 & Proxy2 --> OTEL[OpenTelemetry Collector]

OTEL --> Jaeger["Jaeger (Tracing UI)"]

OTEL --> Prom[Prometheus]

Prom --> Grafana

subgraph Visualization

Jaeger --> Kiali

end

장애 원인 트레이싱 소요 시간 60% 단축

Skyscanner - AWS App Mesh → SMI 기반 메시 전환

사례:

- Skyscanner 는 App Mesh 에서 AWS 종속 API 사용으로 인해 멀티 클라우드 이전 시 완전한 재설계 필요 상태 발생

대응 전략/해결 방법:

- SMI-compatible 메시 (Linkerd) 로 전환, Terraform 기반 클라우드 중립 구성을 병행

flowchart TD

subgraph Vendor_Locked

C1[Service A] --> C2[AWS App Mesh Proxy]

C2 -->|AWS SDK/API 종속| AppMeshCP

end

subgraph SMI_Based

D1[Service A] --> D2[Linkerd Proxy]

D2 --> LinkerdCP[Linkerd Controller]

LinkerdCP -->|SMI Policy| Kubernetes

end

style Vendor_Locked fill:#f9f0ff,stroke:#985eff

style SMI_Based fill:#f0fff9,stroke:#58b68b

멀티클라우드 이전 시 설정 재사용률 80% 달성

도입 전략별 실패 사례 vs. 성공 사례 비교

| 분류 | 실패 사례 | 원인 | 성공 사례 | 핵심 전략 요약 |

|---|---|---|---|---|

| 운영 전략 | Netflix, Istio 도입 중 운영팀의 이해 부족으로 PoC 중단 | 내부 팀의 네트워크·프록시 개념 이해도 부족 | Tetrate, 내부 DevPortal + 템플릿 제공 | 운영팀 중심 교육 + 포털 기반 UI 제공 |

| 성능 최적화 | Pinterest, 초기 사이드카 구조에서 CPU 과다 사용 | 다수의 프록시 생성으로 노드당 리소스 초과 | Ambient Mesh 도입 + 사이드카 제거 | TCP-only 서비스에 Sidecar-less 구조 적용 |

| 멀티 클러스터 | 금융권 메시 연합 구성 실패 (클러스터 간 인증 정책 충돌로 장애) | 클러스터 간 네트워크 불일치 및 인증 체계 분리 | T-Mobile, Istio Multi-primary 구성 성공 | 인증 체계 통일 + 정책 제어를 외부 Gateway 기반으로 구성 |

| 관찰성 통합 | 일반 OTEL 미적용 시스템, 장애 시 root cause 파악 불가 | 사이드카가 트래픽을 변경하여 기존 로깅 시스템으로 추적 불가 | AutoTrader UK, Kiali + OTEL 통합 | 트레이싱 기반 원인 추적 시각화 도입 |

| 벤더 종속성 | Skyscanner, App Mesh 종속으로 멀티클라우드 전환 시 코드/정책 재작성 필요 | 벤더 API 에 직접 연결된 구조 | Linkerd 로 전환 후, SMI + Terraform 으로 구성 분리 | SMI 기반 메시 선택 + 벤더 추상화 레이어 구성 |

| 레거시 호환성 | Istio 기반 시스템에서 VM 연동 실패 → 외부 구성으로 우회 | 쿠버네티스 중심 구성, VM/온프레미스 연동 미흡 | Alibaba Cloud, Consul 기반 메시로 통합 | 서비스 디스커버리 기반 메시로 전환, VM/Container 혼합 처리 지원 |

Ambient Mode vs. Sidecar Mode 비교

| 항목 | Ambient Mode | Sidecar Mode |

|---|---|---|

| 구현 구조 | 노드 단위의 공용 프록시 (ztunnel) + 선택적 L7 프록시 (waypoint proxy) 사용 | 각 서비스 Pod 에 프록시 (Envoy 등) 를 사이드카로 주입 |

| 트래픽 처리 방식 | L4: ztunnel 이 처리 L7: waypoint proxy 필요 시만 사용 | L4/L7 트래픽을 모두 사이드카 프록시가 처리 |

| 프록시 위치 | 노드 레벨 (DaemonSet), 서비스별 공유 | 서비스마다 별도 존재 (Pod 내부 프록시) |

| 자원 사용량 | 낮음 (프록시 공유로 인한 절감) | 높음 (서비스 수만큼 프록시 인스턴스 필요) |

| 지연 시간 (Latency) | 낮음 (프록시 수 감소, 경로 최적화) | 상대적으로 높음 (트래픽마다 프록시 → 앱 경로 존재) |

| 보안 처리 방식 | ztunnel 에서 L4 보안 (mTLS) 적용 L7 보안은 선택 | 프록시에서 TLS, 인증, ACL 모두 적용 |

| 정책 적용 범위 | 네임스페이스/워크로드 레벨 정책 적용, L4/L7 분리 적용 가능 | 프록시 단위의 세밀한 정책 제어 |

| 운영 복잡성 | 낮음 (사이드카 주입, 버전 관리 불필요) | 높음 (프록시 버전 관리, 주입 실패 이슈 등) |

| 서비스 메시 적용성 | 부분 적용 가능, Gradual onboarding 용이 | 대부분 전면 적용 필요 (모든 서비스에 사이드카 주입 필요) |

| 업데이트/배포 전략 | 중앙화된 프록시 구성으로 업데이트 쉬움 (ZTunnel, Waypoint rolling update) | 서비스 재배포 필수 (프록시 이미지 변경 시 전체 Pod 재시작 필요) |

| 디버깅/관찰성 | ztunnel/waypoint 로그 중앙화로 디버깅 효율성 ↑ | 사이드카 단위 로그/메트릭 수집 필요, 복잡도 ↑ |

| 실제 적용 사례 | Istio Ambient Mesh (2022~), Cilium Service Mesh (eBPF 기반 L4 프록시) | Istio (기본 사이드카 모드), Linkerd, Consul Connect |

| 적합한 환경 | 대규모 서비스, 리소스 최적화 중요, 점진적 도입 환경 | 고관찰성/정밀 제어가 필요한 환경, 강력한 트래픽 정책 및 인증/인가 필요 시 |

- Ambient Mode는 운영 효율성과 리소스 절감에 강점을 가지며, 사이드카의 오버헤드를 제거함으로써 배포 복잡성과 비용을 줄일 수 있는 차세대 방식이다. 특히 대규모 클러스터나 점진적 메시 도입에 적합하다.

- Sidecar Mode는 정밀한 트래픽 제어와 보안 정책 적용에 강점을 가지며, 각 서비스 단위로 세밀한 설정과 확장 기능을 요구하는 환경에서 여전히 유효하다.

Service Mesh 기능 비교

| 항목 | Istio | Linkerd | Consul Connect | Cilium | AWS App Mesh |

|---|---|---|---|---|---|

| 프록시 구조 | 사이드카 / 앰비언트 | 사이드카 전용 | 사이드카 / 프록시리스 | 프록시리스 (eBPF) | 사이드카 전용 |

| 제어 플레인 | 완전 통합형 | 경량형 | 통합 가능 (Nomad/K8s) | 별도 제어 플레인 없음 | 완전 관리형 |

| 프록시 엔진 | Envoy | 자체 프록시 (linkerd2-proxy) | Envoy | eBPF | Envoy |

| 보안 기능 | mTLS, OPA, 인증/인가 | 기본 mTLS 제공 | mTLS + ACL | eBPF 레벨 제어 | mTLS, IAM 통합 |

| 트래픽 제어 기능 | Advanced (A/B, Canary, Mirroring) | 기본 라우팅 지원 | L7 라우팅 제공 | 제한적 (L4 수준 eBPF) | 기본 제공 |

| 관찰성 기능 | Prometheus, Grafana, Jaeger | Prometheus + Grafana | Consul UI + 외부 통합 가능 | Hubble (eBPF 기반) | CloudWatch 등 AWS 연계 |

| 멀티 클러스터 지원 | 지원 (Gateway or VPN) | 제한적 | 지원 (WAN Federation) | 제한적 | VPC 기반 지원 |

| 운영 복잡도 | 높음 | 낮음 | 중간 | 낮음 | 매우 낮음 |

| 플랫폼 지원 | K8s + VM | K8s 전용 | K8s + VM | K8s 전용 | AWS VPC 내부 서비스 전용 |

| 커뮤니티/상용 여부 | 오픈소스 / 상용 도구 다수 | 오픈소스 | 오픈소스 + HashiCorp | 오픈소스 | 상용 (AWS 관리형) |

선택 가이드 (Deployment Decision Guide)

| 조건 / 요구사항 | 적합 솔루션 | 비고 |

|---|---|---|

| Canary, A/B 배포, 세밀한 라우팅 필요 | Istio, AWS App Mesh | 복잡한 트래픽 정책 구현 |

| 빠른 설치 및 운영 단순화 우선 | Linkerd | 초기 도입, 교육 비용 낮음 |

| 멀티 플랫폼 (K8s + VM) 연동 필요 | Consul, Istio | VM 서비스 통합 시 필요 |

| 제로 트러스트 및 고급 보안 정책 필요 | Istio + OPA | 인증/인가 정책 통합 가능 |

| 프록시 오버헤드 줄이고 싶음 (고성능) | Cilium | eBPF 기반 |

| 멀티 클러스터 간 통신 필요 | Istio, Consul | VPN, Mesh Gateway 활용 |

| 전체 AWS 에 통합된 서비스 운영 예정 | AWS App Mesh | AWS ALB, ECS, Fargate 등 연계 |

| 코드에 직접 메시 기능 삽입해야 함 (Spring 등) | Spring Cloud (Proxy-less) | 마이크로서비스 SDK 기반 방식 |

적합 아키텍처 추천 (Architecture Use Cases)

| 아키텍처 시나리오 | 추천 Service Mesh | 아키텍처 구성 방식 요약 |

|---|---|---|

| Kubernetes 기반 마이크로서비스 관찰 + 보안 통합 | Istio | Sidecar + Envoy + Control Plane, Prometheus/Grafana 연동 |

| 경량화된 마이크로서비스 간 통신 제어 + 빠른 운영 | Linkerd | 사이드카 기반, 단순화된 설치 및 기본 mTLS/메트릭 제공 |

| K8s + VM 혼합 클러스터 통합 서비스 메시 | Consul Connect | 서비스 디스커버리 중심, ACL 기반 보안, 외부 서비스 연계 가능 |

| 퍼블릭 클라우드 기반 서비스 (AWS) | AWS App Mesh | 관리형 서비스 메시, Envoy 프록시 자동 구성, IAM 인증 연계 |

| 고성능, 네이티브 L4 수준 메시 필요 (프록시리스) | Cilium + Hubble | eBPF 기반 사이드카 제거형, 고속 네트워크 제어와 관찰성 제공 |

| Spring 기반 모놀리식 → 마이크로서비스 점진 이전 | Spring Cloud Gateway + Netflix OSS | 프록시 없는 라이브러리 기반 구성, 코드 내 직접 메시 지원 |

분류 기준에 따른 종류 및 유형

| 분류 기준 | 유형 | 특징/설명 | 대표 솔루션 |

|---|---|---|---|

| 프록시 방식 | 사이드카 (Sidecar) | 서비스마다 별도 프록시 주입 (프록시 컨테이너) | Istio, Linkerd, Consul |

| 프록시리스 (Proxy-less) | 프록시 제거, 라이브러리/SDK 형태로 직접 구현 | Consul (Connect), Spring Cloud | |

| 노드 공유형 (Shared Node) | 노드 단위로 하나의 프록시가 여러 서비스 처리 | Istio Ambient Mesh, Cilium (eBPF) | |

| 아키텍처 복잡도 | 경량형 (Lightweight) | 필수 기능만 제공, 간단한 설정, 빠른 도입 가능 | Linkerd, Kuma |

| 고기능형 (Fully-featured) | 고급 트래픽 제어, 보안, 정책 관리, 멀티 클러스터 지원 등 통합 기능 제공 | Istio, AWS App Mesh | |

| 배포 환경 | Kubernetes 전용 | K8s 에 최적화된 통합, CRD 기반 정책 관리 | Linkerd 2.x, OSM |

| 멀티 플랫폼/하이브리드 | K8s + VM, 클라우드 환경 통합 지원 | Istio, Consul | |

| 제어 플레인 구조 | 통합형 | API Gateway, 보안, 정책 등 통합 제어 | Istio, Gloo Mesh |

| 경량 제어 플레인 | 최소 구성, 간단한 정책 적용 | Linkerd, OSM | |

| 보안 모델 | mTLS 전용 | 인증/암호화에 집중, 네트워크 보안 중심 | Linkerd, Kuma |

| 확장형 (OPA 등 포함) | 인증, 권한 정책, 감사 로그 등 보안 모델 확장 가능 | Istio(+OPA), Consul ACL | |

| 설치 방식 | 오픈소스 설치형 | 직접 설치 및 운영, 커뮤니티 기반 | Istio, Linkerd, Consul |

| 상용 솔루션/관리형 | 퍼블릭 클라우드 기반 완전 관리형 | AWS App Mesh, Gloo Mesh | |

| 프록시 구현체 | Envoy 기반 | 고성능, 고확장성, 다양한 필터 체인 지원 | Istio, AWS App Mesh, Gloo Mesh |

| 경량 자체 구현 | 빠른 성능, 간단한 구조 | Linkerd-proxy, Kuma-dp | |

| 연동 방식 | 라이브러리 기반 | 라이브러리 형태로 직접 연동, 어플리케이션과 강한 결합 | Spring Cloud, Netflix OSS |

| 플랫폼 내장형 (PaaS 통합) | 플랫폼에 서비스 메시 기능 내장 | Azure Service Fabric, Lagom | |

| 운영 형태 | 단일 클러스터 | 단일 K8s 클러스터 내에서 통신 및 제어 | 대부분의 기본형 Service Mesh |

| 멀티 클러스터 | 여러 클러스터 간 서비스 간 연결 및 정책 통합 지원 | Istio, Consul |

요약 정리

| 카테고리 | 핵심 요약 |

|---|---|

| 프록시 구조 | 사이드카, 프록시리스, 공유형으로 나뉘며, 리소스 및 제어 방식에 따라 선택 |

| 아키텍처 복잡도 | 경량형은 빠른 도입과 간결성, 고기능형은 복잡한 시나리오 대응에 적합 |

| 배포 환경 | Kubernetes 전용 또는 멀티 플랫폼 지원 여부에 따라 연동 전략 구분 |

| 제어 평면 설계 | 통합형은 정책/트래픽/보안 통합 관리, 경량형은 단순 구성과 빠른 반응에 유리 |

| 보안 모델 | mTLS 전용 또는 OPA/ACL을 포함한 확장 보안 지원 모델 구분 |

| 설치 및 운영 형태 | 오픈소스 자가 설치 또는 클라우드 기반 관리형 서비스 여부에 따라 운영 복잡도 상이 |

| 프록시 구현체 | Envoy가 주류이나, 경량 자체 프록시도 활용됨 (성능 중시 시) |

| 연동 방식 | SDK 기반 또는 PaaS 내장형으로도 구현 가능, 운영 환경과 밀접하게 연관됨 |

| 멀티 클러스터 지원 여부 | 단일 클러스터에서 시작하여 멀티 클러스터 연동은 엔터프라이즈 환경에서 고려됨 |

실무에서 효과적으로 적용하기 위한 고려사항 및 주의할 점

| 카테고리 | 항목 | 고려사항 / 설명 | 권장 사항 |

|---|---|---|---|

| 도입 전략 | 점진적 마이그레이션 | 모든 서비스에 일괄 적용 시 장애 위험 | 파일럿 서비스 선정 → 핵심 서비스로 확산 GitOps 기반 롤백 전략 수립 |

| 도입 범위 설정 | 전면 도입 vs 단계별 도입 선택 필요 | 서비스 영향도 기반 우선순위 설정 | |

| 성능 관리 | 프록시 오버헤드 | 사이드카 프록시로 인한 CPU/메모리 소비 증가 | 리소스 제한 설정 (limit/request), 성능 테스트, 사이드카리스 옵션 비교 |

| 네트워크 튜닝 | 커넥션 풀, 타임아웃, keepalive 등 미세 조정 필요 | outlierDetection, connPool, timeout 설정 최적화 | |

| 메트릭/로그 과다 | 과도한 수집 → 저장소 부담, 성능 저하 | 샘플링 비율 조정, 로그 필터링, 보존 기간 설정 | |

| 보안 설정 | 인증서 관리 | mTLS 인증서 만료, 자동 갱신 실패 시 통신 중단 가능 | cert-manager, Citadel 연동단명 인증서 + 자동 순환 + 상태 알림 구성 |

| 제로 트러스트 모델 | 내부 통신도 반드시 인증 및 암호화 적용 필요 | mTLS + ACL/OPA 정책 적용, 상호 인증 상태 시각화 | |

| 컨트롤 플레인 보안 | 제어 플레인에 대한 공격 가능성 존재 | RBAC 적용, 네트워크 정책 구성, 감사 로깅 | |

| 운영 자동화 | 사이드카 자동 주입 | 자동 주입 실패 시 통신 불가 → 비즈니스 영향 | Istio Injector 또는 Helm/Operator 기반 구성 검증 |

| 정책 적용 자동화 | 버전 불일치, 정책 충돌로 인한 장애 가능성 | 테스트 클러스터에서 사전 Canary 적용 → 본배포 CI/CD 연동 자동 검증 | |

| 제어 플레인 고가용성 | 단일 제어 노드 장애 시 전체 정책 적용 중단 | 복수 제어 노드 구성, 멀티 클러스터 플레인 구성 | |

| 관찰성 | 통합 관찰 도구 연계 | 관찰성 도구 미비 시 장애 분석 어려움 | OpenTelemetry 기반 통합 (Prometheus, Grafana, Jaeger, Kiali 등) |

| 로그/트레이싱 관리 | 저장소 및 비용 부담, 필터링 없이 수집 시 비효율 | 샘플링 조정 + 로그 레벨별 필터 + 대시보드 연동 최적화 | |

| 조직 역량 | 운영 팀 교육/훈련 | 메시 설정 및 정책 구성 오류 가능성 높음 | 단계별 교육 (기초 → 고급), 실습 환경 제공, 운영 Runbook/문서화 |

| DevOps/SRE 협업 | 메시 운영은 인프라 + 어플리케이션 협업 필요 | 도입 초기부터 운영/개발 연계된 협업 체계 구축 | |

| 장애 대응 | 프록시/정책 장애 | 설정 오류, 프록시 다운 시 전체 통신 불가 | livenessProbe 설정, 재시작 전략 구성, 롤백 가능한 GitOps 방식 적용 |

| 백업/우회 계획 | 전체 메시 다운 시 비상 통신 경로 확보 필요 | Sidecar 제거 시나리오, 레거시 라우팅 경로 유지, 비활성화 fallback 경로 설정 | |

| 네트워크 구성 | CNI 및 프록시 충돌 이슈 | 메시 프록시와 네트워크 플러그인 간 충돌 가능 | Calico, Cilium 등 CNI 와의 호환성 테스트 및 구성 문서화 |

요약 정리

| 카테고리 | 핵심 요약 문장 |

|---|---|

| 도입 전략 | 무중단 도입을 위해 점진적 확산 전략 수립과 파일럿 서비스 테스트가 필수이다. |

| 성능 관리 | 프록시 자원 사용과 네트워크 설정 최적화 없이는 전체 시스템 성능 저하로 이어질 수 있다. |

| 보안 | 인증서 자동 갱신, mTLS, 정책 분리는 필수이며, 보안 감사와 제어 평면 보호가 중요하다. |

| 운영 자동화 | 사이드카 주입, 정책 적용, 고가용성 제어 플레인은 모두 자동화 및 안정화가 필요하다. |

| 관찰성 | OpenTelemetry 기반의 통합 관찰 도구 연동 없이는 문제 추적이 어려워진다. |

| 조직 역량 | 운영팀의 교육과 문서화, 협업 기반의 구조 설계가 도입 성공의 핵심이다. |

| 장애 대응 | 메시 장애 시를 대비한 롤백, 비활성화 시나리오, 프록시 우회 경로 구성은 필수이다. |

| 네트워크 구성 | 네트워크 CNI 와 메시 구성의 호환성 확보는 성능과 안정성에 직결된다. |

최적화하기 위한 고려사항 및 주의할 점

| 카테고리 | 최적화 대상 | 주요 고려사항 및 설명 | 권장 사항 |

|---|---|---|---|

| 성능 최 | 사이드카 프록시 설정 | Envoy 리소스 소모를 줄이기 위한 커넥션 풀, 타임아웃, 버퍼 등 최적화 | 커넥션 풀 조정, 버퍼 크기 최적화, Keep-alive 설정, 필요 기능만 활성화 |

| 리소스 | 리소스 할당 / 제한 | 과도한 사이드카 리소스 소모 방지 및 효율적인 사용 (메모리/CPU 과소 or 과다 할당 주의) | HPA/VPA 적용, requests/limits 설정, 불필요 기능 비활성화, 워크로드별 설정 적용 |

| 네트워크 적화 | 트래픽 경로 및 지역성 라우팅 | 사이드카 간 과도한 홉, 비효율적 경로, 글로벌/다중 리전 환경에서의 RTT 증가 등 고려 | eBPF, Ambient Mesh, 지역성 기반 라우팅, CDN 활용, Protocol 최적화 |

| 보 화 | mTLS, 제로 트러스트 구현 | 보안 설정 누락, TLS 부하 증가, 권한 관리 미흡 등 문제 발생 가능 | PeerAuthentication STRICT 적용, RBAC/ABAC 정책 기반 접근제어, 인증 자동화 |

| 관 최적화 | 메트릭/로그/트레이싱 수집 | 과도한 수집 → 성능 저하 / 저장소 부하 / 네트워크 트래픽 증가 | 수집 항목 필터링, 샘플링 비율 (10%) 적용, 불필요 라벨 제거, scrape 간격 증가 |

| 최적화 | 트래픽/보안 정책 구성 | 정책이 복잡하거나 중복될 경우 성능 저하 및 디버깅 어려움 발생 | 선언형 정책 정비, A/B 테스트 범위 제한, 정책 TTL 설정, 테스트 정책 우선 적용 |

| 및 운영 | 자동화 및 버전 관리 | 수동 설정 시 실수 발생, 업그레이드 시 하위 호환성 주의 | GitOps + ArgoCD, Canary 배포, 구성 변경 이력 추적 및 롤백 가능성 확보 제어 플레인 관리 제어 플레인 관리 |

요약 정리

| 핵심 영역 | 요약 설명 |

|---|---|

| 성능 최적화 | 사이드카 (Envoy) 설정을 통해 트래픽 처리 효율을 높이고 자원 낭비를 방지해야 함. |

| 리소스 관리 | HPA/VPA 와 request/limit 설정으로 각 마이크로서비스와 사이드카 자원의 균형 필요. |

| 네트워크 최적화 | 불필요한 네트워크 홉을 줄이고 지역성 기반으로 지연시간을 최소화하는 라우팅 구성 필요. |

| 보안 강화 | mTLS 를 기본으로 설정하고 최소 권한 정책을 자동화 도구와 연계해 유지해야 함. |

| 관찰성 최적화 | 수집 대상과 수집량을 제한하고 샘플링 및 저장소 부하 분산 전략이 필요함. |

| 정책 간소화 | 정책 중복 최소화와 테스트/실험 정책은 TTL 등 유효성 기반으로 관리해야 함. |

| 운영 자동화 | 수동 작업 최소화, 자동 롤백, 구성 이력 추적 등의 자동화를 GitOps 도구와 연계해야 함. |

| 제어 평면 안정화 | Control Plane 의 고가용성 확보와 구성 전파 트래픽 제어가 필요함. |

실무 적용 예시

| 분류 | 사용 목적 | 함께 사용되는 기술 | 기대 효과 / 실현 기능 |

|---|---|---|---|

| ** 트래픽 관리** | Canary 배포, A/B 테스트 | Istio, Kubernetes, GitOps, Argo Rollouts | 버전별 트래픽 분할 (10→90%), 점진 배포, 위험 최소화 |

| Circuit Breaker, Retry 설정 | Istio, Envoy, E-commerce 시스템 | 장애 복구, 서비스 연속성 강화 | |

| 트래픽 분산 및 L7 라우팅 | Istio, Linkerd, Envoy, NGINX | 안정적 라우팅, 비즈니스 별 분기 정책 구현 | |

| ** 보안 강화** | 서비스 간 mTLS 암호화 및 인증 | Istio, Linkerd, Consul, Zero Trust Architecture | 무결성 보장, 제로 트러스트 보안 모델, TLS 자동화 |

| 외부 인증 흐름 통합 | Istio + FastAPI (External AuthZ) | 서비스 외부에서 인증 처리, 정책 유연성 확보 | |

| VM + K8s 통신 보안 통합 | Istio, Consul Connect | 온프레미스 - 클라우드 통합 보안, 하이브리드 환경 지원 | |

| ** 관찰성 및 추적** | 실시간 메트릭 수집 및 대시보드 | Prometheus, Grafana, Istio, Linkerd | 성능 모니터링, 대시보드 기반 운영 개선 |

| 분산 트레이싱 및 장애 추적 | Jaeger, Kiali, Envoy | 서비스 간 호출 추적, 지연 원인 분석 | |

| 에지 레벨 고성능 네트워크 관찰 | Cilium + Hubble | eBPF 기반 관찰성, Sidecar-less 통신 추적 가능 | |

| ** 운영 효율화** | GitOps 기반 배포 자동화 | ArgoCD, Helm, Istio | 배포 일관성, 자동화된 릴리즈 전략 구현 |

| 사이드카 없는 경량 메시 운영 | Envoy + gRPC, Cilium (eBPF) | 레이턴시 감소, 리소스 절약, 운영 간소화 | |

| SaaS / PaaS 서비스 통합 관리 | AWS App Mesh, EKS | 고가용성, 운영 자동화, 클라우드 자원 최적화 | |

| ** 아키텍처 유연성** | 멀티 클러스터/멀티 플랫폼 연동 | Istio, Consul, Mesh Gateway, Federation | 클러스터 간 연결 및 일관된 정책 적용, 하이브리드 환경 대응 |

| 레거시 시스템 연동 | Consul Connect (VM + K8s) | VM 기반 시스템 연계, 점진적 마이그레이션 |

요약 정리

| 카테고리 | 핵심 요약 |

|---|---|

| 트래픽 제어 | Canary, Circuit Breaker, A/B 테스트 등 고급 트래픽 정책 구현 |

| 보안 강화 | 서비스 간 자동화된 mTLS, 외부 인증 서버 통합, VM 연계 보안 |

| 관찰성 향상 | 실시간 메트릭 수집, 분산 트레이싱, eBPF 기반 고성능 네트워크 가시화 |

| 운영 자동화 | GitOps 기반 배포, 사이드카 제거, 클라우드 운영 최적화 |

| 유연한 아키텍처 | 멀티 클러스터 및 하이브리드 환경 지원, 레거시 시스템과의 연동 유연성 확보 |

활용 사례

사례 1: Kubernetes 기반 대형 전자상거래 서비스에 Istio 도입

시나리오:

Kubernetes 기반 대형 전자상거래 서비스에 Istio 도입,

- 외부 (고객) 트래픽은 API Gateway 로,

- 내부 서비스간 트래픽은 Istio Service Mesh 가 mTLS 로 암호화, 장애 시 자동 재시도/우회,

- 관리자는 대시보드로 서비스 간 지연, 장애, 인증 상태를 시각적 모니터링

시스템 구성

flowchart LR

User --> APIGW("API Gateway")

APIGW --> S1["(Pod) Order Service\n+ Sidecar"]

APIGW --> S2["(Pod) Product Service\n+ Sidecar"]

APIGW --> S3["(Pod) Payment Service\n+ Sidecar"]

S1 <--> S2

S1 <--> S3

ControlPlane("Istio Control Plane") -.-> S1

ControlPlane -.-> S2

ControlPlane -.-> S3

유무 비교:

Service Mesh 미사용 시: 각 서비스마다 인증/보안/장애처리 코드 내장 필요, 가시성/관리가 어려움

Service Mesh 도입 후: 인프라 계층 일원화 관리, 장애 복원, 실시간 시각화, 인증 자동화

구현 예시:

- YAML 선언식 구현 예시 (트래픽 라우팅 정책, Istio VirtualService)

| |

80% 는 새로운 v2, 20% 는 기존 v1 로 분할 배포 (카나리 배포 예시), 정책 선언만으로 운영 수준 트래픽 제어

사례 2: 멀티 클러스터 전자상거래 서비스

아키텍처 & Workflow:

graph LR

subgraph Cluster-A

SvcA1 --- SidecarA1

SvcA2 --- SidecarA2

end

subgraph Cluster-B

SvcB1 --- SidecarB1

end

SidecarA1 <--> SidecarB1

ControlPlaneA & ControlPlaneB <--> SharedControlPlane

- Cluster A ↔ Cluster B 사이의 mTLS 통신

- Control Plane 은 공유 혹은 페더레이션 구조

- **서비스 간의 클러스터 간 호출이 정책적으로 허용됨

사용 목적: 데이터 지역성 유지 + 글로벌 트래픽 관리

장점: 클러스터 경계를 넘는 mTLS 보안 유지, 글로벌 정책 일관성

차이점: 메시 없이 서비스 간 직접 호출 시 보안·관찰성 미흡 → 메시 도입으로 정책 수준 통제 가능

구현 예시:

- Istio 멀티 클러스터 구성 주요 목표

| 구성 요소 | 설명 |

|---|---|

| Sidecar | 각 서비스 옆에 위치하여 통신 관리를 담당 (Envoy 프록시) |

| Shared Control Plane | 각 클러스터와 연동되어 글로벌 정책을 배포/제어 |

| ServiceEntry | 외부 (다른 클러스터) 의 서비스 정의 및 접근 허용 |

| DestinationRule | 클러스터 간 mTLS 정책 설정 |

| VirtualService | 트래픽 라우팅 정의 (클러스터 경계를 넘는 경우 포함) |

- Istio 멀티 클러스터 설정 예시

ServiceEntry (Cluster A → Cluster B 서비스 호출 허용)

- 목적: Cluster-A 에서 Cluster-B 의

svc-b1호출 가능하도록 설정.

- 목적: Cluster-A 에서 Cluster-B 의

DestinationRule (mTLS 설정 포함)

- 목적: Cluster A 의 Envoy 프록시가 Cluster B 로 mTLS로 통신하도록 지정.

VirtualService (Cluster A 에서 요청 라우팅)

- 목적: Cluster A 의 요청을 Cluster B 의 서비스로 직접 라우팅.

PeerAuthentication (글로벌 mTLS 설정)

- 목적: 모든 트래픽에 대해 mTLS 적용 강제화 (클러스터 간 포함)

Gateway 구성 (옵션: 멀티 클러스터 간 Ingress 연결 시)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17apiVersion: networking.istio.io/v1beta1 kind: Gateway metadata: name: cluster-b-gateway spec: selector: istio: ingressgateway servers: - port: number: 443 name: https protocol: HTTPS hosts: - svc-b1.ecom-b.svc.cluster.local tls: mode: ISTIO_MUTUAL credentialName: tls-secret

사례 3: 전자상거래 플랫폼의 서비스 메시 적용

전자상거래 플랫폼의 서비스 메시 적용

대규모 전자상거래 플랫폼에서 주문, 결제, 재고, 배송 등 다양한 마이크로서비스 간 통신을 관리하기 위해 Istio 서비스 메시를 도입한 사례입니다.

시스템 구성:

graph TB

subgraph "External"

USER[Users]

API_GW[API Gateway]

end

subgraph "Service Mesh"

subgraph "Frontend Services"

WEB[Web Service]

MOBILE[Mobile API]

end

subgraph "Business Services"

ORDER[Order Service]

PAYMENT[Payment Service]

INVENTORY[Inventory Service]

SHIPPING[Shipping Service]

end

subgraph "Data Services"

USER_DB[(User DB)]

ORDER_DB[(Order DB)]

INVENTORY_DB[(Inventory DB)]

end

end

subgraph "Istio Control Plane"

PILOT[Pilot]

CITADEL[Citadel]

GALLEY[Galley]

end

USER --> API_GW

API_GW --> WEB

API_GW --> MOBILE

WEB --> ORDER

MOBILE --> ORDER

ORDER --> PAYMENT

ORDER --> INVENTORY

ORDER --> SHIPPING

ORDER --> ORDER_DB

INVENTORY --> INVENTORY_DB

Workflow:

- 사용자 요청이 API Gateway 를 통해 진입

- Istio Envoy Proxy 가 모든 서비스 간 통신 가로채기

- 트래픽 정책에 따라 라우팅 및 로드 밸런싱 수행

- 상호 TLS 로 서비스 간 보안 통신 보장

- 메트릭 및 추적 정보를 Prometheus, Jaeger 로 전송

서비스 메시의 역할:

- 결제 서비스의 카나리 배포를 통한 안전한 업데이트

- 재고 서비스 장애 시 자동 서킷 브레이커 동작

- 모든 서비스 간 통신에 대한 실시간 모니터링

서비스 메시 유무에 따른 차이점:

| 구분 | 서비스 메시 없음 | 서비스 메시 있음 |

|---|---|---|

| 보안 | 애플리케이션 레벨 TLS 구현 | 자동 상호 TLS 적용 |

| 모니터링 | 각 서비스별 개별 구현 | 통합된 관찰성 대시보드 |

| 배포 | 수동 블루 - 그린 배포 | 자동화된 카나리 배포 |

| 장애 처리 | 개별 서비스의 재시도 로직 | 중앙 집중식 서킷 브레이커 |

구현 예시:

카나리 배포:

VirtualService+DestinationRule

-> 결제 서비스 (Payment Service) 에 v1, v2 를 순차적으로 배포- 배포가 안정되면

v2의 비중을 점차 늘려 전체 전환 가능. DestinationRule

VirtualService

- 배포가 안정되면

서킷 브레이커:

DestinationRule

-> 재고 서비스 (INVENTORY) 가 장애 발생 시, 일정 시간 차단 및 자동 복구- 특정 횟수 이상 오류 발생 시 요청 차단 → 일정 시간 후 자동 복구

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18apiVersion: networking.istio.io/v1beta1 kind: DestinationRule metadata: name: inventory-circuit-breaker spec: host: inventory trafficPolicy: connectionPool: tcp: maxConnections: 1 http: http1MaxPendingRequests: 1 maxRequestsPerConnection: 1 outlierDetection: consecutive5xxErrors: 1 interval: 10s baseEjectionTime: 30s maxEjectionPercent: 100mTLS 자동 적용:

PeerAuthentication- 전체 네임스페이스에 대해 서비스 간 통신은 반드시 mTLS 로 수행하도록 강제.

트래픽 관찰성: Prometheus, Jaeger 연동

Istio 설치 시 기본적으로 아래 요소가 포함되며, 설정만 추가하면 됨:

- Prometheus - 메트릭 수집 (

istio-proxy에서 지표 수집) - Grafana - 메트릭 시각화

- Jaeger/Zipkin - 분산 추적 시각화

- Kiali - 서비스 메시 구조 + 트래픽 흐름 시각화

- Prometheus - 메트릭 수집 (

예시: Telemetry 설정

사례 4: Istio 기반 마이크로서비스 환경에서의 트래픽 관리 및 분산 트레이싱

시스템 구성: Kubernetes 클러스터 + Istio(서비스 메시) + Envoy(프록시) + Jaeger(분산 트레이싱)

워크플로우:

- 클라이언트 → API Gateway → 서비스 A (사이드카 프록시)

- 서비스 A → 서비스 B (프록시 간 통신)

- 모든 트래픽은 Jaeger 에서 추적

역할: 트래픽 라우팅, 로드 밸런싱, 보안, 모니터링, 분산 트레이싱

차이점: 기존 라이브러리 기반 (Spring Cloud) 은 언어 종속적, 서비스 메시는 언어 독립적

구현 예시:

- 서비스 메시 자체는 인프라 계층이므로 코드 구현보다는 설정 예시를 제공합니다.

| |

사례 5: e‑commerce 플랫폼 안정성

목적: 블랙프라이데이 같이 트래픽 급증 시 서비스 안정성 확보

기술 스택: Kubernetes, Istio, Envoy

시스템 구성:

graph TD

User --> IngressGW[Envoy Ingress Gateway]

IngressGW --> svc-v1

IngressGW --> svc-v2

svc-v1[Checkout v1 + Envoy] --> svc-db

svc-v2[Checkout v2 + Envoy] --> svc-db

subgraph Control Plane

Pilot

Citadel

end

Workflow:

- Ingress Gateway 통해 외부 요청 수신

- VirtualService 로 v2 버전 트래픽을 20% 할당

- Pilot 이 VirtualService 설정을 각 Envoy 에 배포 (xDS)

- 사이드카 Envoy 에서 Retry/Timeout/Circuit-Breaker 자동 적용

- Citadel 이 mTLS 인증서 자동 할당 및 갱신

- 정상 여부 모니터링, 성능 충족 시 점진적 v2 트래픽 증가

효과:

- 코드 변경 없이 레이어에서 안정성/보안 확보

- 실패 시 장애 스트래티징을 통한 롤백 우회

- 실무 대비 트래픽 제어 및 CNCF 준수 환경 제공

구현 예시:

- Python + Istio VirtualService (Canary 배포)

| |

- 이 코드와 YAML 은 20% v2, 80% v1 배포 리스크 완화

- Envoy 사이드카가 자동으로

retries,timeout,fault injection정책 집행

주목할 내용

| 카테고리 | 주제 | 항목/기술 | 설명 |

|---|---|---|---|

| 구조/아키텍처 | 사이드카 패턴 | Sidecar Proxy | 각 서비스 옆에 배치된 프록시가 모든 트래픽을 중계하고 정책 적용 |

| 앰비언트 메시 | Ambient Mesh | 사이드카 없이 노드 단에서 메시 기능을 수행하는 경량화 아키텍처 | |

| Proxy-less 메시 | eBPF, XDP 기반 | 커널 수준에서 네트워크 트래픽 처리로 사이드카 제거, 성능 최적화 | |

| 운영/관리 | 정책 기반 운영 | 선언형 정책 (YAML/JSON) | 코드 수정 없이 정책 제어 가능 (예: VirtualService, DestinationRule) |

| 자동 복구 및 장애 회복 | 서킷 브레이커, 재시도, 페일오버 | 서비스 연속성 확보 및 복원력 강화 | |

| 배포 자동화 | GitOps (ArgoCD, Flux) | Git 기반 선언형 구성 및 배포 자동화 | |

| 관찰성/모니터링 | 분산 추적 | Jaeger, Zipkin, Kiali | 마이크로서비스 간 요청 추적 및 병목 탐지 |

| 통합 텔레메트리 | OpenTelemetry | 메트릭, 로그, 트레이스를 통합 수집하는 표준 프레임워크 | |

| 보안 | mTLS | Mutual TLS | 서비스 간 양방향 인증 및 암호화된 통신 제공 |

| 제로 트러스트 | 인증 + 접근 제어 | 모든 요청을 암호화 및 검증, 내부 네트워크도 신뢰하지 않음 | |

| 신원 관리 | SPIFFE/SPIRE | 서비스 간 ID 발급 및 인증 기반 프레임워크 | |

| RBAC | 역할 기반 접근 제어 | 서비스, 사용자에 따라 리소스 접근 권한 제어 | |

| 표준/인터페이스 | SMI (Service Mesh Interface) | 쿠버네티스용 메시 표준 API | 다양한 메시 구현체 간 벤더 중립적 상호운용 API 정의 |

| 최적화 기술 | eBPF | 커널 레벨 트래픽 제어 | 낮은 오버헤드로 사이드카리스 메시 구현 지원 |

| 도구 | Istio | 대표 오픈소스 서비스 메시 | 풍부한 기능 + 대규모 적용 사례 보유 |

| Linkerd | 경량 서비스 메시 | 퍼포먼스 우선 설계, 빠른 배포 및 낮은 러닝커브 | |

| Kiali | Istio 관찰성 시각화 도구 | 네트워크 그래프, 트래픽 흐름, 상태 모니터링 제공 |

- 아키텍처 진화: 기존 사이드카 기반 구조에서 앰비언트 메시, eBPF 기반 Proxy-less 메시로 확장되고 있음.

- 운영 자동화: 선언형 정책, GitOps 기반 배포, 서킷 브레이커 기반 장애 회복 전략이 핵심 운영 방식으로 자리 잡음.

- 보안의 표준화: mTLS 와 제로 트러스트는 모든 서비스 메시 설계의 기본 보안 모델이며, SPIFFE 기반 ID 인증도 필수 요소.

- 관찰성 통합: OpenTelemetry, Jaeger, Kiali 를 통한 시각화 및 추적이 운영과 디버깅의 중심이 되고 있음.

- 벤더 중립성: SMI 는 다양한 서비스 메시 구현체 간 호환성과 이식성 확보를 위한 핵심 표준으로 주목됨.

반드시 학습해야할 내용

| 카테고리 | 주제 | 핵심 항목 | 설명 |

|---|---|---|---|

| 기초 이론 | 마이크로서비스 아키텍처 | 서비스 메시 기반 구조, 아키텍처 패턴 이해 | Service Mesh 는 마이크로서비스 아키텍처의 통신 계층을 담당함 |

| 플랫폼 인프라 | Kubernetes | Pod, Service, Ingress, CRD | Mesh 는 K8s 위에서 동작하며 선언적 리소스를 기반으로 함 |

| 트래픽 관리 | 프록시 구성 | Envoy, HAProxy, Sidecar Pattern | Envoy 사이드카가 데이터 플레인을 구성하며 트래픽 제어 핵심 역할 수행 |

| 네트워크 기술 | 통신 프로토콜 | HTTP/2, gRPC, XDS, eBPF | 고성능, 저지연 통신 및 프록시 -less 메시 구현을 위한 필수 기술 |

| 보안 | 인증/암호화 | mTLS, Citadel, 인증서 자동화 | 서비스 간 제로 트러스트 기반 보안을 위한 통신 암호화 및 인증 체계 |

| 정책 제어 | 정책 관리 | VirtualService, DestinationRule, SMI | 라우팅, 트래픽 분할, 정책 선언을 위한 추상화된 구성 및 표준화 도구 |

| 관찰성 | 모니터링 및 트레이싱 | Prometheus, Grafana, Jaeger, Zipkin | 서비스 메시의 상태 및 요청 흐름을 추적하기 위한 메트릭·로그·트레이싱 시스템 통합 |

| 배포 자동화 | GitOps/IaC | ArgoCD, Helm, Terraform | 선언적 설정과 Git 기반 파이프라인을 통해 안정적이고 반복 가능한 메시 환경 구축 |

| 운영 최적화 | 성능 및 경량화 | Ambient Mode, Sidecarless, CPU 프로파일링 | 리소스 소비를 줄이고 지연 시간을 최소화하는 최신 서비스 메시 실행 방식 |

| 표준화/호환성 | 서비스 메시 인터페이스 | SMI, SPIFFE/SPIRE | 벤더 독립성과 메시 간 이식성 확보, 보안 및 ID 관리를 위한 표준 |

요약 정리

| 구분 | 핵심 요약 내용 |

|---|---|

| 아키텍처 기반 | Service Mesh 는 마이크로서비스 통신 계층을 관리하는 구조로, Kubernetes 위에서 동작함 |

| 핵심 기술 요소 | 사이드카 프록시 (Envoy), HTTP/2 및 gRPC 기반 통신, mTLS 보안, VirtualService 정책 관리 |

| 운영 요구사항 | 관찰성 (메트릭, 트레이싱), GitOps 기반 배포 자동화, 성능 최적화를 위한 경량화 기술 필요 |

| 표준화 고려 사항 | SMI, SPIFFE 등의 표준을 통해 플랫폼 간 호환성과 보안 관리 자동화를 달성 가능 |

용어 정리

| 카테고리 | 용어 | 설명 |

|---|---|---|

| 구성 요소 | Sidecar Proxy | 각 마이크로서비스 옆에 배치되는 프록시 컨테이너 (예: Envoy) 로, 데이터 플레인의 일부로 동작 |

| Control Plane | 정책 관리, 인증 설정, 트래픽 라우팅 정책 등을 중앙에서 관리하는 구성 요소 (예: Istio 의 Istiod) | |

| Data Plane | 실제 애플리케이션 트래픽을 처리하는 레이어로, 사이드카 프록시들이 포함됨 | |

| Ingress Gateway | 외부 요청을 서비스 메시 내부로 라우팅하는 진입 지점 | |

| Egress Gateway | 내부 서비스에서 외부 네트워크로 나가는 트래픽을 제어하는 컴포넌트 | |

| 보안 | mTLS (Mutual TLS) | 서비스 간 암호화된 통신 및 양방향 인증을 제공하는 보안 프로토콜 |

| Zero Trust | 네트워크 내부를 포함한 모든 요청에 대해 검증을 요구하는 보안 모델 | |

| RBAC | 역할 기반 접근 제어. 사용자 또는 서비스 계정별 권한을 정의하여 리소스 접근을 제어 | |

| Citadel | Istio 에서 사용되는 인증서 발급 및 신원 관리 컴포넌트 (현재는 Istiod 에 통합됨) | |

| SPIFFE/SPIRE | 서비스 정체성을 위한 표준 프레임워크 (Secure Production Identity Framework For Everyone) | |

| 아키텍처 | Sidecar Pattern | 프록시나 보안, 로깅 등의 기능을 메인 애플리케이션과 함께 배포하는 디자인 패턴 |

| Ambient Mesh | 사이드카 없이 노드 레벨에서 메시 기능을 수행하는 차세대 서비스 메시 모델 (예: Istio Ambient) | |

| Proxy-less Mesh | eBPF 또는 커널 기술을 활용하여 사이드카 없이 메시 기능을 구현하는 아키텍처 | |

| 배포 전략 | Canary Deployment | 신규 버전을 점진적으로 소수의 사용자에게 먼저 배포하고 점차 확대하는 방식 |

| Traffic Shaping | 트래픽 흐름을 제어하고 특정 조건에 따라 분산하는 기술 (예: 버전별, 사용자별 분리 배포) | |

| Circuit Breaker | 장애 발생 시 외부 호출을 차단하여 연쇄 장애를 방지하는 보호 장치 패턴 | |

| 운영/관찰성 | Distributed Tracing | 마이크로서비스 간 요청 흐름을 추적하여 병목, 장애 원인을 분석 |

| Telemetry | 시스템에서 수집되는 지표, 로그, 트레이스 등 관찰 데이터를 의미 | |

| OpenTelemetry | 표준화된 텔레메트리 수집을 위한 CNCF 프로젝트로, 메트릭·로그·트레이스를 통합 지원 | |

| GitOps | Git 저장소를 단일 신뢰 소스로 사용하여 배포 및 구성을 선언적으로 관리하는 방식 | |

| 표준/기술 | xDS API | Envoy 의 구성을 동적으로 제어하기 위한 API 프로토콜 세트 (Discovery Service 기반) |

| SMI (Service Mesh Interface) | Kubernetes 에서 서비스 메시 구현체 간의 상호 운용성을 위한 표준 인터페이스 |

- Sidecar, Control Plane, Data Plane은 대부분의 서비스 메시 구조에서 공통적으로 사용되는 핵심 용어.

- Ambient Mesh와 Proxy-less Mesh는 최근 등장한 개념으로, 기존 Sidecar 기반 모델의 성능·운영 복잡성 문제를 개선하고자 하는 아키텍처 진화 방향.

- mTLS, Zero Trust, RBAC 등은 서비스 메시 보안 정책 설계의 핵심으로 간주.

- OpenTelemetry는 관찰성 구현에서 de facto 표준이며, Istio, Linkerd, AWS App Mesh 등 다양한 메시에서 지원된다.

참고 및 출처

- Red Hat - What is a service mesh?

- Microsoft Cloud Native Architecture - Service Meshes

- Istio 공식 문서 – What is Istio?

- Linkerd 공식 문서 – What Is a Service Mesh?

- Cilium 공식 사이트 – Service Mesh

- Kong – What is a Service Mesh?

- AWS – What is Service Mesh?

- Tigera – Service Mesh Architecture

- Solo.io – Service Mesh Architecture

- Netflix Tech Blog – Zero‑Configuration Service Mesh

- InfoQ – Envoy Service Mesh 사례

- Google Cloud – Service Mesh 보안 모범 사례

- CNCF – Demystifying Service Mesh

- Red Hat OpenShift Service Mesh (Istio 기반)