프록시 (Proxy)

프록시 (Proxy) 는 클라이언트와 서버 사이의 중계자로 동작하면서 통신 요청을 대신 처리하는 네트워크 컴포넌트다. 클라이언트의 요청을 받아 내부적으로 서버에 재요청하거나, 서버의 응답을 가로채 가공 후 클라이언트에 전달한다. 이를 통해 IP 마스킹, 접근제어, 웹 캐싱, 트래픽 분석 등 다양한 부가가치 기능이 가능하며, 기업환경/개인/서비스 제공자 모두에게 유익한 네트워크 인프라의 핵심 요소로 자리한다. 프록시는 네트워크의 투명성 (Transparency) 또는 비투명성, 규칙 기반 접근 관리 등 다채로운 활용법을 지원한다.

핵심 개념

- **프록시 (Proxy)**는 네트워크의 중간에 위치하여 클라이언트와 서버 간 데이터 송수신을 중계한다.

- 프록시는 요청 (Request) 및 **응답 (Response)**을 자체적으로 가공, 분석, 전달, 필터링, 캐싱, 모니터링 할 수 있다.

- 네트워크 최적화 (캐싱), 보안 강화 (차단, 인증), 로깅 및 모니터링, 익명성 보장, 접근제어 등 다양한 부가 기능이 구현된다.

- 투명 (Transparent) 프록시는 요청이 중계되는 사실이 클라이언트나 서버에 숨겨져 있고, 비투명 (Non-transparent) 프록시는 명시적으로 중계가 이루어진다.

실무 구현을 위한 연관성

- 아키텍처 측면: 마이크로서비스 아키텍처에서 API 게이트웨이 (API Gateway) 역할을 수행하며, 서비스 간 통신을 중재한다.

- 보안 측면: 웹 애플리케이션 방화벽 (WAF, Web Application Firewall) 과 연동하여 멀티 레이어 보안을 구현한다.

- 성능 측면: CDN (Content Delivery Network) 과 연계하여 글로벌 콘텐츠 배포와 캐싱을 최적화한다.

- 운영 측면: 모니터링 시스템과 연동하여 실시간 트래픽 분석과 성능 메트릭을 수집한다.

등장 배경 및 발전 과정

프록시 개념은 1990 년대 초 인터넷의 상용화와 함께 등장했다. 초기에는 네트워크 대역폭 절약과 캐싱을 위해 개발되었으나, 웹 트래픽 증가와 보안 요구사항 강화로 인해 다양한 기능이 추가되었다. 2000 년대 이후 클라우드 컴퓨팅과 마이크로서비스 아키텍처의 확산으로 로드 밸런싱과 서비스 메시 (Service Mesh) 구성 요소로 발전했다.

등장 배경

프록시는 초창기 인터넷 환경에서 접근 제어 및 네트워크 효율화를 위해 등장했다.

- 방화벽 (Firewall) 와 함께 내부망 보호 역할로 도입됨

- 기업 내부에서 외부 인터넷 접속을 통제하기 위한 Forward Proxy 활용이 시작점

발전 흐름

| 시대 | 발전 요소 | 특징 |

|---|---|---|

| 1990s | Forward Proxy | 네트워크 접근 제어, 웹 필터링 |

| 2000s | Reverse Proxy | 웹 서버 보호 및 트래픽 분산 |

| 2010s | CDN, API Gateway 통합 | 캐싱, TLS 종료, 마이크로서비스 API 라우팅 |

| 2020s | 클라우드 기반 Proxy-as-a-Service | Cloudflare, AWS, GCP 통합 프록시 기능 제공 (WAF, LB, DoS 보호 등) |

목적 및 필요성

| 목적 | 설명 |

|---|---|

| 보안 | 클라이언트 혹은 서버 IP 를 숨기고, 접근 통제를 통해 공격을 차단 |

| 캐싱 및 성능 향상 | 자주 요청되는 데이터를 미리 저장하여 응답 속도 개선 |

| 부하 분산 | 트래픽을 여러 백엔드 서버로 분산시켜 가용성과 확장성 확보 |

| 익명성 제공 | 클라이언트 IP 를 은닉하여 사용자의 프라이버시 보호 |

| 정책 제어 | 접근 권한, 요청 속도 제한 등 정책 기반 필터링 가능 |

| 로깅 및 모니터링 | 트래픽 로그 수집, 이상 행위 탐지 등 운영 관리 기능 보완 |

프록시는 단순한 중계 이상의 보안 강화와 성능 최적화, 트래픽 제어 수단으로 진화했다.

주요 기능 및 역할

| 기능 | 역할 |

|---|---|

| 트래픽 중계 | 클라이언트의 요청을 서버에 대신 전달/응답 전송 |

| 보안 필터링 | 악성·유해 트래픽 차단, 바이러스 검사, SSL 검사 등 |

| 캐싱 | 빈번한 콘텐츠의 서버 부담 경감 및 빠른 서비스 제공 |

| 로깅·모니터링 | 트래픽 상세 기록 및 접근/사용 통계 수집, 감사 (Audit) |

| 접근제어 | 사용자, 그룹, 도메인, IP 정책에 따른 접근 허용/차단 |

| 익명성 제공 | 클라이언트 정보 (IP 등) 은닉, 개인정보 보호 |

| 트래픽 규제 | QoS(Quality of Service), 속도 제한 등 네트워크 자원 관리 |

특징

| 특징 | 구현 기반 요소 | 설명 |

|---|---|---|

| 중간자 아키텍처 | 클라이언트와 서버 사이 | 요청/응답을 통제하는 중앙 허브 |

| 양방향 통제 가능 | ingress & egress 처리 | 내부 - 외부 양방향 트래픽 제어 |

| 위치 유연성 | 네트워크 구성에 따라 자유 배치 | 클라이언트 앞, 서버 앞, 라우터 앞 |

| 확장성 | 캐싱, 라우팅, 인증, 보안 기능 확장 가능 | 모듈 기반 기능 구성 가능 (NGINX, Envoy 등) |

| 보안 중심 구성 | TLS, 인증, WAF, Rate Limit 등 지원 | 보안 정책 실현 가능 |

| 클라우드 연동성 | 클라우드 플랫폼과 원활한 연계 | API Gateway, WAF, CDN 역할 통합 가능 |

핵심 원칙

| 원칙 | 설명 |

|---|---|

| 중립성과 투명성 | 요청 내용에 개입하지 않거나 제한적으로만 개입 |

| 정책 기반 필터링 | 접근 제어/캐싱/로드밸런싱은 명시적 규칙 기반 처리 |

| 비지속성 (Stateless) | 대부분의 프록시는 요청별 독립 처리, 상태 유지 최소화 |

| 캐시 일관성 유지 | 응답 TTL, ETag 등 헤더 기반 캐싱 정책 유지 |

| 확장 가능 아키텍처 | 마이크로서비스 환경과의 호환성 및 서비스 확장 고려 |

| 로깅 및 추적 가능성* | 모든 요청/응답은 로그 기반으로 추적 가능해야 함 |

주요 원리 및 작동 방식

클라이언트/사용자 → 프록시 → 서버로 요청이 이동하며, 프록시는 요청/응답을 임의로 가공, 캐싱, 차단, 기록, 대체 등 할 수 있다.

기본 작동 흐름: Forward Proxy

sequenceDiagram

participant Client

participant Proxy

participant Server

Client->>Proxy: 요청 (GET http://example.com)

Proxy->>Server: 요청 전달

Server-->>Proxy: 응답 (HTML, JSON 등)

Proxy-->>Client: 응답 전달

포워드 프록시 작동 흐름

- 클라이언트가 포워드 프록시에 대상 서버로의 요청을 전송한다.

- 프록시는 요청을 검사하고 필터링 규칙을 적용한다.

- 프록시는 필요한 경우 요청을 수정한다 (헤더 추가/변경 등).

- 프록시가 대상 서버에 요청을 전달한다.

- 대상 서버가 프록시에 응답을 전송한다.

- 프록시는 응답을 처리하고 (캐싱, 필터링 등) 클라이언트에게 전달한다.

Reverse Proxy 구조

sequenceDiagram

participant Client

participant ReverseProxy

participant Backend1

participant Backend2

Client->>ReverseProxy: 요청 (/api/data)

alt 경로 기반 라우팅

ReverseProxy->>Backend1: 요청 전달 (/api/data)

else 부하 분산

ReverseProxy->>Backend2: 요청 전달 (/api/data)

end

Backend1-->>ReverseProxy: 응답

ReverseProxy-->>Client: 응답 전달

리버스 프록시 작동 흐름

- 클라이언트가 리버스 프록시 (실제 서버로 인식) 에 요청을 전송한다.

- 리버스 프록시는 요청을 수신하고 필요한 경우 요청을 수정한다.

- 프록시는 라우팅 규칙에 따라 적절한 백엔드 서버를 선택한다.

- 프록시가 선택된 백엔드 서버에 요청을 전달한다.

- 백엔드 서버가 프록시에 응답을 전송한다.

- 프록시는 응답을 처리하고 (캐싱, 헤더 수정 등) 클라이언트에게 전달한다.

구조 및 아키텍처

프록시 서버는 네트워크 트래픽의 중간에서 요청을 받아 적절히 처리하거나 우회하여 접근 제어, 성능 개선, 보안 강화 등을 담당하는 미들웨어 구성 요소이다.

구현 목적에 따라 Forward Proxy, Reverse Proxy, Transparent Proxy 등 다양한 아키텍처로 확장된다.

graph TD

subgraph Forward Proxy 구조

Client1[클라이언트 A]

Client2[클라이언트 B]

ProxyF[Forward Proxy]

Web[외부 웹 서버]

Client1 --> ProxyF --> Web

Client2 --> ProxyF

end

subgraph Reverse Proxy 구조

User[사용자]

ProxyR[Reverse Proxy]

Backend1[서버 A]

Backend2[서버 B]

User --> ProxyR

ProxyR --> Backend1

ProxyR --> Backend2

end

구성 요소

| 구분 | 구성 요소 | 기능 | 역할 | 특징 |

|---|---|---|---|---|

| 필수 | 요청 핸들러 (Request Handler) | 클라이언트 요청 수신 및 해석 | 요청 파싱, 필터 적용 | HTTP/HTTPS, WebSocket 등 프로토콜 지원 |

| 필수 | 라우터 / 포워더 | 목적지 서버로 요청 전달 | 내부/외부 주소 결정 | Forward, Reverse 여부에 따라 동작 방식 차이 |

| 필수 | 응답 핸들러 (Response Handler) | 서버 응답 수신 후 반환 | 캐시 여부 판단, 헤더 수정 | 클라이언트 전달 최적화 수행 |

| 선택 | 캐시 엔진 | 응답 저장 및 재사용 | 반복 요청 응답 시간 단축 | TTL, ETag, Vary 헤더 활용 |

| 선택 | 인증 모듈 | 요청에 대한 인증 및 권한 확인 | 사용자 접근 제어 | API Key, OAuth, IP 인증 등 |

| 선택 | TLS 처리 모듈 | HTTPS 종료 처리 | TLS handshake, 복호화 | 내부 망 평문 처리 가능 |

| 선택 | 로깅 / 모니터링 | 요청/응답 로그 기록 | 추적 및 감사 로그 | JSON, syslog, ELK 등 연계 가능 |

구현 기법 및 방법

| 구현 기법 분류 | 설명 / 구성요소 | 주요 목적 / 기능 | 대표 예시 |

|---|---|---|---|

| NGINX / Apache 기반 정적 프록시 | 설정 파일 기반 Reverse Proxy 구성요청 헤더 재정의, 캐싱, 로드밸런싱 등 지원 | 정적 구성 기반의 요청 중계정적 캐싱, SSL 종료, 단순 부하 분산 | nginx.conf, mod_proxy, OpenResty |

| HAProxy / Envoy 기반 고성능 프록시 | 고성능 L4/L7 지원, 헬스체크 및 TLS 종료, Load Balancing 및 Failover 기능 포함 | 로드밸런싱 + 헬스체크 + TLS 종료고성능 서비스 메시 구성 | HAProxy, Envoy (ex: Istio Sidecar), API Gateway |

| Node.js 기반 커스텀 프록시 | Express + http-proxy-middleware 등 사용필터링, 라우팅, 인증 헤더 등 미세 조정 가능 | 사용자 정의 라우팅 / 인증 / 캐시 정책 적용 | 사용자 정의 JWT 인증 프록시, GraphQL Gateway 등 |

| Cloud 매니지드 프록시 | AWS ELB/ALB, GCP Load Balancer 등 클라우드에서 관리형 제공 | TLS 종료, Auto Scaling, 지리적 라우팅 | AWS ALB, GCP HTTP(S) Load Balancer |

| WAF 기반 보안 프록시 | Web Application Firewall 기능 내장 + Reverse Proxy 구성 | OWASP Top10 대응웹 공격 차단 및 인증 정책 통제 | Cloudflare, AWS WAF, Akamai Kona 등 |

| SOCKS / 투명 / 인증 프록시 | L3~L5 기반 트래픽 중계 / 네트워크 레벨 IP 우회 / 사용자 인증 조합 | VPN, 애플리케이션 트래픽 우회, 보안 접속 제어 | Shadowsocks, Squid Proxy, NTLM 인증 프록시 등 |

| 캐싱 프록시 | 요청 결과를 저장하여 반복 요청시 캐시 응답 TTL, 조건부 요청 설정 포함 | 응답 속도 향상, 대역폭 절감, 백엔드 부하 감소 | Varnish Cache, NGINX 캐시, Squid Proxy |

NGINX vs HAProxy:

- NGINX: 정적 설정, 정적 캐시/압축 최적, 설정 간단

- HAProxy: 고성능 동시 처리, 헬스체크, TCP/HTTP 지원 우수

Node.js 기반 커스텀 프록시:

- 미세 제어 가능하지만 성능은 대형 트래픽 환경에서 불리함

- GraphQL, 인증 기반 미들웨어 등에 적합

Cloud 프록시:

- 설정은 간단하지만 복잡한 커스터마이징엔 한계

- 멀티리전, 자동 확장 필요 시 유리함

Nginx 기반 구현 예시

| |

HAProxy 기반 구현 예시

| |

Node.js 기반 간단한 프록시 예시시

| |

장점

| 카테고리 | 항목 | 설명 |

|---|---|---|

| 보안 및 프라이버시 | 클라이언트/서버 IP 은닉 | 클라이언트 또는 서버의 실제 IP 노출을 방지하여 익명성과 보안 향상 |

| 직접 연결 차단 | 외부 요청자가 백엔드와 직접 통신하지 못하도록 방지하여 공격면 최소화 | |

| 악성 요청 필터링 | 악성 트래픽, 봇 요청, 비정상 트래픽 탐지 및 차단 가능 | |

| TLS 종료 (SSL 오프로드) | 프록시에서 HTTPS 처리 수행 → 백엔드는 HTTP 처리만으로 단순화 및 리소스 절감 | |

| 네트워크 최적화 | 캐싱 기능 | 정적 리소스 캐싱으로 응답 시간 단축 및 대역폭 절감 |

| 중복 제거/압축 최적화 | 중복된 데이터 제거 또는 콘텐츠 압축으로 네트워크 부하 감소 | |

| 트래픽 분산 및 확장성 | 로드 밸런싱 기능 | 다수의 백엔드 서버로 요청을 분산하여 부하를 고르게 분산 |

| 서비스 무중단 운영 | 트래픽 라우팅 조정으로 서비스 중단 없이 배포 (Blue-Green, Canary 등) 가능 | |

| 시스템 확장성 | 다양한 환경 및 구성에 대응 가능한 유연한 아키텍처 확장 기반 제공 | |

| 정책 및 운영 관리 | 접근 제어/정책 적용 | IP 기반 제한, 헤더 기반 인증 등 세부 네트워크 정책 적용 가능 |

| 로깅 및 가시성 | 모든 요청/응답 트래픽을 로깅하여 추적성 확보 및 이상 탐지 가능 | |

| 중앙 집중형 제어 | 단일 진입점에서 모든 요청을 제어·감시하여 운영 단순화 및 정책 일관성 유지 | |

| 운영 최적화 및 성능 | 성능 향상 | 캐싱 및 최적화를 통해 서버 응답 속도와 전체 시스템 성능 향상 |

| 백엔드 경량화 | 인증·암호화·필터링 등의 작업을 프록시에서 분산 처리하여 백엔드 부담 최소화 | |

| 콘텐츠 최적화 | 이미지 리사이징, 압축, 리디렉션 등 콘텐츠 전달 최적화 기능 내장 가능 |

단점과 문제점 그리고 해결방안

단점

| 구분 | 항목 | 설명 | 대표 해결책 |

|---|---|---|---|

| 성능 이슈 | 병목 발생 / 레이턴시 증가 | 모든 트래픽이 프록시를 경유하므로 네트워크 지연 및 SPOF 우려 발생 | 클러스터 구성, 로드 밸런싱, Keep-Alive, 연결 풀링 |

| TLS 복호화 오버헤드 | HTTPS 트래픽 처리 시 CPU 리소스 사용량 증가 | SSL Termination 전용 인스턴스 분리, 하드웨어 가속기 (HSM 등) | |

| 운영 이슈 | 설정 및 관리 복잡성 | 인증, 라우팅, 캐싱, 로깅 등 구성 요소의 증가로 복잡한 설정 관리 필요 | IaC(Terraform/Ansible), 중앙 통합 설정 관리, 문서화 |

| 로그 저장 및 분석 비용 | 모든 트래픽 기록 시 대용량 로그 생성 → 저장소/처리 비용 증가 | 로그 압축, Fluentd + ELK/Loki 연동, 로그 보존 주기 조정 | |

| 프라이버시/감사 위험 | 모든 요청·응답을 중계하면서 민감 정보가 로그에 포함될 수 있음 | 데이터 마스킹, 접근 제어, 민감 로그 필터링 정책 적용 | |

| 신뢰성 이슈 | 장애 전파 위험 (SPOF) | 프록시 서버 자체 장애 발생 시 전체 서비스 접근 차단 가능성 | 이중화 구성 (Active-Active or Passive), 헬스 체크 + 자동 Failover |

문제점

| 구분 | 항목 | 원인 | 영향 | 탐지/진단 방법 | 예방/해결 방법 |

|---|---|---|---|---|---|

| 캐시 관련 | 캐시 일관성 / 무효화 실패 | TTL 만료 실패, ETag 미지원, 데이터 갱신 알림 없음 | 잘못된 응답 제공, 사용자 혼란 | Cache Hit Ratio, ETag 일치 확인 | 동적 TTL, 캐시 퍼지 (Purge), Soft/Hard Refresh 적용 |

| 세션 관리 | 세션 친화성 문제 | 로드 밸런싱 시 세션 정보가 서버 간 공유되지 않음 | 로그인 풀림, 트랜잭션 중단 | 세션 추적, 요청 로그 분석 | Sticky Session, JWT 토큰, 외부 세션 저장소 (Redis 등) |

| 보안 이슈 | 인증 우회 | 프록시 계층에서 인증 누락, 백엔드 직접 접근 가능 | 비인가 접근, 보안 정책 우회 | API 접근 로그, 방화벽 로그 분석 | 요청별 ACL, 인증 필터 삽입, Zero Trust Routing 적용 |

| 내부 정보 노출 | 응답에 내부 IP/경로 노출, 로그에 민감 데이터 포함 | 보안 위협, 시스템 정보 노출 | 응답 헤더, 로그 감사 | 마스킹, 보안 헤더 삽입, 로그 필터 적용 | |

| SSL 종료 후 평문 통신 | 프록시~백엔드 간 TLS 미적용 | 패킷 스니핑 통한 정보 유출 | 네트워크 스니퍼, 트래픽 검사 | TLS end-to-end, VPN 터널링, Mutual TLS | |

| 가용성 이슈 | 부하 집중 / 단일 인스턴스 구성 | 확장 불가한 단일 프록시 구성 | 리소스 고갈, 전체 서비스 중단 | CPU, 메모리, QPS 모니터링 | Auto Scaling, Horizontal Proxy Pool + Load Balancer 도입 |

| TLS 인증서 오류 | 인증서 만료, 미연장, 호스트 불일치 | HTTPS 접속 실패 | TLS 핸드셰이크 실패 로그 분석 | 인증서 자동 갱신 (Certbot, AWS ACM), 모니터링 | |

| 프록시 우회 시도 | 고급 사용자가 다른 경로를 통해 접근 시도 | 정책 우회, 추적 회피 | DPI(Deep Packet Inspection), IP 검증 | 보안 룰 강화, User-Agent/IP 필터, 접근 제어 정책 강화 |

도전 과제

| 카테고리 | 도전 과제 | 설명 및 원인 | 영향 | 해결 전략 / 기술 |

|---|---|---|---|---|

| 보안 및 프라이버시 | 고도화된 공격 대응 | Bot, 우회, 제로데이, DDoS 등 신종 공격 패턴 지속 등장 | 보안 침해, 데이터 유출 | AI 기반 이상 탐지, WAF 연계, Threat Intelligence, 제로트러스트 설계 |

| TLS 처리의 민감 데이터 노출 | 프록시에서 TLS 해제를 수행할 경우 사용자 데이터가 일시적으로 평문 상태로 존재함 | 개인정보 유출 가능성 | TLS 재암호화 (Re-encryption), TLS passthrough, End-to-End 암호화 적용 | |

| 로깅 시 민감 정보 노출 | Access Log / Error Log 에 IP, 토큰, 세션정보 등 포함 | 프라이버시 침해, 컴플라이언스 위반 | 로그 필터링, 마스킹, 익명화, GDPR/CCPA 대응 로깅 체계 구축 | |

| 스케일링 및 가용성 | 트래픽 급증 시 스케일링 한계 | 정해진 인스턴스 수 또는 고정 구성의 프록시 인프라가 트래픽을 초과하지 못함 | 응답 지연, 장애 유발 | Auto Scaling, Horizontal Scaling, Micro Proxy 분산 구성 |

| 단일 장애점 (SPOF) | 단일 프록시 노드 장애 시 전체 시스템 중단 가능성 존재 | 전체 서비스 불가 | 이중화 (Active-Active), Load Balancer 연동, HA 구성 | |

| 실시간 확장 시 불안정성 | DNS, 서비스 디스커버리, Health Check 등 실시간 라우팅에 지연 발생 | 트래픽 유실, 라우팅 오류 | 서비스 디스커버리 자동화, DNS TTL 조절, 프록시 인스턴스 상태 기반 동적 등록 | |

| 성능 및 최적화 | TLS 오버헤드 및 암호화 부하 | HTTPS 요청 증가로 인한 CPU 사용률 급증, 대역폭 증가 | 응답 지연, 시스템 과부하 | 하드웨어 TLS 오프로드, SSL Termination Proxy, Keep-Alive 최적화 |

| 캐싱 효율 저하 | 콘텐츠 다양성 증가, 캐시 미스 증가, 복잡한 캐싱 정책 미비 | CDN 또는 Proxy 성능 저하 | 지능형 캐싱 정책, 엣지 캐시 활용, 콘텐츠 분류별 TTL 세분화 | |

| 복합 트래픽의 처리 부하 | 이미지/비디오, API 등 다양한 요청 유형에 대한 최적화 처리 미흡 | 처리 시간 지연, UX 저하 | 콘텐츠 유형별 프록시 분리, MIME 기반 라우팅, 정적/동적 구분 최적화 | |

| 인증 및 정책 관리 | 경로 기반 인증 누락 | API 경로별 인증 정책이 미비하거나 공통 인증 로직으로 인해 예외 경로 발생 | 우회 접근 가능, 보안 사각지대 발생 | RBAC, 정책 기반 접근 제어 (PBAC), 경로 단위 인증 적용 |

| 복잡한 정책 자동화의 어려움 | 다중 인증 방식 (OAuth2, API Key 등), 정책 갱신 지연, 수동 배포로 인한 오류 | 보안 정책 불일치, 운영 지연 | 정책 템플릿화, GitOps 기반 실시간 정책 배포, 정책 엔진 자동화 (OPA 등) | |

| 운영 및 관측성 | 로그 폭증 및 분석 난이도 | 고속 트래픽에서 로그가 폭발적으로 생성되며, 실시간 분석 체계 미흡 시 이상 탐지 실패 | 인시던트 대응 지연, 보안 이벤트 누락 | 로그 집계 (ELK, Loki), 분산 트레이싱 (OpenTelemetry), 로그 레벨 조정 |

| 장애 탐지 및 대응 자동화 부족 | 장애가 발생해도 수작업 대응으로 시간 지연 발생 | SLA 하락, 고객 불만 | 헬스체크 강화, 자동 Failover, 지표 기반 Alerting 시스템 구축 |

분류 기준에 따른 종류 및 유형

| 분류 기준 | 유형 | 설명 | 대표 사용 사례 |

|---|---|---|---|

| 동작 방향 | Forward Proxy | 내부 클라이언트 → 외부 서버 요청 중계. 클라이언트 IP 은닉 등 목적 | 기업 내부망 → 인터넷 접근 제어, 방화벽, 콘텐츠 필터링 |

| Reverse Proxy | 외부 요청을 내부 서버로 라우팅. 서버 보호 및 부하 분산, SSL 종료 | 로드 밸런서, API Gateway, NGINX, Envoy | |

| 위치 | 클라이언트 측 프록시 (Forward) | 사용자 네트워크 경계에 위치 | 가정용/기업용 프록시, 학교 검열 시스템 |

| 서버 측 프록시 (Reverse) | 백엔드 앞단에 위치, 트래픽을 내부 서버에 전달 | CDN, 로드밸런서, 보안 게이트웨이 | |

| 투명성 | Transparent Proxy | 사용자에게 노출되지 않고 중간에서 트래픽 가로채기 | ISP 네트워크 최적화, 감시, 로깅 |

| Explicit Proxy | 사용자가 명시적으로 설정한 프록시 (비투명) | 브라우저 설정, 사내 보안 정책 적용 | |

| Anonymous Proxy | 사용자 IP 은닉, 클라이언트 정보 제거 | 익명성 보장 브라우징, 프라이버시 보호 | |

| 프로토콜 | HTTP/HTTPS Proxy | HTTP(S) 기반 웹 트래픽 처리. 요청 헤더 조작/캐싱 등 가능 | 웹 서버, API Gateway, 브라우저 설정 등 |

| SOCKS Proxy | TCP/UDP 포함 다양한 트래픽 전송. 애플리케이션 계층을 해석하지 않음 | P2P, 게임, VPN 기반 우회, 범용 트래픽 라우팅 | |

| FTP Proxy | FTP 트래픽 프록시 중계 (파일 다운로드/업로드) | 기업용 파일 서버, 외부 파일 접근 통제 | |

| 기능 목적 | Caching Proxy | 응답을 저장해 재사용. 정적 리소스 캐싱 및 네트워크 비용 절감 | CDN, 웹 가속, 정적 이미지/JS/CSS 캐싱 |

| Load Balancing Proxy | 요청을 여러 서버에 분산 처리 | HAProxy, Envoy, NGINX 등 | |

| Security Proxy (WAF) | 웹 공격 탐지/차단 (SQLi, XSS, CSRF 등) | Cloudflare, AWS WAF, Akamai | |

| Authentication Proxy | 사용자 인증 후 트래픽 중계 | SSO, OAuth 프록시, 기업 내부 리소스 보호 | |

| Filtering Proxy | URL/콘텐츠 차단, 광고 제거 등 필터링 기능 포함 | 유해 사이트 차단, 광고 제거 프록시, 부모 통제 프록시 | |

| Logging/Monitoring Proxy | 요청/응답 전송을 기록하거나 트래픽 패턴 분석 | 감시, 트래픽 분석, 보안 로그 수집 | |

| 배포 방식 | 온프레미스 프록시 | 직접 서버에 구축하여 운영 | 학교/기업 내부망, 자체 구축 프록시 서버 |

| 클라우드 매니지드 프록시 | AWS, GCP 등에서 제공하는 관리형 프록시 서비스 | AWS ELB, Cloudflare, API Gateway | |

| 하이브리드 프록시 | 온프레미스 + 클라우드 혼합 구성 | 멀티리전 고가용성 구성, VPN + CDN 결합 구성 |

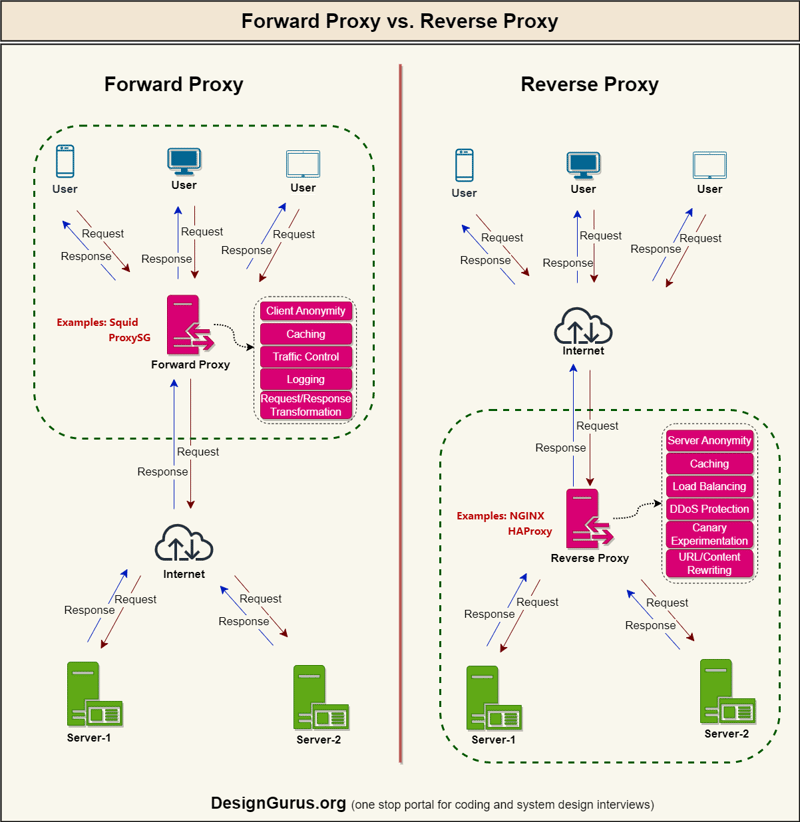

Reverse Proxy vs. Forward-Proxy

프록시 서버는 클라이언트와 서버 간의 중개자 역할을 하는 서버로, 네트워크 아키텍처에서 중요한 구성 요소이다.

프록시 서버는 크게 포워드 프록시 (Forward Proxy) 와 리버스 프록시 (Reverse Proxy) 로 구분된다.

리버스 프록시와 포워드 프록시는 모두 클라이언트 - 서버 간 통신에서 중개자 역할을 수행하지만, 목적과 적용 영역에서 근본적인 차이가 있다.

포워드 프록시 (Forward Proxy) 는 주로 클라이언트를 보호하고 대신하여 요청을 처리하는 반면, 리버스 프록시 (Reverse Proxy) 는 서버를 보호하고 서버 앞에서 요청을 처리한다. 두 유형은 배치 위치, 주요 목적, 작동 방식, 보안 관점, 가시성 등에서 근본적인 차이가 있지만, 공통적으로 중개자 역할을 한다는 특성을 공유한다.

기본 구조 및 동작 비교

| 항목 | Forward Proxy (포워드 프록시) | Reverse Proxy (리버스 프록시) |

|---|---|---|

| 위치 | 클라이언트 측 | 서버 측 (백엔드 앞단) |

| 트래픽 방향 | 아웃바운드 (Outbound) | 인바운드 (Inbound) |

| 요청 흐름 | 클라이언트 → 프록시 → 인터넷 서버 | 클라이언트 → 프록시 → 백엔드 서버 |

| 클라이언트 인식 | 프록시 존재 인식 (명시적 설정 또는 투명 모드) | 프록시를 실제 서버로 인식 (완전 투명) |

| 서버 인식 | 클라이언트가 아닌 프록시로부터 요청을 수신 | 클라이언트 요청처럼 수신됨 |

graph LR A[Client] -->|"① 요청"| B[Forward Proxy] B -->|"② 전달"| C[외부 서버] C -->|"③ 응답"| B B -->|"④ 전달"| A D[Client] -->|"❶ 요청"| E[Reverse Proxy] E -->|"❷ 분배"| F[내부 서버1] E -->|"❷ 분배"| G[내부 서버2] G -->|"❸ 응답"| E F -->|"❸ 응답"| E E -->|"❹ 전달"| D

주요 목적 및 기능

| 항목 | Forward Proxy | Reverse Proxy |

|---|---|---|

| 주요 목적 | 클라이언트 보호, 콘텐츠 필터링, 익명성, 지역 우회 | 서버 보호, 로드밸런싱, 보안 게이트웨이, 성능 최적화 |

| 대표 기능 | 콘텐츠 필터링, 액세스 제어, IP 익명화, 캐싱, 사용자 인증 | 로드밸런싱, SSL 종료, 캐싱, 압축, WAF, URL 재작성, A/B 테스트 |

| 캐싱 대상 | 클라이언트 요청에 대한 외부 응답 | 서버 응답 (정적 콘텐츠/API 등) |

| 콘텐츠 필터링 | 키워드, 도메인, URL 기반 | 제한적 (일반적으로 수행하지 않음) |

| 로드 밸런싱 | 없음 | 있음 (가중치, Round Robin, Least Connection 등) |

| API 게이트웨이 역할 | 없음 | 있음 (경로 기반 라우팅, 인증/권한 제어, 속도 제한 등) |

보안 및 프라이버시

| 항목 | Forward Proxy | Reverse Proxy |

|---|---|---|

| 보안 초점 | 클라이언트 보호 및 접근 제어 | 백엔드 보호, DDoS 방어, SSL 처리, 인증 계층 통합 |

| SSL 처리 방식 | 클라이언트 ↔ 프록시 간 SSL 처리 | 클라이언트 ↔ 프록시 ↔ 서버, SSL 종료 후 백엔드와 HTTP 통신 가능 |

| 인증 방식 | 사용자 인증 중심 | 백엔드 인증 통합 관리, OAuth, SSO 연계 가능 |

| 로그 수집 | 사용자 요청/접근 기록 중심 | 서버 성능, 요청 추적, 에러 모니터링 중심 |

| 프라이버시 보호 | IP 숨김, DNS 프록싱, 위치 위장 가능 | 백엔드 서버 IP 은닉화, 공격 경로 은폐 |

프로토콜 및 확장성

| 항목 | Forward Proxy | Reverse Proxy |

|---|---|---|

| 지원 프로토콜 | HTTP, HTTPS, SOCKS5, FTP, SMTP 등 | HTTP, HTTPS, WebSocket, TCP/UDP, gRPC 등 |

| 확장성 구조 | 계층형, 수직 확장 중심 | 수평 확장 용이 (Auto Scaling, Load Balancer 와 결합) |

| 클라우드 적합성 | 중간 (전통적 환경 중심) | 높음 (클라우드 네이티브 환경에 최적화) |

| 설정 난이도 | 클라이언트 설정 필요 (배포 및 자동화 어려움) | 서버 측 설정, 클라이언트 무관, 구성 관리 편리 |

성능 및 자원 최적화

| 항목 | Forward Proxy | Reverse Proxy |

|---|---|---|

| 성능 최적화 방식 | 클라이언트 캐싱, 대역폭 절감, 콘텐츠 압축 | 캐싱, 압축, Keep-Alive, 연결 풀링, 콘텐츠 전송 최적화 |

| 주요 성능 요소 | 네트워크 대역폭, 캐시 크기, 연결 수 | SSL 처리 성능, 이벤트 기반 비동기 처리, 지연 시간 최소화 |

| 장애 시 영향 | 인터넷 접근 불가 (대체 경로 가능 시 우회 가능) | 백엔드 전체 장애 발생 가능성 (HA 구성으로 완화 필요) |

실무 적용 환경

| 항목 | Forward Proxy 적용 사례 | Reverse Proxy 적용 사례 |

|---|---|---|

| 기업 환경 | 내부 네트워크 제어, 정책 기반 웹 접근 통제 | 로드밸런서, 인증 프록시, 백엔드 보호, 웹 방화벽 |

| 교육 기관 | 학생 인터넷 제한, 콘텐츠 차단 | API 집약 서비스, 공통 인증 프레임워크 적용 |

| 클라우드 환경 | 보안 접근 경로, 프라이버시 보호용 게이트웨이 구성 | 멀티 리전 라우팅, 글로벌 서비스 CDN 연동 |

| 개인 사용자 | VPN, Tor, 지역 우회, 광고 차단 | 없음 (주로 서비스 제공자 측에서 사용) |

구현체 및 기술 스택

| 구분 | 포워드 프록시 구현체 | 리버스 프록시 구현체 |

|---|---|---|

| 오픈소스 | Squid, Apache Traffic Server, Privoxy, mitmproxy | NGINX, HAProxy, Traefik, Envoy |

| 클라우드 서비스 | Zscaler, Cisco Umbrella, Cloudflare Gateway, AWS VPC 엔드포인트 | AWS ALB, Google Cloud LB, Azure App Gateway, Cloudflare, Akamai |

설계 및 운영 고려사항

| 항목 | Forward Proxy | Reverse Proxy |

|---|---|---|

| 설계 고려사항 | 사용자 구성 관리, HTTPS 처리, 정책 관리, 로그 보관, 자동화 도전 | 로드밸런싱 정책, SSL 인증서 관리, 고가용성 설계, 서비스 디스커버리 적용 |

| 운영 리스크 | 우회 시도, 인증서 유효성 오류, 네트워크 병목 | 단일 장애점 (SPOF), 설정 오류에 따른 전체 서비스 장애 가능성 |

| 규정 대응 | GDPR 등 개인정보 보호 규정 적용 필요 | 클라이언트 데이터 보호, 서버 보안 정책 준수 필요 |

배포 시나리오 비교

포워드 프록시 배포 시나리오

1. 기업 네트워크 경계

| |

- 모든 아웃바운드 트래픽 제어

- 웹 필터링 및 콘텐츠 검사

- 인터넷 사용 모니터링

2. 계층형 프록시 구조

| |

- 대규모 조직에 적합

- 부서별 정책 적용 가능

- 캐시 계층화로 성능 향상

3. 투명 프록시 배포

| |

- 클라이언트 구성 불필요

- 네트워크 장비와 통합 (라우터, 스위치)

- 우회 가능성 낮음

리버스 프록시 배포 시나리오

1. 웹 서버 최전방

| |

- 백엔드 서버 보호

- SSL 종료 및 콘텐츠 캐싱

- 정적/동적 콘텐츠 분리

2. 마이크로서비스 API 게이트웨이

| |

- 중앙화된 인증 및 권한 부여

- 버전 관리 및 라우팅

- 속도 제한 및 모니터링

3. 다중 계층 프록시 아키텍처

| |

- 글로벌 배포

- 계층별 전문화된 기능

- 멀티 리전 고가용성

구성 예시

포워드 프록시 구성 예시 (Squid)

| |

리버스 프록시 구성 예시 (Nginx)

| |

실무 사용 예시

| 역할 카테고리 | 대표 목적 | 주요 활용 기술 | 기대 효과 / 설명 |

|---|---|---|---|

| 트래픽 분산 및 확장성 | 로드 밸런싱, 고가용성 | NGINX, HAProxy, AWS ALB, GeoDNS, Reverse Proxy | 서버 간 트래픽 분산, 이중화, 지역 기반 트래픽 분배로 서비스 안정성 및 확장성 확보 |

| 콘텐츠 최적화 및 캐싱 | 정적 콘텐츠 캐싱, 응답 속도 향상 | CDN (CloudFront, Cloudflare), Cache Layer, Reverse Proxy | 캐싱을 통한 응답 지연 최소화, 이미지/파일 등 정적 콘텐츠 배포 최적화 |

| 보안 및 접근 제어 | 외부 공격 방어, 내부 접근 통제 | WAF, TLS Termination, ACL, SSO, IDS/IPS, VPN, 인증 서버 | OWASP Top 10 방어, 암호화 처리 (TLS), 사용자 인증 및 권한 관리 |

| 마이크로서비스 통신 관리 | 서비스 간 API 라우팅, 인증 처리 | API Gateway(Kong, Envoy, Istio), JWT, Rate Limiter, Service Mesh | 각 서비스 경로별 인증 및 요청 분산, 서비스 디스커버리 및 정책 중심 통신 제어 |

| 네트워크 정책 및 로깅 | 트래픽 필터링, 모니터링, 감사 | Squid, BlueCoat, Zscaler, Proxy ACL, 로그 서버 | 사용자 요청 제어, 로그 수집, 내부 보안 정책 시행 및 감사 대응 |

| 인프라 운영 자동화 및 최적화 | 설정 자동화, 커넥션 최적화 | Ansible, NGINX Config, Consul, ProxySQL, MaxScale | 프록시 구성 자동화, 데이터베이스 커넥션 풀링, 환경별 설정 분리 운영 |

활용 사례

사례 1: 마이크로서비스 기반의 웹 플랫폼

시나리오: 마이크로서비스 기반의 웹 플랫폼에서 모든 클라이언트 요청을 Reverse Proxy 를 통해 인증, 라우팅, 캐싱하고 백엔드 서비스와 연결한다.

시스템 구성:

- 클라이언트는 단일 Entry Point(프록시) 로 요청

- 프록시는 요청 인증 및 라우팅 처리

- API 는 독립된 마이크로서비스로 동작

- Redis 를 통해 응답 캐싱

graph TD

Client[사용자]

Proxy["Reverse Proxy (NGINX)"]

Auth[인증 서비스]

API1[주문 API]

API2[결제 API]

Redis[캐시 서버]

Client --> Proxy

Proxy --> Auth

Proxy --> Redis

Proxy --> API1

Proxy --> API2

API1 --> Redis

API2 --> Redis

Workflow:

- 클라이언트 요청을 프록시가 수신

- 인증 토큰 확인 후

/api/order요청은 API1 으로 라우팅 /api/pay요청은 API2 로 라우팅- 응답은 Redis 에 캐싱

- 캐시된 응답은 재요청 시 프록시에서 직접 반환

역할:

- Reverse Proxy: 요청 라우팅 및 인증 연계

- Auth 서비스: 인증 토큰 검증

- Redis: 응답 캐싱

- Backend API: 비즈니스 로직 처리

유무에 따른 차이점:

| 항목 | 프록시 미사용 시 | 프록시 사용 시 |

|---|---|---|

| 인증 분리 | 각 API 별 인증 처리 필요 | 프록시에서 일괄 처리 가능 |

| 확장성 | API 직접 접근 | 요청 추상화 및 분산 처리 가능 |

| 보안 | 백엔드 노출 | IP 숨김, TLS 종료 및 보호 |

| 성능 | 캐시 없음, 서버 부담 ↑ | 응답 캐싱 가능, 서버 부하 ↓ |

구현 예시: Node.js + Express + http-proxy-middleware

| |

사례 2: 기업의 프록시 서버

시나리오: 기업 내부 사용자가 인터넷에 접근할 때 기업의 프록시 서버를 반드시 거쳐 익명성, 보안, 트래픽 최적화, 접근제어를 동시에 실현

시스템 구성:

- 사내 클라이언트

- 내부 네트워크 방화벽

- 프록시 서버 (정책, 캐싱, 인증, 로깅 모듈)

- 외부 인터넷 서버

graph TD

User[사내 사용자 / Client] --> Firewall[내부방화벽 / Firewall]

Firewall --> ProxyServer[프록시 서버]

ProxyServer --> Internet[외부 인터넷 서버]

ProxyServer -- 캐싱/정책/로깅/인증 --> ProxyModules

Workflow:

- 사용자가 웹사이트 접근 요청

- 방화벽에서 허용된 트래픽만 프록시로 이동

- 프록시 서버가 접근제어, 캐싱, 필터링, 로깅, 익명성 정책 적용

- 외부 요청 중계, 서버 응답도 정책 반영 후 사용자에 전달

역할:

- 프록시: 모든 네트워크 정책 집행, 보안, 성능 향상, 접근제어 총괄

유무에 따른 차이점:

- 프록시 없이: 직접 인터넷 연결, 익명성/보안 부재, 로깅 미흡, 트래픽 비효율

- 프록시 활용: 체계적 정책/보안/캐싱/로깅 가능, 내부 정보 은닉

구현 예시: Python, HTTP 프록시

| |

사례 3: 전자상거래 플랫폼의 고가용성 웹 서비스 구축

시나리오: 대규모 전자상거래 플랫폼의 고가용성 웹 서비스 구축

시스템 구성:

- 프론트엔드: React 기반 SPA (Single Page Application)

- 리버스 프록시: Nginx (로드 밸런서 및 SSL 종료)

- 백엔드 서버: Node.js 애플리케이션 서버 3 대

- 데이터베이스: MySQL 클러스터

- 캐시: Redis 클러스터

graph TB

subgraph "클라이언트"

Browser[웹 브라우저]

Mobile[모바일 앱]

end

subgraph "CDN 계층"

CDN[CloudFlare CDN]

end

subgraph "로드 밸런서 계층"

LB[Nginx 리버스 프록시]

end

subgraph "애플리케이션 계층"

App1[Node.js 서버 1]

App2[Node.js 서버 2]

App3[Node.js 서버 3]

end

subgraph "캐시 계층"

Redis[(Redis 클러스터)]

end

subgraph "데이터베이스 계층"

Master[(MySQL Master)]

Slave1[(MySQL Slave 1)]

Slave2[(MySQL Slave 2)]

end

Browser --> CDN

Mobile --> CDN

CDN --> LB

LB --> App1

LB --> App2

LB --> App3

App1 --> Redis

App2 --> Redis

App3 --> Redis

App1 --> Master

App2 --> Slave1

App3 --> Slave2

Workflow:

- 클라이언트 요청이 CDN 을 통해 정적 콘텐츠는 즉시 제공

- 동적 요청은 Nginx 리버스 프록시로 전달

- SSL 종료 및 요청 분석 후 헬스한 백엔드 서버로 라우팅

- 애플리케이션 서버에서 Redis 캐시 확인 후 처리

- 필요시 데이터베이스 조회 및 응답 반환

역할:

- CDN: 정적 자산 캐싱 및 글로벌 배포

- Nginx 프록시: SSL 종료, 로드 밸런싱, 압축, 보안 헤더 추가

- 애플리케이션 서버: 비즈니스 로직 처리

- Redis: 세션 및 데이터 캐싱

- MySQL: 영구 데이터 저장

유무에 따른 차이점:

- 프록시 있음: 단일 진입점, 로드 분산, SSL 중앙 관리, 캐싱 최적화

- 프록시 없음: 각 서버 개별 접근, 불균등한 부하, 복잡한 SSL 관리, 캐싱 비효율

구현 예시:

| |

실무에서 효과적으로 적용하기 위한 고려사항 및 주의할 점

| 카테고리 | 세부 항목 | 설명 및 주의사항 | 권장사항 |

|---|---|---|---|

| 1. 정책 및 인증 관리 | 인증/인가 처리 | 사용자 인증 없이 우회하거나 우발적인 접근 가능성 존재 | 프록시 레벨에서 JWT, OAuth 등 토큰 기반 인증 적용 |

| 중앙 정책 일관성 | 각 서버/프록시 간 접근 정책 불일치 시 보안 구멍 발생 가능 | 중앙 관리형 정책 서버 연동 (ex. OPA, AD 연계) | |

| 사용자 인증 관리 | 클라이언트별 접근 제어 및 계정 권한 확인 필요 | 인증서 기반 접근 + 그룹별 정책 적용 | |

| 2. 캐시 및 콘텐츠 처리 | 캐시 TTL 전략 | TTL 미흡 시 콘텐츠 최신성·효율성 문제 | 콘텐츠 유형별 TTL 분리 설정 (정적 vs 동적) |

| 캐시 무효화 (Invalidation) | 변경된 콘텐츠가 캐시에 남아 있는 경우 발생 | 정책 기반 TTL 조정 또는 수동 무효화 API 연동 | |

| 캐시 업데이트 자동화 | 수동 캐시 갱신 시 운영 리스크 증가 | 동적 캐시 갱신 조건 설정 (If-Modified-Since, ETag 등) | |

| 3. 보안 관리 | SSL/TLS 인증서 관리 | 인증서 만료 시 서비스 중단 위험 존재 | 자동 갱신 도구 사용 (ex. certbot, cert-manager) |

| 로그 필터링 및 보안 | 민감 정보 (IP, 토큰 등) 노출 시 정보 유출 위험 | 로그 마스킹 또는 민감 필드 제거, GDPR 등 규정 준수 | |

| 취약점 대응 및 패치 | 오픈소스 기반 프록시 사용 시 보안 패치 누락 우려 | NGINX, HAProxy 등 최신 버전 유지 및 CVE 대응 | |

| 4. 가용성 및 장애 대응 | 단일 실패점 방지 (SPOF) | 프록시 서버 다운 시 전체 서비스 중단 가능 | 다중 인스턴스 구성 + Failover/Health Check 설정 |

| 장애 복구 및 롤백 전략 | 설정 오류, 배포 실패 시 서비스 영향 최소화 | 구성 롤백 시나리오 작성 및 자동화 적용 | |

| 5. 성능 및 트래픽 대응 | 트래픽 증가 대응 | 고트래픽 상황에서 프록시 병목 발생 가능 | 오토스케일링 적용 및 버퍼 관리 정책 강화 |

| 리소스 최적화 | CPU, 메모리, 네트워크 대역폭 최적 관리 필요 | Keep-Alive, gzip 압축, Connection Pool 등 최적화 적용 | |

| 응답 시간 및 처리량 모니터링 | 지연이나 처리량 한계 도달 시 실시간 탐지 필요 | 대시보드 및 Alerting 구성 (ex. Grafana + Prometheus) | |

| 6. 로그 및 운영 관리 | 로그 수집 및 분석 | 장애, 성능 이슈, 보안 위협 분석을 위한 로그 활용 | 중앙 로그 수집 시스템 구성 (ELK, Loki 등) |

| 감사 및 감사 추적 | 사용자 및 운영자 행위에 대한 추적 로그 필요 | 접근 제어 로그, 인증 로그, 변경 이력 추적 저장 | |

| 구성 자동화 및 템플릿화 | 수동 설정 시 실수/누락 발생 가능 | IaC 기반 구성 관리 (Terraform, Helm 등) | |

| 7. 확장성 및 지속 운영 | 클러스터링 및 스케일링 | 고가용성 및 트래픽 증가 대비 확장성 필요 | 수평 확장 가능한 구조 설계 (로드밸런서 연동) |

| 멀티 지역 운영 | 글로벌 사용자 대상 프록시 적용 시 지역별 Latency 이슈 발생 가능 | Anycast 기반 분산 또는 GeoDNS 기반 라우팅 적용 | |

| 서비스 디스커버리 연동 | 백엔드 서버 또는 서비스가 동적으로 변경될 경우 프록시 라우팅 오류 발생 | Consul, DNS SRV, Kubernetes 서비스 디스커버리 통합 연동 |

최적화하기 위한 고려사항 및 주의할 점

| 최적화 영역 | 항목 | 설명 / 고려사항 | 권장 전략 / 주의점 |

|---|---|---|---|

| 네트워크 처리 최적화 | 연결 재사용 (Connection Pooling) | Keep-Alive 또는 HTTP/2 기반의 연결 재활용로 지연 최소화 | 커넥션 풀 사이즈 제한, 타임아웃 설정, 백엔드/DB 대상 커넥션 관리 |

| 응답 캐싱 | 동일 요청에 대한 반복 응답을 캐싱하여 트래픽 및 백엔드 부하 감소 | ETag, Cache-Control, TTL 기반 캐싱 + Redis 등 외부 캐시 연계 | |

| 로드밸런싱 구조 최적화 | L4 vs L7 로드밸런싱, 프록시 클러스터 구성에 따른 병목 및 과도한 프록시 체인 방지 | 중첩 프록시 최소화, 정적 경로 분산과 동적 요청 구분, DNS 기반 분산 고려 | |

| 성능 자원 최적화 | 압축 처리 (GZIP 등) | 전송 데이터 크기를 줄여 대역폭 절감, 그러나 과도한 CPU 사용 유발 가능 | 콘텐츠 유형별 압축 조건 분리, 정적 리소스 우선 적용, Nginx GZIP on 설정 등 |

| 캐시 메모리 사용량 관리 | 캐시 크기 설정이 과도하면 메모리 부족, 부족하면 캐시 미스 증가 | 사용률 모니터링, LFU/LRU 기반 캐시 정책, 필요 시 동적 조정 적용 | |

| TLS 암호화 처리 부하 | TLS 핸드셰이크는 CPU 집약적이며 병목 지점이 될 수 있음 | TLS 전용 프록시 구성 또는 하드웨어 오프로드 카드 사용, Keep-Alive TLS 유지 | |

| 아키텍처 및 구성 구조 | 리버스 프록시 체인 복잡도 | 다단계 프록시 구성은 latency 증가 및 관리 복잡도 초래 | 불필요한 계층 제거, 기능 통합 또는 edge proxy + 내부 proxy 역할 구분 |

| 무중단 배포 (Zero-Downtime) | 설정 변경이나 배포 시 사용자 요청 단절 방지 | nginx -s reload, hot reload, Canary/Blue-Green 배포 전략 적용 | |

| 플러그인 / 모듈화 구성 | 보안, 인증, 캐시 기능의 커플링이 심할 경우 유연성 저하 | Lua, WASM, Envoy Filter 등 동적 플러그인 체계 구성 | |

| 운영 자동화 및 인프라 | 오토스케일링 (트래픽/로드 기반) | 트래픽 피크에 유연하게 대응하지 못하면 시스템 과부하 발생 | HPA (Horizontal Pod Autoscaler), KEDA, CPU/메모리 기반 정책 구성 |

| 분산 로깅 및 분석 | 대규모 트래픽 환경에서는 로그량이 폭발적으로 증가하여 수집과 분석에 병목 발생 | 중앙 로그 수집 (ELK, Loki), 로그 샘플링, 프라이버시 보호 (마스킹/익명화) 적용 | |

| 보안/프라이버시 성능 | 암호화 알고리즘 효율성 | 고강도 암호화일수록 보안성은 높지만 시스템 자원 요구도 증가 | AES-GCM, ChaCha20 등 경량 암호화 적용, 인증서 재활용 최적화 |

| 데이터 흐름 최적화 | 백엔드 쿼리 부담 완화 | 프록시가 요청 단에 캐시를 사용하지 않으면 모든 요청이 DB 나 API 로 전달됨 | GraphQL Federation, API 응답 캐싱, DB 쿼리 결과 캐싱 |

| 비동기 처리 | Blocking I/O 는 연결 대기 상태 증가로 처리량 저하 가능 | Event-driven 모델 채택 (async I/O, epoll, nginx event loop 등) |

네트워크 처리 최적화

연결 재사용 (Connection Pooling)

목적: 커넥션 생성 비용 최소화, 지연 감소

예시: Nginx 리버스 프록시가 백엔드 API 서버와 지속 연결 유지 (keepalive)

주의점: 백엔드 서버도 Keep-Alive 를 지원해야 효과적

응답 캐싱 (Response Caching)

목적: 반복 요청에 대한 응답 시간 감소

예시: 이미지, JS, API 응답을 10 분간 캐시

| |

고급 예시: Cache-Control, ETag, Vary 헤더 기반 조건부 캐싱 지원

로드밸런싱 구조 최적화

목적: 부하 분산, 비정상 노드 자동 제거

예시: HAProxy 로 동적 라운드로빈 + 서버 헬스체크 구성

예시: NGINX

성능 자원 최적화

압축 처리 (GZIP, Brotli 등)

목적: 응답 크기 감소로 네트워크 최적화

예시: 정적 파일에 GZIP 압축 적용

주의: 이미지, 영상 등 이미 압축된 리소스는 제외해야 오히려 성능 개선

캐시 메모리 사용량 관리

목적: 메모리 과다 사용 방지 + 적중률 유지

예시: Nginx 캐시 저장소 용량 제한 및 LRU 정책 적용

| |

예시: Redis 기반 캐시 연계 예시 (FastAPI)

| |

TLS 암호화 처리 부하 최적화

목적: 핸드셰이크 병목 해소, CPU 사용량 절감

예시: Nginx 에서 TLS 처리 최적화 + 세션 재사용

하드웨어 최적화: TLS 오프로드 장비 혹은 Envoy + BoringSSL 연계

추가 참고

| 최적화 항목 | 실무에서 고려할 사항 |

|---|---|

| Keep-Alive | 클라이언트와 서버 모두 지원 필요, timeout 조절로 커넥션 과다 방지 |

| 캐시 정책 | 캐시 키 기준 정밀 제어 필요 (URI + 헤더 등) |

| TLS 처리 | TLS 재암호화가 필요한지 여부 판단 (프라이버시 vs 성능) |

| 비동기 처리 | Proxy 시스템 자체는 이벤트 기반 (Nginx, Envoy 등), 백엔드 병목 확인 |

주목할 내용

| 카테고리 | 주제 | 핵심 항목 | 설명 |

|---|---|---|---|

| 1. 아키텍처 구조 | 순·역방향 프록시 구조 | 위치 및 역할 차이 | Forward: 사용자 측 요청 필터링 / Reverse: 서버 보호 및 트래픽 제어 |

| Reverse Proxy 컴포넌트 | 서버 앞단에서 트래픽을 제어하는 구성 요소 | API Gateway, Load Balancer, 인증 프록시 등 포함 | |

| 서비스 메시 | Istio, Envoy 기반 마이크로서비스 통신 프록시화 | 사이드카 방식으로 프록시를 각 서비스와 연계 | |

| 2. 성능 최적화 | 콘텐츠 캐싱 | 응답속도 향상, 대역폭 절약 | 빈번한 요청에 대한 응답을 캐싱하여 네트워크 부하 감소 |

| 엣지 프록시 | 사용자 가까운 위치에서 요청 처리 | Edge Location 에서 지연 시간 최소화 | |

| 지능형 라우팅 | 머신러닝 기반 트래픽 분석 및 최적 경로 선택 | 예측 기반 분산 트래픽 제어 | |

| 3. 보안 및 인증 | TLS 종료 | SSL 처리 부하를 프록시가 대신 수행 | 백엔드는 HTTP 만 처리하도록 구성 가능 |

| 접근제어 정책 운영 | 사용자/그룹/경로 기반 허용 및 차단 정책 | RBAC, ABAC 기반 통제 정책 적용 | |

| 제로 트러스트 모델 | 모든 요청을 신뢰하지 않고 검증 | 프록시가 인증/인가 및 정책 평가 역할 수행 | |

| 4. 자동화 및 운영 | 자동화된 설정 관리 | IaC 기반 프록시 인프라 구성 및 유지 | Terraform, Ansible 등 도구 활용 |

| 장애 복구/이중화 | 고가용성, 트래픽 전환 시 무중단 구성 | 다중 프록시 구성 + 헬스체크 연동 | |

| 요청/응답 로깅 | 사용자 행동 추적 및 이상 탐지 데이터 제공 | 관찰 가능성 (Observability) 향상 | |

| 5. DevOps 연계 | API Gateway 연계 | 인증, 속도 제한, 라우팅 등의 정책 확장 | 프록시와 API 게이트웨이를 결합하여 API 중심 제어 |

| 서버리스 프록시 | Lambda@Edge, Cloudflare Workers 등에서 프록시 역할 수행 | 서버리스 환경에서 보안/라우팅/변환 처리 | |

| 6. 표준 및 기술 발전 | HTTP/3 지원 | QUIC 기반 차세대 프로토콜에서 프록시 역할 | 전송 속도 향상 및 연결 지연 최소화를 위한 대응 필요 |

요약 정리

| 구분 | 내용 요약 |

|---|---|

| 핵심 기능 구조 | Forward/Reverse Proxy, Service Mesh 구성 차이 분석 |

| 성능 향상 전략 | 캐싱, 엣지 위치 배치, AI 기반 라우팅 적용 가능성 반영 |

| 보안 강화 방식 | TLS 종료, 접근제어, 제로 트러스트 기반의 인증·인가 구현 |

| 운영 자동화와 연계 | IaC 기반 자동화, 고가용성 구성, 로깅 및 관찰 가능성 강화 |

| 최신 기술 트렌드 | HTTP/3, 서버리스, AI 기반 라우팅, 서비스 메시 등 진화하는 프록시 환경에 적응 필요 |

반드시 학습해야할 내용

| 카테고리 | 주제 | 핵심 항목 | 설명 |

|---|---|---|---|

| 프록시 구조 및 동작 이해 | Forward vs Reverse Proxy | 구조와 동작 방식, 목적 비교 | 데이터 흐름 방향과 사용 시나리오 구분 (클라이언트 보호 vs 백엔드 보호) |

| OSI 계층 기반 프록시 분류 | L4 (TCP), L7 (HTTP) 프록시 구분 | 계층에 따른 기능 차이 (라우팅 vs 콘텐츠 필터링), 적용 위치 구분 | |

| Proxy 서버 종류 및 비교 | NGINX, HAProxy, Envoy | 오픈소스 프록시 서버들의 특성 및 사용 목적별 비교, 설정 방식 이해 | |

| 프로토콜 및 암호화 | HTTP/HTTPS 구조 이해 | 메시지 구성, 헤더/메서드 조작 | HTTP 요청/응답 흐름 파악, 프록시 레벨에서 헤더 가공/삭제 처리 |

| TLS/SSL 인증서 처리 | 인증서 체인, 암호화 핸드셰이크 이해 | HTTPS 트래픽의 프록시 처리 방식 및 SSL 종료 구조 학습 | |

| 인증/인가 흐름 | 접근 정책, RBAC, JWT 등 | 사용자별 인증/인가 정책 처리 및 프록시 계층에서의 접근 제어 구현 | |

| 아키텍처 및 성능 최적화 | 로드 밸런싱 알고리즘 | Round-Robin, Least Conn, Weight 등 | 트래픽 분산 전략의 종류 및 선택 기준, HA 구현을 위한 이중화 아키텍처 설계 |

| 캐싱 전략 | TTL, LRU, ETag, Cache-Control | 콘텐츠 캐싱 최적화 방식, 프록시에서의 캐시 무효화 처리 | |

| 트래픽 최적화 및 스케일링 | Keep-Alive, GZIP, 오토스케일링 | 연결 재사용, 압축, 동적 확장으로 시스템 성능 및 자원 사용 최적화 | |

| 보안 및 개인정보 보호 | TLS 종료 및 재암호화 | 프록시에서의 HTTPS 처리 방식 | 보안 통신을 위한 SSL Termination 구성, Re-encryption 고려 |

| 개인정보 마스킹 및 감사 대응 | 로그 필터링, 데이터 보호 정책 적용 | 프록시 단계에서 로그 유출 방지, 민감 데이터 처리 컴플라이언스 대응 | |

| 공격 대응 및 방화벽 연계 | WAF, DoS 차단, 인증서 위조 방지 | 프록시 + 보안 기능 결합으로 OWASP Top 10 대응 및 트래픽 보호 | |

| 구현 기술 및 운영 자동화 | 설정 자동화 및 배포 전략 | Helm, Kustomize, GitOps | 환경별 프록시 설정 자동화 및 무중단 배포 구성 |

| 프록시 구성 자동화 | Nginx config 템플릿, Envoy 필터 체계 | 코드 기반 구성 및 정책 일관성 확보 | |

| 무중단 배포 및 설정 리로드 | Reload 지원 여부, Canary 배포 | 설정 변경 시 서비스 단절 방지 전략, 프로덕션 반영 시 안전한 배포 흐름 | |

| 모니터링 및 진단 | 메트릭 수집 및 대시보드 | 처리량, 에러율, 응답 시간 등 | Prometheus, Grafana 연동으로 프록시 상태 및 성능 추적 |

| 로깅 및 트러블슈팅 | Request/Response 로그 추적 | 로그 기반 요청 흐름 분석 및 이슈 원인 진단 (예: X-Forwarded-For, Trace ID) | |

| 장애 대응 및 이중화 구성 | Active-Active 구성, Health Check | 장애 발생 시 대체 경로로 자동 전환되는 구조 및 장애 조기 감지 전략 | |

| 정책 및 규정 준수 | 접근 제어 정책 설계 | 사용자/리소스 기반 정책 구성 | RBAC, 정책 기반 접근제어 (PBAC) 등 적용 사례 |

| 컴플라이언스 대응 | GDPR, CCPA, 내부 감사 | 프록시 수준에서의 법적 요구사항 대응 (로그 마스킹, 저장 위치 등) |

요약 정리

| 항목 | 설명 요약 |

|---|---|

| 프록시의 동작 및 구조 | Forward/Reverse 구분, OSI 계층별 기능 이해, 프록시 서버 유형 비교 필요 |

| 프로토콜 및 보안 이해 | HTTP/TLS 메시지 구조, 인증서 관리, 접근 제어 정책 등의 보안 흐름 숙지 필요 |

| 아키텍처 및 최적화 전략 | 로드밸런싱, 캐싱, GZIP, 연결 재사용 등 성능 향상을 위한 전략 학습 필요 |

| 보안 및 개인정보 대응 | TLS 종료, 데이터 마스킹, 공격 차단 등 보안 및 컴플라이언스 대응 필수 |

| 운영 자동화 및 배포 | 설정 코드화, GitOps 기반 운영, 설정 리로드/무중단 배포 전략 이해 필요 |

| 모니터링 및 장애 진단 | 메트릭, 로깅, 장애 시 이중화 구성 및 트러블슈팅 역량 확보 필요 |

| 정책 및 감사 준수 체계 | 정책 설계, 감사 로그 대응, 법적 규정 (GDPR 등) 대응 역량 요구됨 |

용어 정리

| 카테고리 | 용어 | 설명 |

|---|---|---|

| 프록시 구조 및 유형 | Forward Proxy | 클라이언트 요청을 외부 서버로 대신 전달하는 중개 서버 |

| Reverse Proxy | 외부 요청을 내부 서버로 전달하는 서버 측 중개자 | |

| Explicit Proxy | 클라이언트가 명시적으로 프록시를 설정 | |

| Transparent Proxy | 클라이언트가 인식하지 못하는 방식으로 요청을 가로채는 프록시 | |

| SOCKS Proxy | TCP/UDP 기반의 범용 프록시 프로토콜 | |

| API Gateway | 인증, 라우팅, 속도제한 등을 수행하는 특수 리버스 프록시 | |

| Service Mesh | 사이드카 기반으로 마이크로서비스 간 통신을 프록시로 제어하는 구조 | |

| 보안 및 암호화 | SSL Termination | 암호화된 연결을 프록시에서 해제하여 백엔드는 평문 처리 |

| SSL Passthrough | 암호화된 연결을 프록시에서 해제하지 않고 백엔드까지 전달 | |

| SSL Bridging | 프록시에서 복호화한 뒤 백엔드와 재암호화 통신 | |

| WAF (Web Application Firewall) | 애플리케이션 보안 위협을 탐지 및 차단하는 웹 방화벽 | |

| IDS/IPS | 침입 탐지 및 방지 시스템, 위협 탐지 시 연동 차단 가능 | |

| TLS | 전송 계층 보안을 위한 암호화 프로토콜 (HTTPS 기반) | |

| Zero Trust | 모든 연결을 기본적으로 불신하고, 지속적인 검증을 요구하는 보안 모델 | |

| ACL (Access Control List) | 접근 권한을 IP, 사용자 등에 따라 제어하는 보안 정책 리스트 | |

| 성능 및 최적화 | Caching | 자주 요청되는 데이터를 저장하여 응답 시간 및 트래픽 최적화 |

| TTL (Time To Live) | 캐시의 유효 기간을 나타내는 설정 값 | |

| Cache Hit Rate | 캐시된 요청이 전체 요청에서 차지하는 비율 | |

| Compression Ratio | 전송 데이터 압축 효율을 나타내는 지표 | |

| ETag | 콘텐츠 변경 여부를 판단하는 식별자 | |

| 네트워크 및 라우팅 | Load Balancing | 여러 서버에 네트워크 요청을 분산하여 처리 |

| Round Robin | 순차적으로 서버에 요청을 분배하는 로드 밸런싱 알고리즘 | |

| Sticky Session | 특정 클라이언트 요청을 동일 서버로 라우팅 유지 | |

| Health Check | 백엔드 서버의 가용성 및 상태 확인 | |

| Connection Pooling | 재사용 가능한 연결을 유지하여 연결 오버헤드 감소 | |

| URL Rewriting | 요청된 URL 을 내부 서비스 URL 로 변환하는 기능 | |

| Upstream | 프록시에서 백엔드로 가는 트래픽 방향 | |

| Downstream | 클라이언트에서 프록시로 들어오는 트래픽 방향 | |

| Backend Pool | 로드 밸런싱 대상으로 묶인 서버 그룹 | |

| 인프라 및 확장 기술 | CDN (Content Delivery Network) | 콘텐츠를 사용자 가까운 엣지 서버에서 제공하여 지연 최소화 |

| Edge Computing | 사용자 근처에서 데이터 처리를 수행하는 분산 아키텍처 | |

| Serverless | 서버 인프라를 직접 운영하지 않고 코드 단위로 배포/실행 | |

| FaaS (Function as a Service) | 이벤트 기반 함수 실행 모델로 서버리스의 세부 형태 | |

| WebAssembly (WASM) | 브라우저 또는 프록시에서 고성능 코드 실행을 위한 바이너리 포맷 | |

| eBPF (extended BPF) | 리눅스 커널 내에서 고성능 네트워킹 및 트래픽 필터링을 수행 | |

| HTTP/3 | QUIC 프로토콜 기반의 고속/보안 HTTP 프로토콜 | |

| QUIC | UDP 기반 전송 계층 프로토콜, 빠른 연결 성립 및 멀티플렉싱 지원 | |

| SDN (Software Defined Network) | 소프트웨어 기반으로 네트워크 경로를 정의하고 제어하는 기술 | |

| HAProxy | 고성능 TCP/HTTP 기반 로드 밸런서 및 프록시 서버 | |

| DDoS (Distributed DoS) | 프록시 앞단에서 감지 및 완화 가능한 분산 서비스 거부 공격 |

요약 정리

| 분류 | 요약 내용 |

|---|---|

| 프록시 구조 | Forward/Reverse Proxy, API Gateway, Service Mesh 등 다양한 구조를 이해해야 하며, 명시적/투명 프록시 구분도 중요 |

| 보안 기능 | SSL 처리 방식 (Termination, Passthrough, Bridging), WAF, TLS, Zero Trust, ACL 등 보안 계층 강화에 중추적 역할 |

| 성능 최적화 | 캐싱, TTL, 압축률, ETag 등을 통한 응답 최적화 및 트래픽 감소 전략 필요 |

| 트래픽 제어 | 로드 밸런싱, 헬스 체크, URL 재작성, 세션 지속성 등을 통한 안정적인 라우팅 구성 |

| 인프라 확장성 | CDN, Edge, WASM, eBPF, Serverless 기술을 기반으로 프록시의 위치와 기능을 지능적으로 확장 가능 |

| 최신 프로토콜 | HTTP/3, QUIC, SDN 등을 통한 미래 지향적 네트워크 프록시 기술 적용 가능성 확보 |

참고 및 출처

- Cloudflare 프록시 서버 설명

- Cloudflare 리버스 프록시 설명

- Cloudflare – What is a Proxy Server?

- Cloudflare – Reverse Proxy Explained

- NGINX 공식 리버스 프록시 가이드

- NGINX – What is a Reverse Proxy?

- AWS 리버스 프록시 아키텍처

- AWS Application Load Balancer 사용자 가이드

- AWS 로드 밸런싱 설명

- AWS 엘라스틱 로드 밸런싱 문서

- AWS – API 게이트웨이 설명

- AWS WAF 소개

- HAProxy 아키텍처 다이어그램

- HAProxy 공식 문서

- HAProxy 문서

- Squid 프록시 서버 위키

- Squid 프록시 문서

- Apache Traffic Server 문서

- Privoxy 문서

- mitmproxy 문서

- Envoy 프록시 공식 문서

- Envoy 프록시 문서

- Kong API 게이트웨이 문서

- Traefik 프록시 문서

- Istio 서비스 메시 문서

- Kubernetes Ingress 문서

- Cloudflare 제로 트러스트 보안 모델

- CNCF 서비스 메시 아키텍처

- HTTP/3 및 QUIC RFC 문서

- IETF HTTP/1.1 메시지 표준 (RFC 7230)

- Mozilla SSL 설정 가이드

- OWASP 프록시 보안 가이드

- OWASP HTTP Strict Transport Security Cheat Sheet

- OWASP Secure Proxy Implementation

- Web Proxy – MDN Web Docs

- GeeksforGeeks Web Proxy 개요

- StrongDM Forward vs Reverse Proxy 차이

- Guru99 Forward vs Reverse Proxy 비교

- Nashtech 클라우드 프록시 아키텍처

- IBM Cloud – 리버스 프록시와 로드 밸런서

- Mozilla Developer Network – 프록시 서버 설명

- Proxy Server란? – Cloudflare Learning

- Cloudflare – Reverse Proxy Glossary

- Cilium eBPF 네트워킹

- Snowflake Unistore 소개